论文地址:https://arxiv.org/abs/2203.07363

代码地址:https://xueliancheng.github.io/SLT-Net-project/

导读

本文提出了一种新的视频伪装对象检测框架,该框架可以利用短期动态性和长期时间一致性从视频帧中检测伪装对象。伪装物体的一个基本特性是,它们通常表现出与背景相似的模式,因此很难从静止图像中识别出来。因此,有效处理视频中的时间动态成为VCOD任务的关键,因为伪装对象在移动时会很明显。

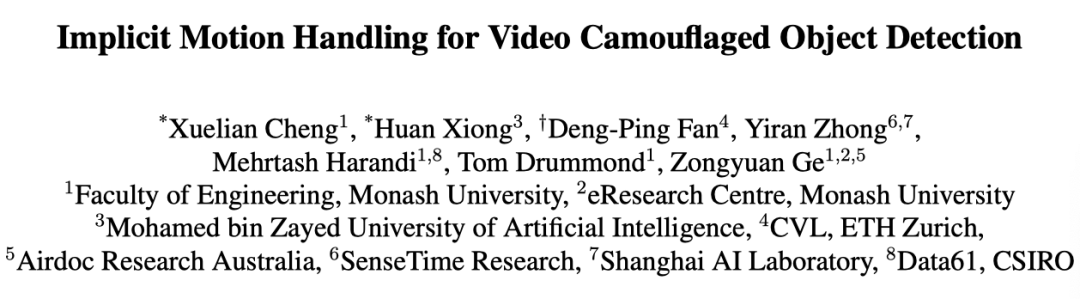

然而,当前的VCOD方法通常利用单应性或光流来表示运动,其中检测误差可能来自运动估计误差和分割误差。另一方面,本文的方法在单个优化框架内统一了运动估计和对象分割。

具体来说,作者构建了一个密集的关联体来隐式捕捉相邻帧之间的运动,并利用最终分割监督来联合优化隐式运动估计和分割。此外,为了加强视频序列内的时间一致性,作者联合使用时空Transformer来细化短期预测。

在VCOD基准上的大量实验证明了本文方法的架构有效性。作者还提供了大规模VCOD数据集——MoCA-Mask,该数据集使用像素级手工制作的Ground Truth掩模,并与以前的方法构建一个全面的VCOD基准,以促进这一方向的研究。

贡献

视频伪装目标检测(VCOD)是在视频中发现与背景场景有很大相似性的对象的任务。尽管有着广泛的应用(例如,监视和安全、自动驾驶、医学图像分割、蝗虫检测和机器人),但伪装物体检测(COD)的问题是一项艰巨的任务,因为伪装物体通常肉眼无法区分。与视频对象检测(VOD)、视频显著对象检测(VSOD)和视频运动分割(VMS)等几个相关问题相比,这反过来又使VCOD成为计算机视觉中一个相对未被探索的问题。

在大多数计算机视觉任务中(例如,实例分割、显著性检测),假设对象具有清晰的边界。这使模型能够在图像级别建模问题,甚至在运动信息可用的情况下考虑改进。相比之下,在检测伪装对象时,对象边界是模糊和不可区分的。这不仅使从图像中进行检测具有挑战性,而且会导致检视频中光流和运动线索的不准确估计。

缺乏清晰的边界意味着伪装对象的外观与背景相似。这表现为两个难点:1)对象边界通常无缝地融合到背景中,并且仅当对象移动时才可见;2) 物体通常具有与环境相似的重复纹理;因此,确定像素跨帧的运动以估计运动(例如,在光流中所做的运动)是不稳定和错误的。

作为第一个难点,要成功解决视觉伪装,神经网络需要借助运动信息有效地发现伪装对象和背景之间的细微差别。此外,根据第二个困难,运动信息本身具有噪声和不精确性,如上图所示。因此,如果单纯地使用或结合使用VOD,VSOD,VMS来解决视频VCOD问题,可能会失败。

在这项工作中,作者提出了SLT-Net,这是一种解决VCOD的新方法,该方法利用短期动态和长期时间一致性来检测视频中的伪装对象。具体来说,作者使用短期动态模块来隐式捕获连续帧之间的运动。做事不是使用光流来显式表示运动,而是使用全范围关联金字塔策略来隐式表示运动。

使用关联金字塔的主要动机是,即使是SOTA光流算法也无法估计伪装物体的运动,并且它们的误差会在视频的持续时间内累积。此外,它能够仅通过检测监督来共同优化运动估计 (隐式) 和预测。为了提供稳定的估计,作者进一步引入了长期细化模块,以减轻短期动态模块中的累积误差。

作者将SLT-Net实现为具有Transformer和CNN组件的混合神经网络。特别是,作者使用Transformer结构来编码构造关联金字塔的特征。除了其设计灵活性外,Transformer提取的特征还包含具有长距离依赖性和较少归纳偏置的全局上下文信息,作者观察到在估计运动时更容易区分。

虽然关联金字塔策略可以有效捕获运动以检测伪装对象,但由于其计算复杂性,它无法优雅地扩展到长视频序列。为了解决这个问题,作者采用了一种带有时空Transformer的序列到序列模型来改进视频中具有长期一致性的成对预测,因为作者经验性地发现它比标准的ConvLSTM模型更精确。

此外,作为一个探索较少的问题,无法使用大规模数据集来评估和基准VCOD系统。为了促进这一领域的新发展,作者策划了一个基于移动伪装动物(MoCA)的大规模VCOD数据集。新的数据集,简称MoCA-Mask,包含87个视频序列,共22939帧,带有像素级Ground Truth掩码。MoCA-Mask封装了各种挑战,例如复杂的背景和微小且伪装良好的物体。作者为数据集中的所有视频每五帧提供标注、边界框和密集分割掩码。作者还为现有的VCOD方法提供了第一个全面的基准。

简而言之,本文的贡献如下:

- 作者提出了一种新的VCOD框架,该框架可以有效地建模视频的短期动态和长期时间一致性,其中运动和伪装对象分割可以通过单个优化目标进行联合优化。

- 作者收集了第一个大规模VCOD数据集,即MoCA-Mask数据集,以促进VCOD的发展,并收集了一个全面的VCOD基准,以促进VCOD的研究。

- 作者在VCOD任务上设定了一个新的最先进水平,比以前的SOTA方法高出9.88%。

方法

SLT-Net的输入是包含伪装对象的视频片段,输出是一组视频中每个帧的伪装对象的像素级二进制掩码。具体地,{It}t=1T表示具有T帧的视频片段,其中H,W是帧的高度和宽度。本文的网络是在时间t为视频帧T2分配一个二进制掩码Mt。

1. Overview

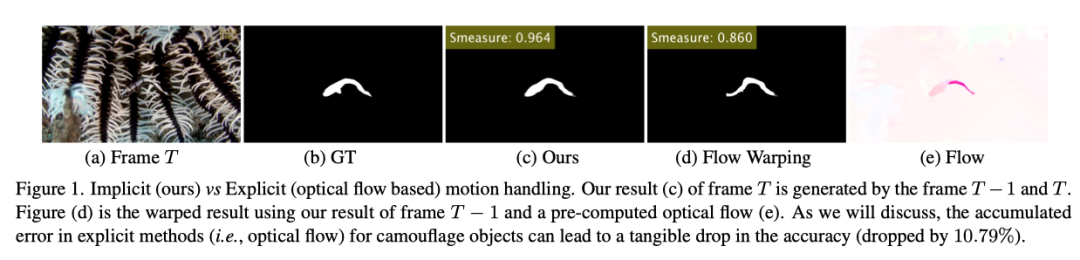

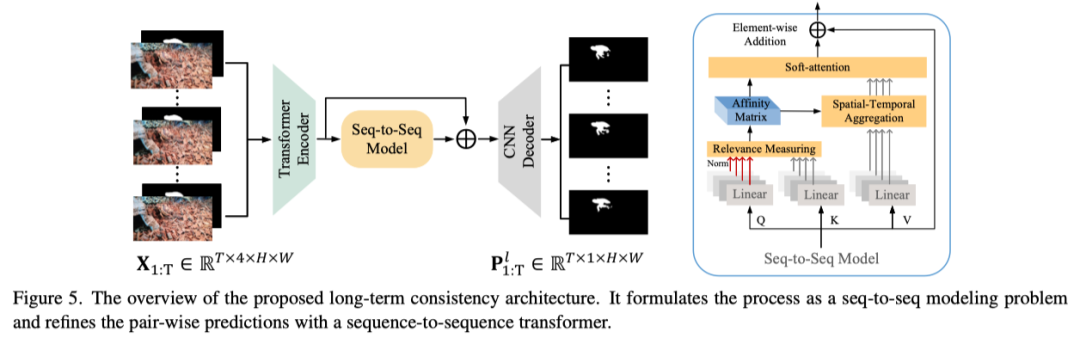

SLT-Net的总体框架如上图所示。SLT-Net由短期检测模块和长期细化模块组成。短期检测模块获取一对连续帧,并预测参考帧的伪装对象掩码。序列到序列Transformer模块适用于使用时间一致性先验联合细化输入视频片段结果。它从短期检测模块中获取T个预测及其相应的参考帧,以生成最终的预测结果。本文是第一个将这种密集预测细化过程表述为序列到序列建模问题的工作。

为了训练SLT-Net,作者采用了两阶段策略。首先只使用像素标注来训练短期检测模块。一旦模型收敛,作者将长期细化模块连接到SLT-Net,并在固定短期检测模块的同时训练整个模型。

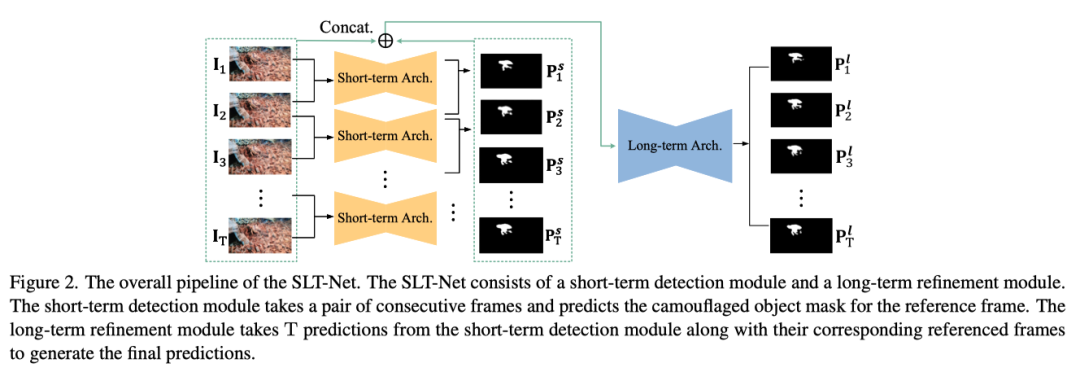

2. Short-term Architecture

上图说明了本文的Short-term架构。它将两个连续帧作为视频的输入,并预测参考帧的二进制掩码。本文的模型包括三个主要模块:(1)用于特征提取的Transformer编码器;(2) 用于捕捉短期动态的短期关联金字塔;和(3)预测短期分割的CNN解码器。下面介绍每个模块的详细信息。

Transformer Encoder

作者采用带有金字塔视觉Transformer(PVT)的孪生结构来提取来自两个连续帧的特征。编码器由四个阶段组成,以四种不同的比例生成特征图。所有阶段共享类似的结构,包括patch嵌入层和Transformer块。

每个阶段的特征尺寸为

其中H,W,C表示高度,宽度和通道。在实验中设置C=32。作者针对最后三个阶段的特征采用了三个纹理增强模块(TEM)。为了获得更具区分性的特征表示,每个TEM包含四个平行的残差分支。

Short-term Correlation Pyramid

先前的工作通过将连续帧的光流作为深度网络的输入来明确地纳入运动。然而,不准确的光流可能会导致后续预测中的误差累积。如果想联合优化光流模块和分割模块,则需要光流的ground truth。

为了解决这个问题,作者提出了一种关联金字塔来隐式捕捉运动信息。如上图所示,CNN解码器直接将关联金字塔作为其唯一输入。这意味着网络只能通过正确的运动估计来估计正确的分割。此外,由于用于形成关联金字塔的特征将随分割ground truth更新,因此可以使用分割ground truth来联合优化运动估计和检测结果。

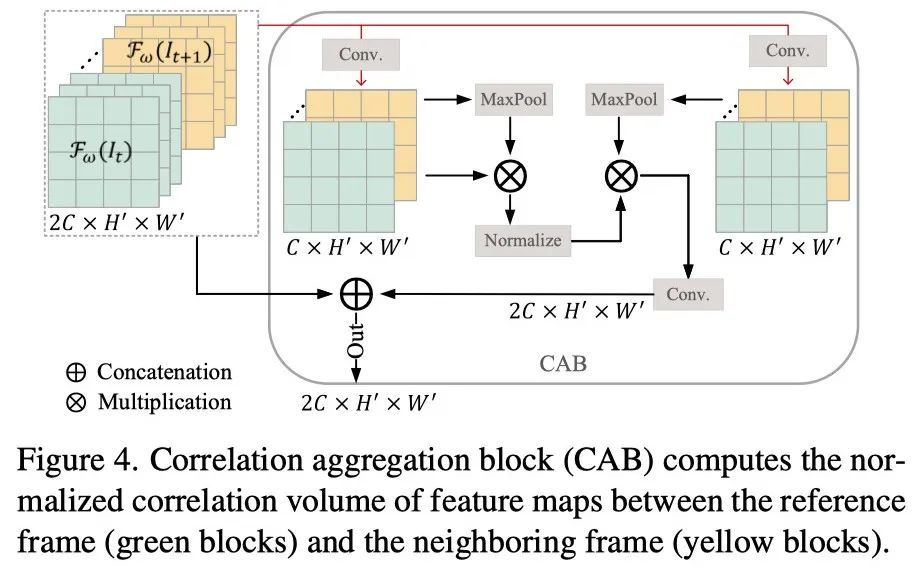

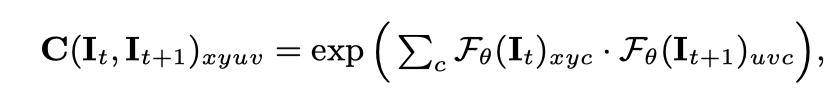

作者在上图中说明了关联金字塔的核心单元,即相关聚合块(CAB)。给定一对帧特征,4D关联体C()定义为:

c是帧特征沿通道维度的索引。当所有相邻特征与相关性配对时,可以在全局范围内找到对应关系。为了降低计算复杂度,作者在保持参考帧分辨率的同时,通过特征上的最大池化来减少相邻帧的采样。这种设计有助于模型学习多尺度位移,同时保持高分辨率图像细节。

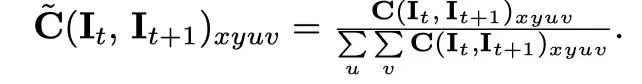

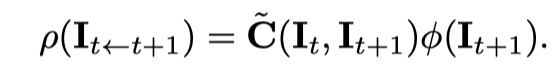

接下来,作者沿最后二维uv在其和上归一化特征相关体C(It,It+1)xyuv,因为它们表示所有空间位置中参考和下采样相邻特征帧之间的对应关系。归一化相关体计算如下:

作者应用卷积运算来选择性地考虑通道信息,从而获得精细的特征映射。具体而言,聚合特征计算为:

上图仅显示了一个尺度上的相关性。为了使网络学习更详细的信息,作者构造了一个关联金字塔,合并从transformer编码器中提取的多尺度特征。

CNN Decoder

相邻连接解码器比传统连接解码器(即密集连接或短连接)更可靠。此外,之前工作使用的组反转注意(GRA)策略可以在对象边界周围提供更准确的分割结果。在此基础上,作者直接从短期关联金字塔中提取特征,即, 并生成细化的特征图。

邻域连接解码器(NCD)用于生成粗映射,该粗映射可以提供伪装对象粗略位置的反向引导。通过这种方式,从CNN解码器收集低层特征,从关联金字塔收集高层特征。

Learning Strategy

作者通过最小化以下损失来训练短期训练阶段:

加权交叉熵损失Lce增加了难像素的权重,以强调其重要性。联合损失Liou上的加权交集更关注难像素,而不是为所有像素分配相等的权重。

3. Long-term Consistency Architecture

给定一个序列I1:T和从短期架构P1:T中的像素级预测,作者将长期一致性细化过程建模为一个顺序到顺序的问题。上图说明了长期一致性架构。作者使用与短期架构相同的主干,即transformer编码器和CNN解码器模块,因为它已经在伪装数据集上进行了预训练,可以大大加快长期训练过程。

对于输入序列的每一帧,作者将颜色帧It与其相应的预测通道P维度上concat起来,然后堆叠序列中的每个concat帧,以形成4D张量X1:T。该网络以作为输入X1:T,并输出最终预测序列。

有两种序列到序列建模架构:一种使用convLSTM对时间信息进行建模,另一种使用基于Transformer的序列到序列建模网络。作者分别实现了这两种架构,并比较了它们的结果。作者发现,使用transformer结构可以获得更好的结果,因此选择它作为本文的序列到序列建模网络,以增强长期一致性。

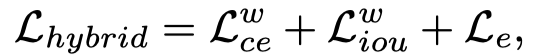

作者在上图的右侧显示了序列到序列建模网络的详细信息。对于每个目标像素,为了降低构建密集时空亲和矩阵的复杂性,作者选择固定数量的相关性度量块在其约束邻域内构建亲和矩阵。在训练期间应用混合损失:

其中,Le是增强的对齐损失,混合损失可以引导网络学习像素级、对象级和图像级特征。

实验

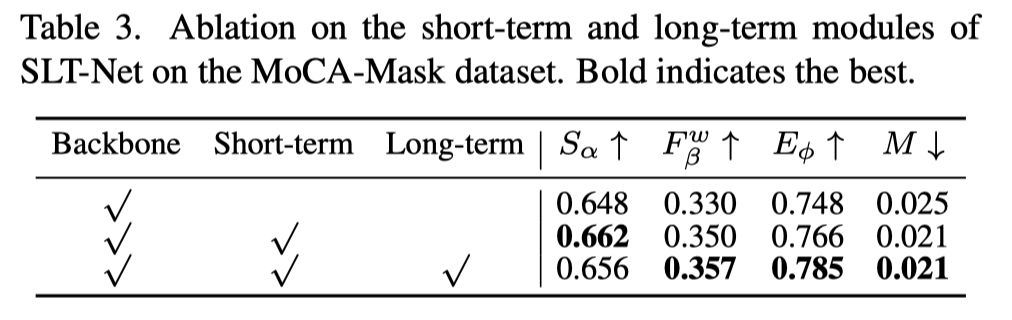

作者从两个方面评估了短期和长期模块的有效性。首先在MoCA-Mask数据集上对短期和长期模块进行消融研究,结果如上表所示。

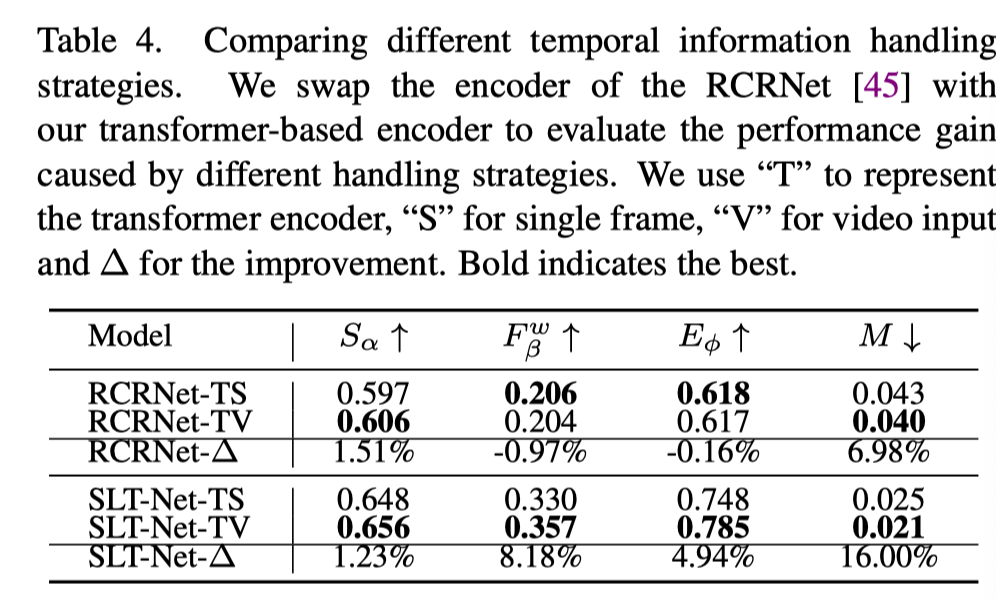

作者将SOTA VSOD方法RCRNet的编码器与基于Transformer的编码器交换,以比较本文方法中RCRNet之间时间信息处理策略的有效性,结果如上表所示。

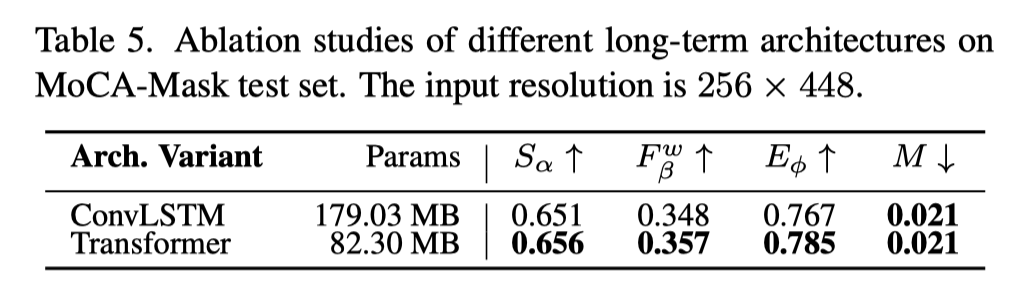

作者评估了构建长期架构的两种不同方法,即基于transformer的模型和基于ConvLSTM的模型。从上表中可以看出,transformer变体在所有四个指标上都比ConvLSTM模型更精确,参数数量要少得多。

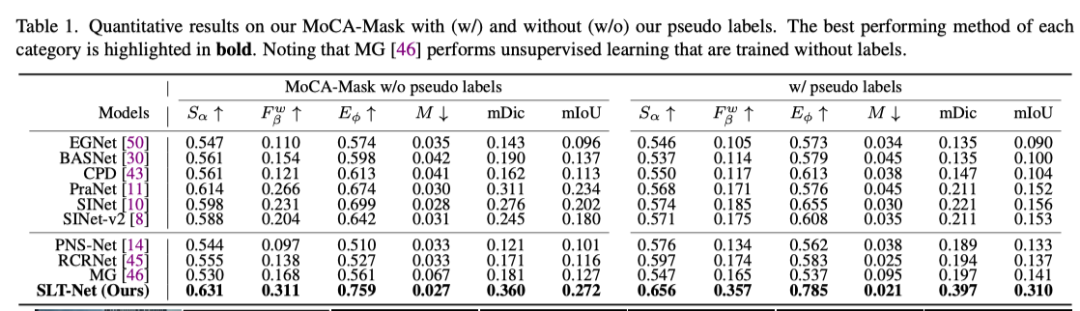

如上表所示,虽然生成的伪标签包含一些噪声,但它们可以提高视频方法的性能,因为它们可以利用时间信息来抑制标签噪声。

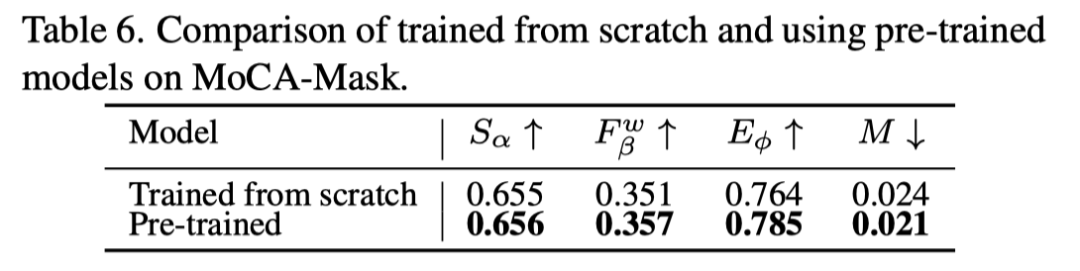

为了完整性,在表中作者提供了带/不带预训练权重的网络的准确性。

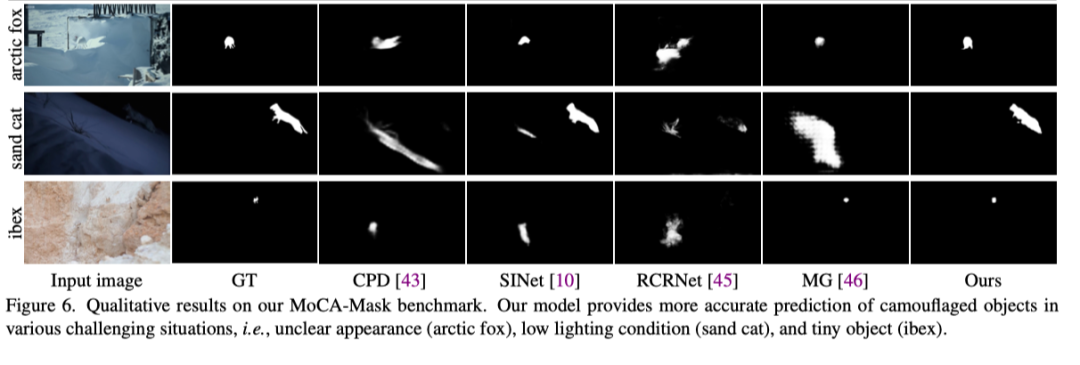

上图展示了不同方法在MoCA-Mask基准的定性结果。

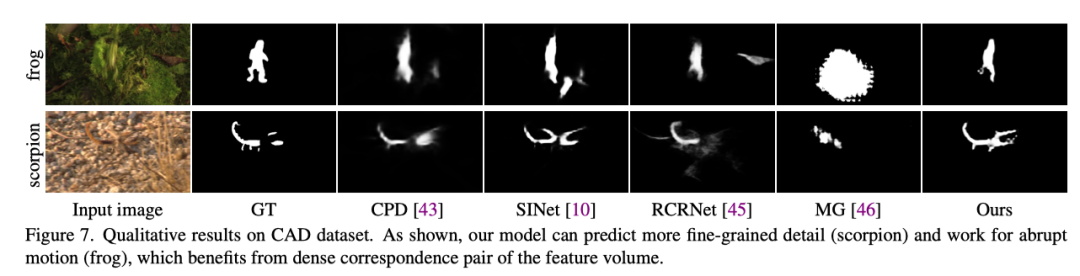

上图展示了在CAD数据集上的定性结果。

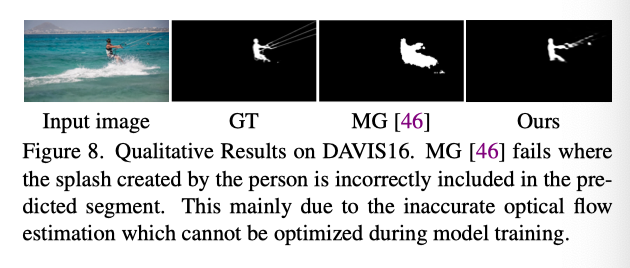

上图展示了在DAVIS16数据集上的定性结果。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢