本文是对快手和浙大联合研究的视频OCR领域工作的简要介绍,包括 CoTex【Real-time End-to-End Video Text Spotter with Contrastive Representation Learning】和 SVRep【Contrastive Learning of Semantic and Visual Representations for Text Tracking】,其中CoText被ECCV2022录用,SVRep作为前作未出版,本文后续统一用CoText作为简称。这篇文章介绍的基于对比学习和多信息融合的视频OCR模型,主要特点是能够准确、高效的跟踪和识别视频中的文字,目前在ICDAR2015-Video in Text 等多个开源数据集实现SOTA。完整的代码已经开源,我们会在文本附上链接。

文章链接:

●CoText:https://arxiv.org/abs/2207.08417

●SVRep:https://arxiv.org/abs/2112.14976

代码链接:

https://github.com/weijiawu/CoText

CoText 算法架构

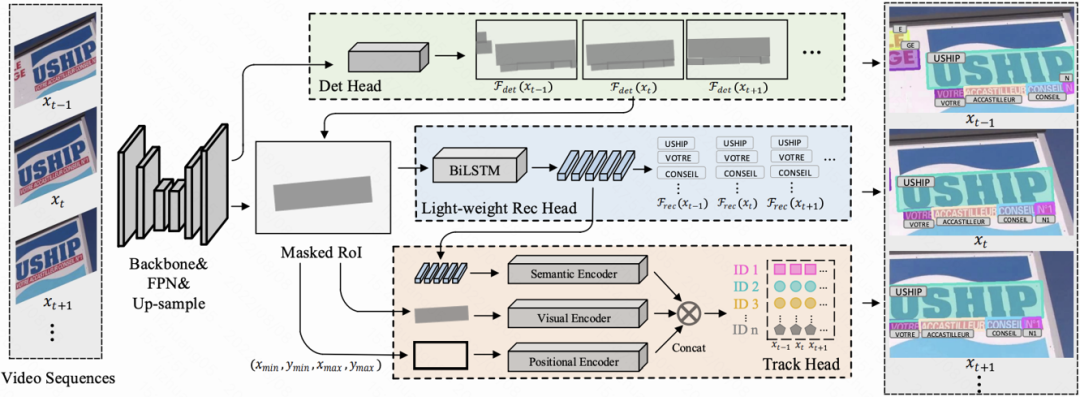

本文提出了一个基于对比学习和多信息表征的端到端视频OCR模型CoText,与现有的方法相比,CoText主要有4点贡献:

● 实现了一个统一的轻量级的框架,同时处理检测、跟踪、识别三个子任务,做到端到端可训练

● 提出了三种轻量级特征编码结构:Visual Encoder、Semantic Encoder和Position Encoder去学习文字的视觉表示、语义表示和位置表示,让模型 “像人类一样“ 去跟踪和识别文字

● 不同于先前工作(只利用两帧,做前后关联比对),CoText基于对比学习,在多信息特征空间同时学习多帧的时序信息

● CoText在4个开源数据集实现SOTA,并具有更快的推理速度。其中,在ICDAR2015 Video数据集下,CoText到达了72.0%的IDF1,相比先前的SOTA算法提升10.5%的同时,推理速度为其4倍

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢