在过去的几年里,我们在将机器学习应用于机器人技术方面取得了重大进展。然而,今天的机器人系统只能执行非常短的、硬编码的命令,例如“拿起苹果”,因为它们往往在明确的任务和奖励下表现最好。他们努力学习执行长期任务和推理抽象目标,例如“我刚刚锻炼,你能给我一份健康的零食吗?”这样的用户提示。

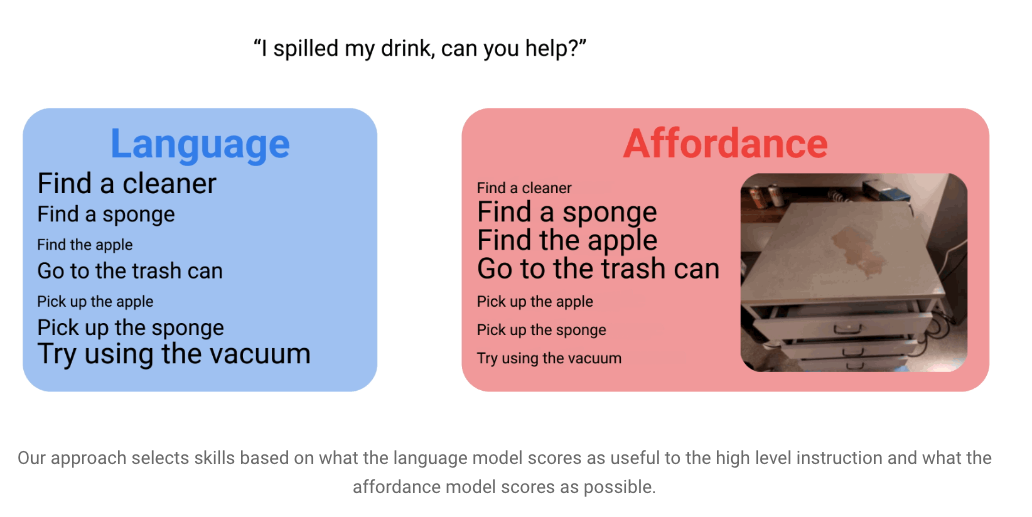

同时,最近在训练语言模型 (LM) 方面取得的进展使系统能够执行广泛的语言理解和生成任务,并取得了令人印象深刻的结果。然而,由于训练过程的性质,这些语言模型本质上并不基于物理世界:语言模型通常不会与其环境交互,也不会观察其响应的结果。这可能导致它生成的指令对于机器人在物理环境中完成可能不合逻辑、不切实际或不安全。例如,当提示“我把饮料洒了,你能帮忙吗?”语言模型 GPT-3 以“您可以尝试使用真空吸尘器”作为响应,这个建议对于机器人来说可能不安全或不可能执行。当向 FLAN 语言模型询问相同的问题时,它会以“对不起,我不是故意的”来为泄漏道歉,这不是一个非常有用的回答。因此,我们问自己,是否有一个有效的如何将高级语言模型与机器人学习算法相结合以利用两者的优势?

在“尽我所能,而不是我说的:机器人功能中的基础语言”论文中,研究者提出了一种与 Everyday Robots 合作开发的新颖方法,该方法利用先进的语言模型知识使物理代理(例如机器人)能够遵循基于物理的任务的高级文本说明,同时将语言模型基于在特定现实世界上下文中可行的任务中。我们通过将机器人放置在真实的厨房环境中并赋予它们以自然语言表达的任务来评估我们称之为 PaLM-SayCan 的方法。我们观察到时间扩展的复杂和抽象任务的高度可解释的结果,例如“我刚刚锻炼,请给我带点零食和饮料来恢复。”具体来说,我们证明在现实世界中将语言模型接地几乎可以将非接地基线的错误减少一半。我们也很高兴发布一个机器人模拟设置,研究社区可以在其中测试这种方法。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢