现有注意力机制难以做到对性能和模型复杂性之间的良好权衡,在兼顾通道和空间注意机制的同时带来额外的巨大负担。因此本文提出的HAM通过快速一维卷积来缓解通道注意机制的负担,并引入通道分离技术自适应强调重要特征。HAM作为通用模块,在CIFAR-10、CIFAR-100和STL-10数据集上实现了SOTA级别的分类性能。

论文地址:https://doi.org/10.1016/j.patcog.2022.108785

一、问题导出

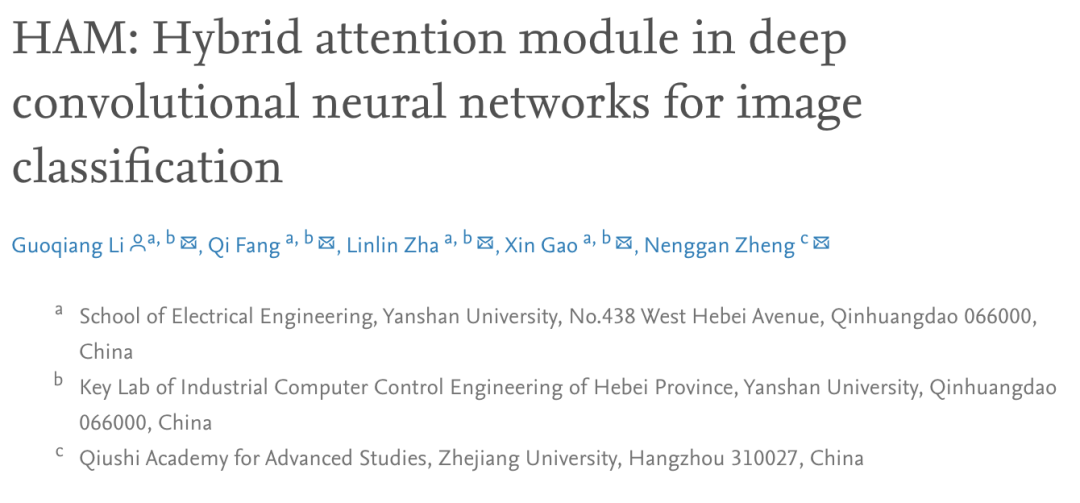

本文旨在实现一种轻量且高效的,兼顾通道与空间的注意力机制。此前如CBAM也兼顾通道与空间的重要性,但带来较高的模型复杂性。CBAM模块能够序列化地在通道和空间两个维度上产生注意力特征图信息,其结构细节如下图所示:

图1:CBAM模块的通道注意力和空间注意力结构细节。

然而在其通道注意力模块中,多层感知机的应用增加了模型的复杂程度。因此设计一种简单有效的注意力模块是非常有必要的,在本文的HAM中,作者等人不仅对通道注意模块的设计进行了简化,同时提出“通道注意图代表了不同通道的不同重要性,因此空间注意子模块应该将通道细化特征沿通道轴线分成若干组”,引入通道分离技术,对空间注意模块进行优化。

二、方法

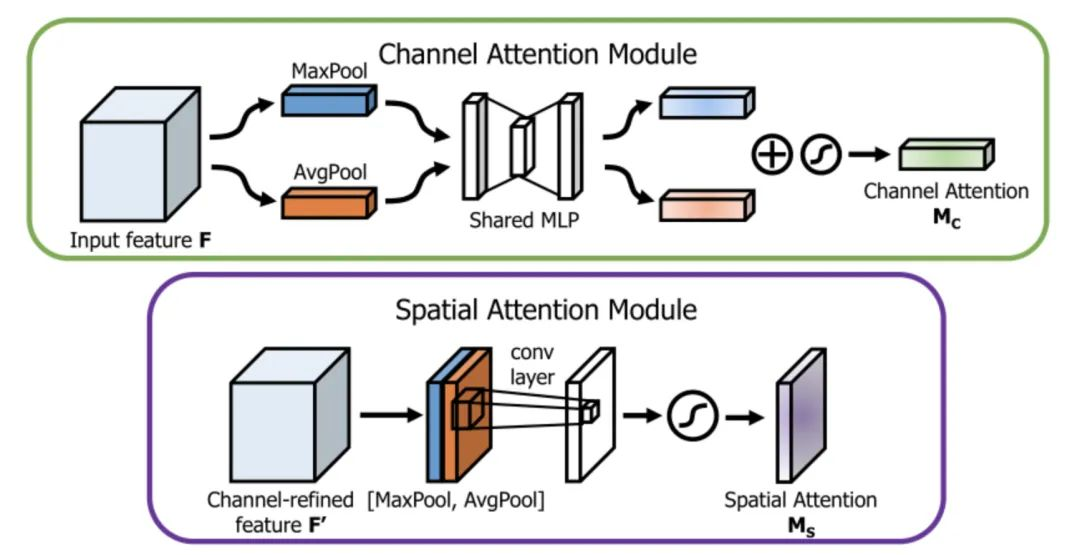

图2:ResBlock嵌入HAM的架构整体。

首先从HAM嵌入ResBlock的整体架构入手,输入特征首先经过通道注意模块,就像CBAM中的通道注意机制一样,先通过得到通道注意张量,接着与相作用得到通道细化特征。

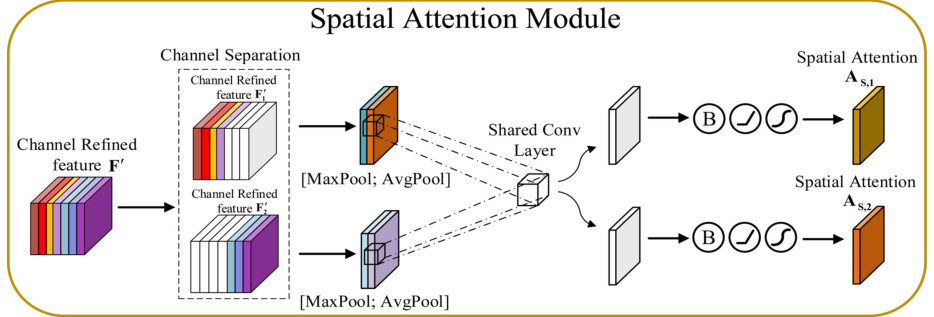

然后是空间注意模块,通道分离技术将切分为两组不同的特征,一组为重要特征,一组是次重要特征,接着对两个不同分支的特征应用空间注意机制,如CBAM中的空间注意机制一般,先从输入特征和获得空间注意张量和,将空间注意张量作用于输入特征后获得空间细化特征和,将两者特征相融合得到最终的细化特征,也即原始输入特征经过HAM后得到的最终结果。

在CIFAR-10、CIFAR-100和STL-10数据集的分类任务中,HAM可以达到SOTA级别的性能。下面将对HAM的各部分细节进行详细描述:

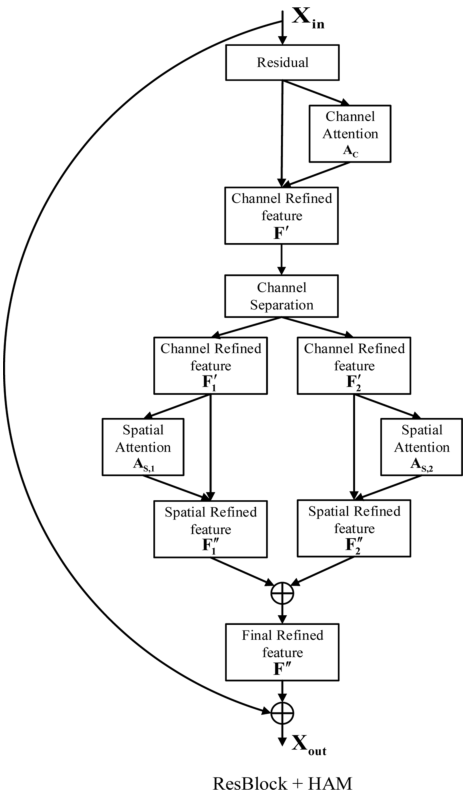

通道注意模块

图3:HAM的通道注意模块示意图。

如图3,输入特征首先经过两个分支的不同池化得到和,这与CBAM中保持一致,平均池化可以学习到目标物体的程度信息,最大池化则能够学习到物体的判别性特征,同时使用的话,最大池化编码目标的显著性信息,能够很好地弥补平均池化编码的全局信息。

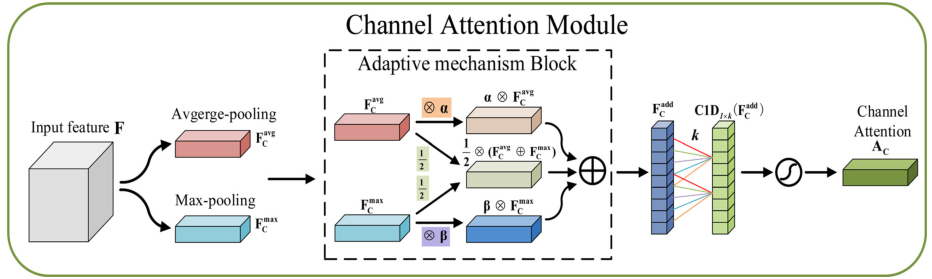

空间注意模块

图4:HAM的空间注意模块示意图。

如图4,输入特征为经过通道注意模块的通道细化特征,其中每个通道都具有不同的重要性(在数值表现上,通道注意张量中重要的通道权重更大)。因此作者等人提出应将通道细化特征沿通道轴线进行划分,重要特征分为一组,次重要特征分为一组。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢