原文链接:https://arxiv.org/pdf/2206.11253.pdf

project:https://shangchenzhou.com/projects/CodeFormer/

code:https://github.com/sczhou/CodeFormer

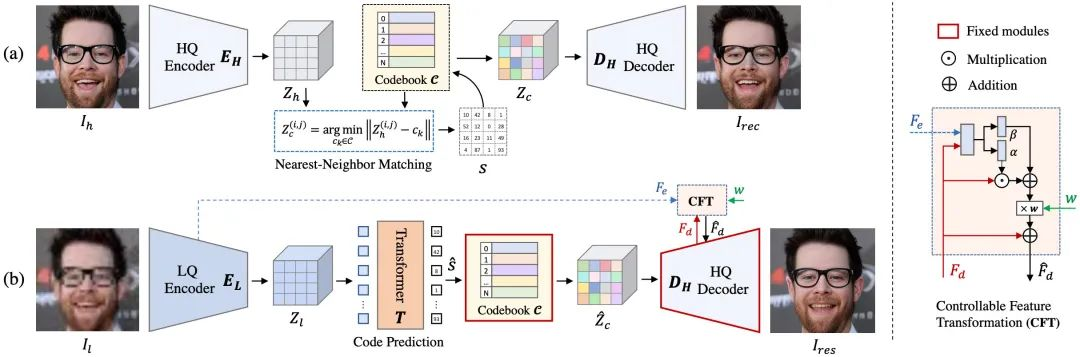

本文研究表明:当把盲人脸复原视作码本预测任务时,可学习离散码本先验(Learned Discrete Codebook Prior)可以极大降低学习的不确定性与混淆,同时为生成高质量人脸提供丰富的视觉原子。基于该框架,本文提出了一种基于Transformer的预测网络CodeFormer,它可以对低质人脸的组成与上下文信息进行建模,促进自然人脸挖掘以生成与目标人脸更相近的结果。为增强不同退化的自适应性,本文还提出了一种可控特征变换模块以寻求真实(fidelity)与高质(quality)之间的均衡。受益于码本先验与全局建模能力,CodeFormer取得了SOTA人脸复原能力。

本文方法

本文主要聚焦于对离散表达空间进行探索以降低复原映射的不确定性、为退化输入提供质量细节补偿。由于局部纹理与细节的缺失、低质输入的干扰,作者采用Transformer模块进行全局上下文建模以促进高质量人脸重建。上图给出了本文方案整体架构示意图,很明显,它是在VQ-VAE、VQ-GAN基础上演变而来。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢