论文题目:Variational Inference for Training Graph Neural Networks in Low-Data Regime through Joint Structure-Label Estimation

作者信息:劳丹宁*,杨新宇*,吴齐天,严骏驰

论文链接:https://dl.acm.org/doi/10.1145/3534678.3539283

代码链接:https://github.com/Thinklab-SJTU/WSGNN

研究动机与背景

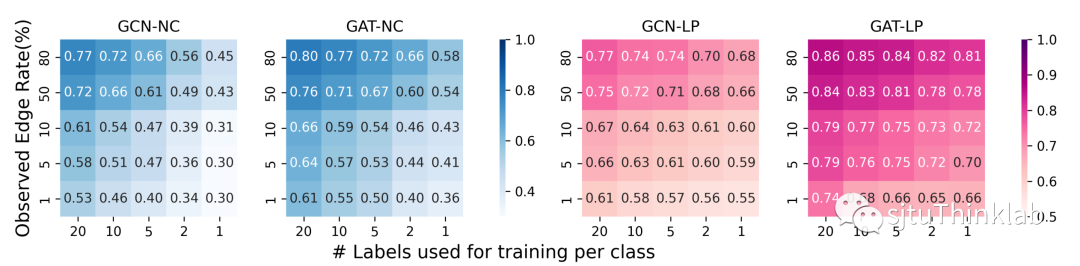

现有的图神经网络(GNN)方法普遍具有依赖于精密的输入数据(包括完整而正确的图结构,充分的节点特征和节点标签等)的特性,在输入数据有缺失,有噪声,不完美时,其模型预测表现就会大大下降。然而在实际应用中,囿于现实因素的影响,比如巨大的人力成本下数据标签搜集的难度,抑或是隐式潜在的链接难以搜集,用于建模的图数据往往是不够完整充分的,甚至有可能出现已知的节点标签和连边都很少的情况,而此时大部分图神经网络方法就变得不可用了。如下图所示,我们模拟了已知的连边数量从80%到1%,已知的节点标签数量从每类20个到每类只有1个的情况,测量了GCN[1]和GAT[2]在每种情况下在节点分类(NC)和链接预测(LP)两个任务上的表现,可视地展现了其网络性能逐渐变差,预测失效的情况。

过去的半监督方法只能解决“大已知,小未知”条件下的推断。当初始信息渐趋于零,图节点中已知的标签数量变少,图结构中已知的边变少,如何实现对极少的监督信息的最大化利用,在“小已知,大未知”的弱监督条件下仍能延续模型的优秀表现,仍然是一个艰巨的挑战。为了解决这个问题,我们提出了一种基于变分推断的弱监督图神经网络模型WSGNN,结合了图表示学习和图结构学习的思想,有效地实现了极其有限信息的外推和泛化。与过往的半监督抑或弱监督方法[3-4]最不同的是,我们首次关注了连边和标签同时缺失的情况,也因此使得我们的模型具有更广泛的应用场景以及更强的鲁棒性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢