新的、正式的智能体定义为 AI 代理的因果建模及其面临的激励提供了明确的原则。

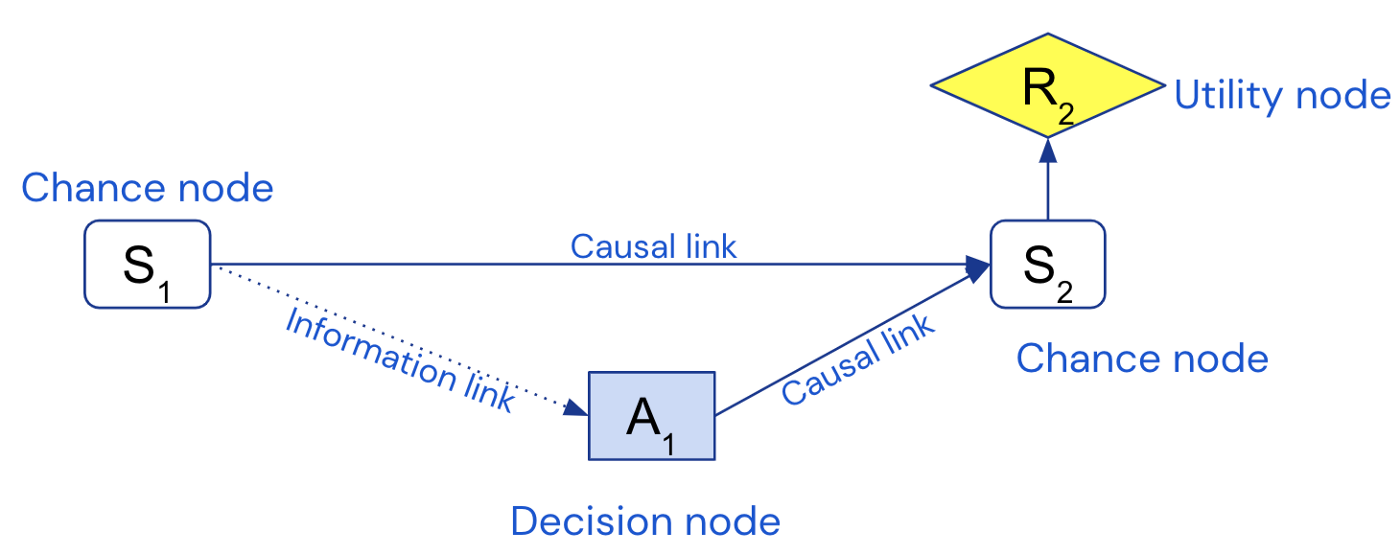

我们希望构建安全、一致的人工智能 (AGI) 系统,以实现其设计者的预期目标。因果影响图 (CID) 是一种对决策情况进行建模的方法,使我们能够对智能体的意图进行推理。例如,这里是一个用于 1 步马尔可夫决策过程的 CID——一个典型的决策问题框架。

通过将训练设置与塑造智能体行为的激励措施相关联,CID 有助于在训练智能体之前就发现潜在风险,并可以推动更好的智能体设计。但是我们如何知道 CID 何时是训练设置的准确模型?

我们的新论文 Discovering Agents 介绍了解决这些问题的新方法,包括:

- 智能体的第一个正式的因果定义:代理是如果他们的行为以不同的方式影响世界,就会调整他们的政策的系统

- 从经验数据中发现智能体的算法

- 因果模型和 CID 之间的转换

- 解决智能体的不正确因果建模引起的早期混淆

综合起来,这些结果提供了一个额外的保证,即没有犯建模错误,这意味着 CID 可用于更有信心地分析智能体的激励和安全属性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢