文章信息

来源:Proceedings of the 39th International Conference on Machine Learning(ICML) 2022

标题:ProGCL: Rethinking Hard Negative Mining in Graph Contrastive Learning

作者:Jun Xia, Lirong Wu, Ge Wang, Jintao Chen, Stan Z. Li

链接:https://proceedings.mlr.press/v162/xia22b.html

代码:https://github.com/junxia97/ProGCL

内容简介

对比学习(CL)已成为无监督表示学习的主要技术,它将anchor的增强版本嵌入彼此靠近(正样本)并将其他样本(负样本)的嵌入分开。正如最近的研究所揭示的那样,CL 可以从hard example(与锚点最相似的底片)中受益。然而,当本文在图对比学习 (GCL) 中采用其他领域的现有hard negative挖掘技术时,本文观察到的好处有限。本文对这种现象进行了实验和理论分析,发现它可以归因于图神经网络(GNN)的消息传递。与其他领域的 CL 不同,如果仅根据锚点与自身的相似性来选择硬负样本,则大多数硬负样本都是潜在的假负样本(与锚点共享同一类的负样本),这将不希望地推开同一类的样本。为了弥补这一缺陷,本文提出了一种称为 ProGCL 的有效方法来估计负数为真的概率,这构成了更合适的负数硬度和相似性度量。此外,本文设计了两种方案(即 ProGCLweight 和 ProGCL-mix)来提高 GCL 的性能。大量实验表明,ProGCL 对基本 GCL 方法带来了显着且一致的改进,并在多个无监督基准上产生了多个最先进的结果,甚至超过了有监督基准的性能。此外,ProGCL 很容易插入到各种基于底片的 GCL 方法中以提高性能。

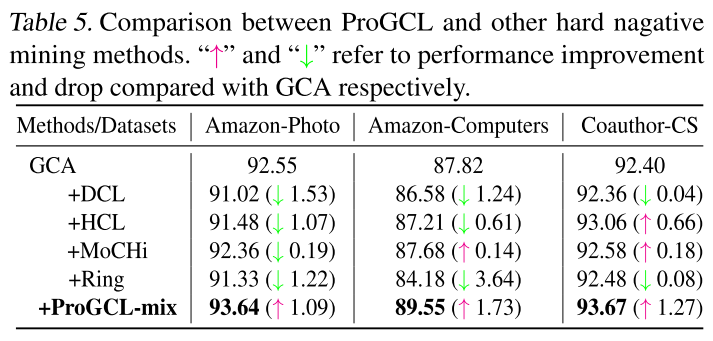

当本文在 GCL 中采用负面挖掘技术时,本文观察到性能略有改善甚至显着下降(结果如下表所示)。

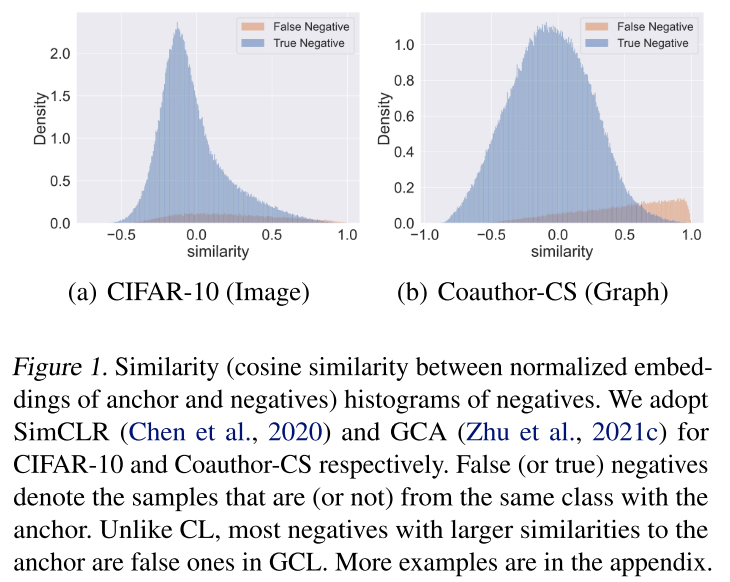

为了解释这些现象,本文首先在下图中绘制了各种数据集相似性上的负数分布。请注意,在训练过程中,本文没有观察到负数分布的显着变化(如上图(a)所示保持单峰) SimCLR (Chen et al., 2020) 在 CIFAR-10 和其他图像数据集上。然而,对于 GCL 的第一阶段,底片的分布在很长一段时间内是双峰的,如上图(b),然后在第二阶段逐渐过渡到单峰分布,如 CL。更多数据集的类似现象可以在附录中找到。CL 和 GCL 之间负数分布的差异可以归因于图神经网络独特的消息传递,这些解释了 GCL 中现有的负挖掘技术性能不佳的原因。具体来说,他们将与锚点最相似的负数视为所有训练过程中的难点。

然而,如上图(b) 所示,以这种方式选择的大多数“硬”负样本确实是 GCL 的假负样本,这将不希望地推开语义相似的样本,从而降低性能。假阴性的存在被称为 DCL 中的抽样偏差 (Chuang et al., 2020)。本文认为可以通过在相似性上拟合双分量(真-假)β 混合模型(BMM)来区分真假阴性。在 BMM 下,负数为真的后验概率可以构成更合适的测量负数硬度和相似性的方法。通过新的度量,本文设计了两种方案(ProGCL-weight 和 ProGCLmix)来进一步改进基于负数的 GCL 方法。据本文所知,本文的工作是在节点级 GCL 中研究硬负挖掘的开创性尝试之一。本文强调以下贡献:

- 本文展示了 GCL 和 CL 之间负数分布的差异,并通过理论和实验分析解释了为什么现有的硬负数挖掘技术在 GCL 中不能很好地工作。

- 本文建议利用BMM 来估计一个否定相对于特定锚为真的概率。结合相似性,本文得到了一个更合适的负片硬度度量。

- 本文设计了两种方案(即ProGCL-weight 和ProGCL-mix),它们更适合GCL 中的hardnegative 挖掘。

- ProGCL 对基本 GCL 方法带来了显着且一致的改进,并在多个无监督基准上产生了多个最先进的结果,甚至超过了有监督基准的性能。此外,它还可以增强各种基于底片的 GCL 方法以进一步改进。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢