作为一种经典的基于密度的聚类方法,DBSCAN由于简单而且实用,被广泛的运用到许多科学和工程领域中。然而,由于它对聚类距离和密度阈值两个参数的高敏感性,所以聚类的结果严重的依赖于实际的经验。

本文中,我们首先提出了一个强化学习指导的自动DBSCAN参数搜索的新框架,即DRL-DBSCAN。此框架将通过感知周围环境来调整参数搜索方向的过程视为一个马尔可夫决策过程,其目的是在没有人工帮助的情况下找到最优的聚类参数。DRL-DBSCAN通过与聚类结果交互,并且使用一个弱监督奖励训练策略网络来学习对于不同特征分布的最优聚类参数的搜索策略。

此外,我们也提出了一个由数据规模驱动的递归搜索机制来处理较大的参数空间。我们在基于四个工作模式的五个人工和真实世界数据集上进行了大量的实验。离线和在线任务的结果表明,DRL-DBSCAN不仅分别提升了DBSCAN25%与26%的聚类准确度,而且可以在高计算效率的前提下,稳定的找到合适的参数。此代码已经在GitHub上开源。

论文地址:https://arxiv.org/abs/2208.04537

代码链接:https://github.com/ringbdstack/drl-dbscan

一、引言

基于密度的噪点空间聚类方法(DBSCAN)是一个典型的根据样本分布的紧密度来决定聚类结构的密度聚类方法。它能够根据数据的特征自动的决定最终聚类的数目,并且对于异常数据不敏感,以及能够发现任何形状的类簇。在应用方面,得益于其对于未知分布数据集的强大适应能力,DBSCAN对于许多聚类问题是首选解,并且在如金融分析[27,53],商业研究[18,52],城市规划[37,43],抗震研究[19,31,50],推荐系统[25,34],基因工程[20,41]等领域中由很好的表现。

然而,DBSCAN的两个全局参数,聚类距离Eps和一个类中最少需要的数据点数MinPts,需要人工给定,这给聚类过程带来了三个挑战。

第一,参数选择的挑战。Eps和MinPts对于聚类结果有相当大的影响,而且它们需要被提前确定。基于k-距离的方法可以通过曲线上最大变化的位置来估计Eps的可能值,但这仍然需要提前人工的去设置参数MinPts。即使有一些通过避免同时调整Eps和MinPts的DBSCAN的提升方法,但它们也需要提前决定截断距离参数[13],网格参数[12],高斯分布参数[47]或者固定的MinPts参数[2,26]。因此,第一个挑战就是如何在没有先验知识来调整参数的前提下实现DBSCAN聚类。

第二,适应性策略挑战。 由于聚类任务中不同数据分布和聚类特性,传统的基于固定模式[39,40]DBSCAN参数搜索方法在面对非传统数据问题时遇到了瓶颈。并且,使用基于数据标签信息的将外部聚类评价作为目标函数的超参数优化理论[5,30,36],在没有数据标签信息时效果不佳。只将内部聚类评价作为目标函数的方法[35,37],尽管不需要标签信息,但却被准确度限制。并且,对于需要持续聚类但数据分布不断变化的流式数据,现有的DBSCAN参数搜索方法没有做到使用过去的经验去自适应的形成对于新数据的参数搜索策略。因此,如何有效和适应性的调整数据的参数搜索策略以及能对应缺失标签信息的情况是第二个挑战。

第三,计算复杂度挑战。 参数搜索会受到难以估计的大的参数空间的限制。搜索过多无效的参数会增加搜索成本[29],同时太大的搜索空间也会给聚类准确度带来干扰[14]。所以,如何快速的搜索到最优参数的同时使聚类的准确度得到保证是第三个需要解决的挑战。

近年来,深度强化学习(DRL)[22,38]由于其从环境中能接受反馈的能力[44]被广泛的运用于缺失训练数据的任务中。在本文中,为了解决不能找到最优的DBSCAN参数的问题以及以上的挑战,我们提出了DRL-DBSCAN,一种全新的,自适应的,递归的深度强化学习DBSCAN参数搜索框架,以在多种场景和任务中能稳定地得到最优参数。

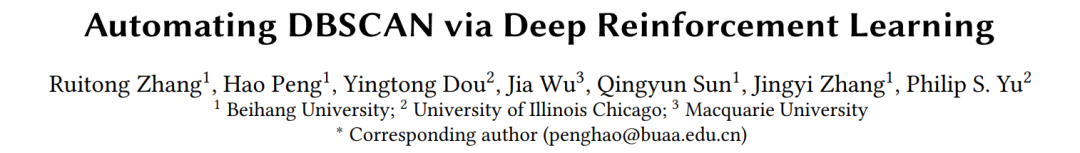

我们首先将每一步聚类后地聚类的改变情况作为观测状态,参数调整方向视为动作,并且将参数搜索过程视为一个深度强化学习智能体自动感知环境并做出决策的马尔可夫决策过程(图1)。然后,通过弱监督,我们建立了一个基于少量外部聚类指标的奖励,并且基于注意力机制融合了多重聚类的全局状态和局部状态让智能体能够自动学习实现对不同数据场景的自适应参数搜索过程。此外,为了提高学习策略网络的学习效率,我们通过一种基于不同搜索精度的智能体递归机制来优化了基本的框架,以实现在稳定和可控的得到参数的情况下实现较高的聚类准确度。

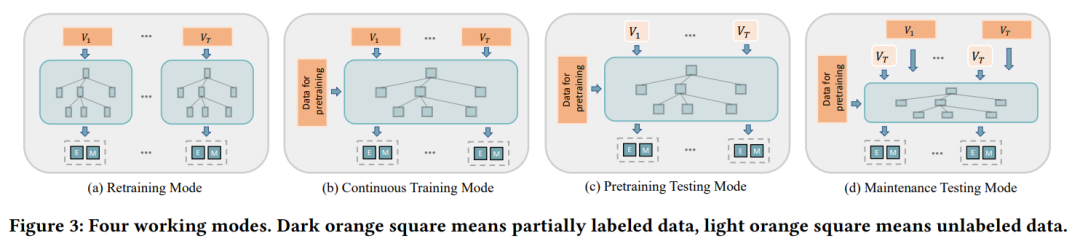

最终,考虑到无标签、少标签、初始数据,增量数据的DBSCAN聚类场景的存在,我们设计了四个工作模式:再训练模式,持续训练模式,预训练测试模式以及考虑到兼容性的维护测试模式。我们在Pathbased,Compound,Aggregation,D31和Sensor数据集上做了大量的离线的任务,以广泛的评价DRL-DBSCAN在四个模式上的参搜搜索表现。结果表明使用DRL-DBSCAN可以不用手动定义参数,即自动并且高效的发现合适的DBSCAN聚类的参数,并且在多种下游任务中具有稳定性。

下面总结了本文的贡献:

-

提出了第一个强化学习指导的DBSCAN的参数搜索框架以自动的选择参数搜索方向;

-

建立了一个弱监督的奖励机制和一个局部聚类状态的注意力机制,可以帮助智能体在缺失标签的情况下根据历史经验来适应性的形成最优参数搜索策略,实现对数据分布的波动的适应。

-

设计了一个递归的深度强化学习参数搜索策略,提供了对于大范围参数空间搜索问题的一个高效而稳定的解法。

-

通过做了大量离线和在线实验,演示了DRL-DBSCAN的四种模式在提升DBSCAN精度,稳定性和效率方面的优势。

二、问题定义

这一部分,我们给出DBSCAN聚类,DBSCAN聚类的参数搜索,数据流聚类中的参数搜索的定义。

定义1(DBSCAN聚类)DBSCAN聚类指对于数据块V中的数据对象 ![]() ,依据参数

,依据参数![]() 来划分出类别

来划分出类别 ![]() 的过程。其中

的过程。其中![]() 指的是两个相邻点能被划分为一个类的最大距离,

指的是两个相邻点能被划分为一个类的最大距离,![]() 指的是一个数据对象要作为一个核心点,其周围(以Eps为半径的圆内)的邻接对象的最小数量。类的形成过程可以被理解为核心点和其周围点(以Eps为半径的圆内)的连接的过程。(图1)

指的是一个数据对象要作为一个核心点,其周围(以Eps为半径的圆内)的邻接对象的最小数量。类的形成过程可以被理解为核心点和其周围点(以Eps为半径的圆内)的连接的过程。(图1)

定义2(离线DBSCAN聚类的参数搜索)给定数据块![]() ,DBSCAN的参数搜索记为找到参数空间中最优的参数组合

,DBSCAN的参数搜索记为找到参数空间中最优的参数组合![]() 的过程。其中,数据块V的特征集合X为

的过程。其中,数据块V的特征集合X为![]()

定义3(在线DBSCAN聚类的参数搜索) 给定连续以及暂时的数据块![]() 作为线上数据流,将在每个时间

作为线上数据流,将在每个时间![]() ,从数据块

,从数据块![]() 中找到参数组合

中找到参数组合![]() 的过程定义为在线聚类的参数搜索。

的过程定义为在线聚类的参数搜索。

三、DRL-DBSCAN框架

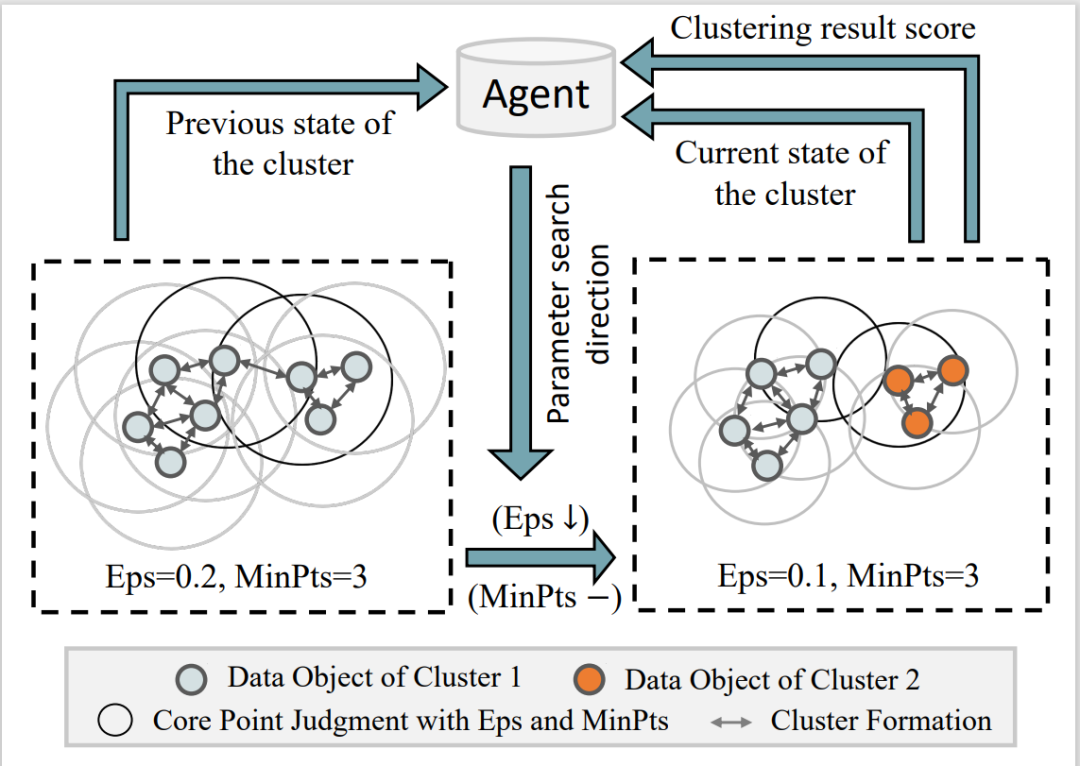

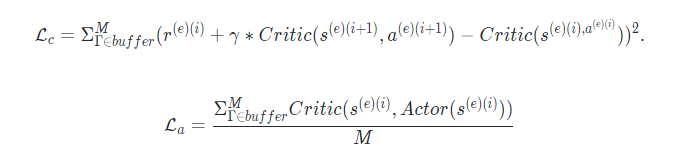

DRL-DBSCAN有一个核心模型(图2)和四个可以被扩展到下游任务的工作模式(图3)。我们首先描述了参数搜索的基本的马尔科夫决策过程(3.1),以及聚类参数空间和递归机制的定义(3.2).然后,我们会解释四个DRL-DBSCAN的工作模式(3.3)。

3.1 基于深度强化学习的参数搜索

-

状态:由于状态需要能够尽量准确和完整的代表每一步的搜索环境,我们考虑从两方面来构建状态的表征。

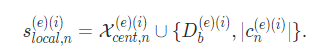

首先,对于整体的搜索和聚类状况,我们使用了一个七元组来描述第i步的的全局状态:

其中, ![]() 是目前的参数组。

是目前的参数组。![]() 是一系列平方距离的集合,包括

是一系列平方距离的集合,包括![]() 与其空间的边界

与其空间的边界![]() 和

和![]() 的距离,

的距离,![]() 与其空间的边界

与其空间的边界![]() 和

和![]() 的距离,聚类后类簇的数量

的距离,聚类后类簇的数量![]() 与数据框中数据对象的数量 v的比值

与数据框中数据对象的数量 v的比值![]() 。其中,在3.2中我们会给出上述参数边界的具体定义。

。其中,在3.2中我们会给出上述参数边界的具体定义。

其次,对于每一个类的情况的描述,对于第i步类别![]() 的局部状态,我们定义了一个元组:

的局部状态,我们定义了一个元组:

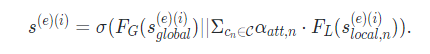

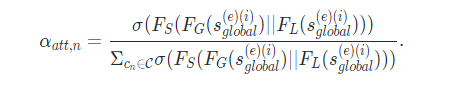

考虑到在参数搜索过程中,类簇数目在每一步中都会变化,我们使用了注意力机制[48]来将全局状态和多个局部状态编码为一个定长的状态表征:

我们分别将每个类聚的局部状态和全局状态串联,然后用一个全连接网络 来打分,并且标准化这个分数作为每个类簇的注意力机制的系数。这个方法建立了当局部类簇明确时,全局搜索情况的注意力机制。同时,它也让不同种的聚类信息在最后的状态表征中有不同的权重,这增加了状态表征中重要类簇的影响力。

-

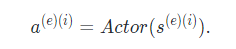

动作:动作 代表第 步的参数搜索方向。

其中 是一个三层的多层感知机(MLP).

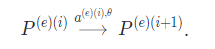

此外,从第 步到第 步的动作-参数变化过程可以如下定义:

其中, 和 分别时第 步和第 步的参数组

-

奖励:考虑到确切的终止参数点是未知的,但是奖励需要能够激励智能体学习一个较好的参数搜索策略,我们使用了一小部分外部度量的样本作为奖励的基础。

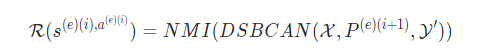

我们定义了第 步立即的奖励为:

其中, 代表外部的度量函数,即DBSCAN聚类的标准化互信息(NMI)[16]。 是特征集合。 是数据块的一个部分标签集。注意到标签仅仅被用在训练过程中,测试过程的搜索是在没有标签的数据块上进行的。

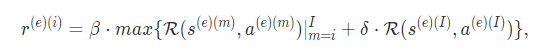

此外,一轮的最优的参数搜索动作序列是不断向着最优参数的方向调整参数,并且在最优参数点停止搜索。因此,我们考虑同时使用剩余步的立即奖励的最大值和中止点立即奖励作为第 步的奖励:

其中, 是第 步中止参数点的立即奖励。max是用于计算中止前未来的立即奖励的最大值。 和 是奖励的影响因子,其中 。

-

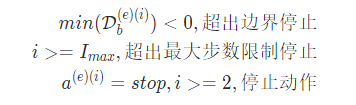

终止:对于完整一轮搜索过程,我们决定使用如下的终止条件:

其中, 是一轮搜索中的最大搜索步数。

-

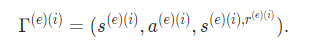

优化:第e轮的参数搜索过程可以表达为:

-

观测目前DBSCAN聚类的状态

-

基于 使用 预测参数调整方向

-

得到新状态

-

重复上述过程直到一轮搜索结束,并且在每一步计算出奖励 。第 步的核心如下:

我们将每一步的 放入缓冲区来优化策略网络 ,并且定义关键的损失函数为:

其中,我们定义了一个三层的多层感知机 来学习状态的动作价值[33],用来优化 。并且 代表奖励的衰变因子。我们的框架中使用TD3策略优化算法[22],不过可以使用其他深度强化学习策略优化算法来替代[33,38]。

3.2参数空间和递归机制

这一部分,我们定义了前一部分提到的智能体的参数空间和基于不同参数空间的递归搜索机制。首先,为了解决由于不同数据分布引起的参数范围的波动,我们标准化了数据特征,从而将参数Eps得到最大的搜索范围,参数必须是一个大于0的整数。因此,我们提出根据数据集的维度或者大小来划分出参数的最大搜索范围。

3.3 提出的DRL-DBSCAN

算法1展示了DRL-DBSCAN核心模型的过程。给定一个数据块 和部分标签 ,训练过程就是在多轮过程中在每一层进行参数搜索(6-10行)来优化智能体的过程(14行)。在这个过程中,可以不断更新最优的参数组合(基于立即奖励((7)式)的15行和17行)。为了提高效率,我们建立了一个哈希表来记录搜索到的参数组的聚类结果。另外,我们建立了提前停止机制来在最优参数组不再改变的时候停止来加速训练过程(16行和18行)。在测试过程使用训练好的智能体来在一轮过程中直接搜索,并且不设置提前停止机制。另外,测试过程是不需要标签的,最后一层智能体搜索的终止点参数就是最后的最优参数组合。

为了更好的适应各种任务情形,我们如图3所示的DRL-DBSCAN的四种工作模式。它们对应于如下的定义:

1. 再训练模型:基于训练过程搜索最优参数。当数据集变化时,每一层的智能体被重新初始化。

2. 持续训练模型: 智能体被提前训练。当数据集改变的时候,使用过去已经训练好的智能体基于搜索过程持续搜索。

3. 预训练测试模型: 智能体被提前训练。当数据集改变的时候,直接基于没有标签的测试过程来搜索。

4. 维护测试模型: 智能体被提前训练好。当数据集改变时,直接基于没有标签的测试过程搜索。在预训练之后,定期在有标签的历史数据上进行维护训练。

四、实验

这一部分,我们做了包括以下几部分的实验:

-

较在离线任务上DRL-DBSCAN和基准线的表现,解释强化学习的搜索过程(4.2部分);

-

分析DRL-DBSCAN及其变种的表现。比较四种工作模型在在线实验的优点(4.3部分);

-

超参数及其在模型上的影响的灵敏度分析(4.4部分)。

4.1 实验设置

基准线和变体: 我们将DRL-DBSCAN与三种类型的基准线相比较:

-

传统的超参数搜索框架: 随机搜索算法Rand,基于树结构Parzen估计的贝叶斯最优算法BO-TPE[5];

-

元启发式优化算法: 模拟退火算法Anneal[32],粒子群优化PSO[46],遗传算法GA[36],以及差分进化算法DE[45];

-

现存的DBSCAN参数搜索方法:KDist(V-DBSCAN)[39]和DBE-DBSCAN[30]。

实现细节:对于所有的基准线,我们使用了来自基准库Hyperopt[7]和Scikit-opt[1]的开源实现。所有的实验基于Python 3.7,36核3.00GHz因特尔核心 i9 CPU,以及英伟达RTX A6000 GPUS。

实验设置:DRL-DBSCAN的评价是基于3.3中的四个工作模型的。考虑到大多数算法的随机性,所有的实验结果都去了10次基于不同种子的运行结果的平均值(除了KDist因为它是启发式算法并且不带有随机性)。

具体的,对于DRL-DBSCAN的预训练和维护训练过程,我们设置了轮数的最大值 为15。在离线任务和在线任务中,递归层数的最大层数 被设置为3和6,以及第0层参数 的最大搜索边界 和 被设置为0.25和0.0025倍的数据块大小。

另外我们使用统一的标签训练比例0.2,参数 空间的大小 为5,参数 空间的大小 为4,最大搜索步数 为30,奖励因子 为0.2。而FCN和MLP的维度被均匀的设置为32和256, 的奖励衰减因子为0.1,从缓冲区的例子数目 为16。另外,所有的基准线使用相同的目标函数,参数搜索空间和参数最小步长。

评估标准:我们使用准确度和效率来评估实验。具体的,我们使用标准化互信息[16]和调兰特指数(ARI)[51]来度量聚类准确度。对于效率,我们用做DBSCAN聚类的次数作为度量。

4.2 离线评估

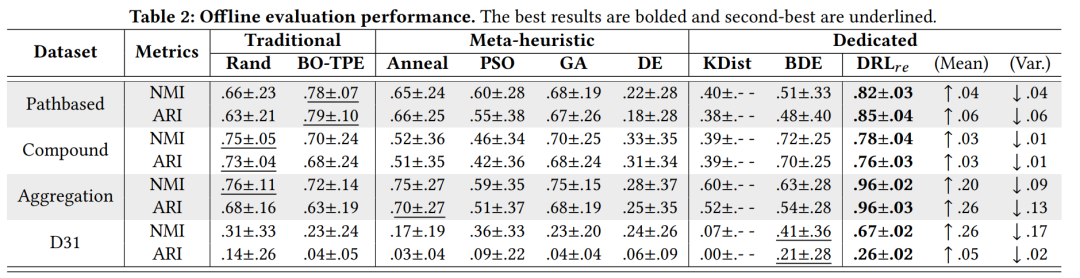

离线评估是基于四种人工基准数据集。由于在离线情形中没有用于预训练的数据,我们将使用了与训练模型的 的DRL-DBSCAN与基准前的表现作比较。

相比于其他的超参数优化基准线,在相同目标函数下,在准确度和稳定性是这样明显的优势说明了 可以在多轮的参数搜索后可以稳定的找到优秀的参数组。另外, 不会被数据集的大小影响。在所有的基准线中,PSO和DE在准确度方面是最弱的,因为它们的参数空间是连续的,需要更多次搜索来得到最优结果。BO-TPE通过一个概率代理模型来学习如何提前搜索参数组合,其探索和利用方面的平衡使得它相比于其他的基准线很有优势。我们提出的DRL-DBSCAN不仅通过一个递归机制减小了每一层的搜索空间,而且通过学习历史经验,使得其能够更好的搜索到DBSCAN参数组。

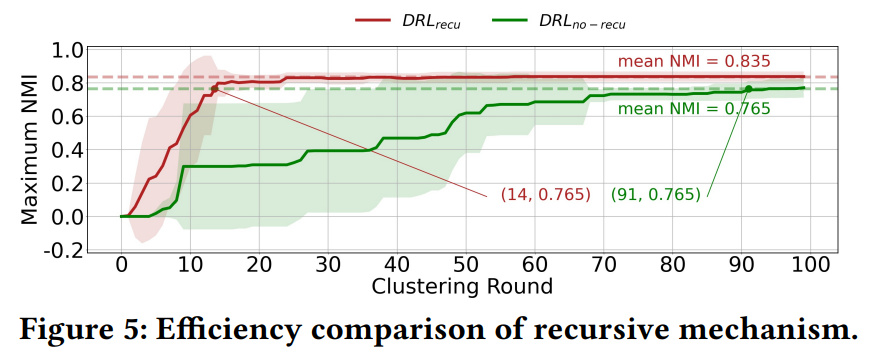

DRL-DBSCAN变种:我们比较了图5中所示的缺少注意力机制的版本。结果显示,在第一个100轮种,递归机制给最大搜索速度带来了6.5的增长比率,这有效地说明了注意力机制在效率方面的贡献。

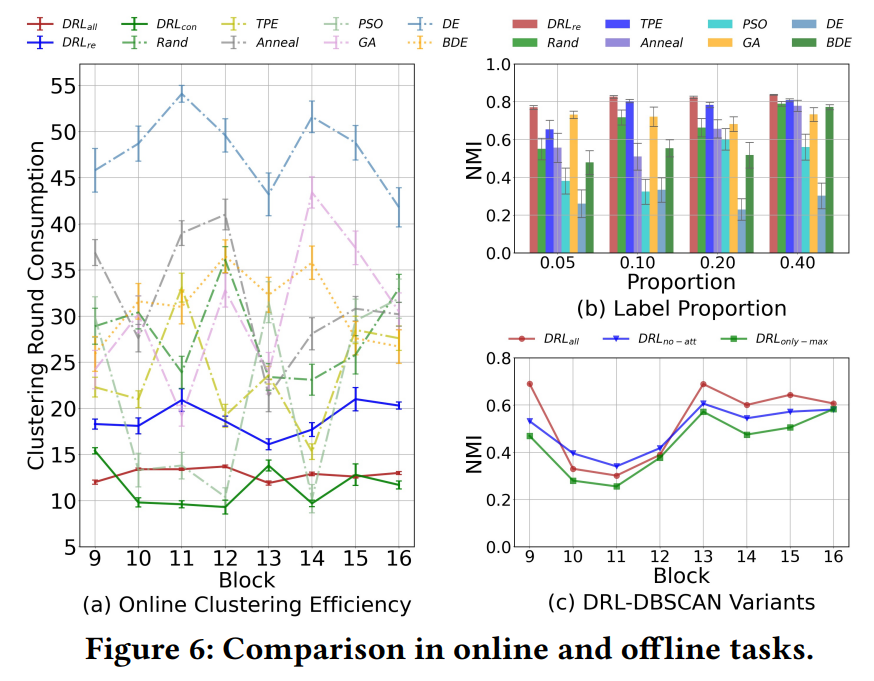

标签部分比较:考虑到在DRL-DBSCAN训练中标签部分的影响,我们在Pathbased上做了都统标签部分的实验,结果如图6(b)所示(在以上的竖行是结果的方差)。可以看到在不同的比例标签任务中, 的平均 分数比基准线要高,而方差要更小。另外,随着标签数目的减少,大多数基准线的分数都会锐减,但是基本保持一致。如此稳定的表现展现了DRL-DBSCAN在标签比例改变下有较好的适应能力。

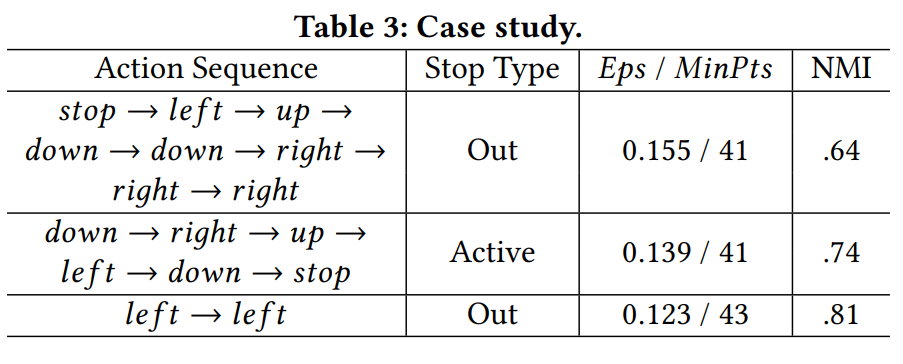

案例学习:为了更好的展示基于强化学习的参数搜索过程,我们使用了一个3轮的,3层递归,并使用Pathbased数据集的案例(表3)。表三的列代表智能体 在不同轮种的动作序列,终止类型,以及中止点参数组和 分数。可以观察到DRL-DBSCAN试图从初始的参数组变化到最优的参数组。对于路径依赖形式的搜索,当对于每个参数组都具有沿着路就寻找搜索方向时,可以使用过去学习到的最优路径。由于我们加入了 动作,DRL-DBCSAN可以学习在最优位置停止,这帮助DRL-DBSCAN在没有标签的线上情况实现聚类。注意到由于我们将过去参数组的聚类信息放入一个哈希表中,所以对于重复的路径不再需额外的操作。

4.3 在线评估

强化学习的可学习性使得DRL-DBSCAN能够更好的利用过去的在线任务的经验。为此,我们全面评估了DRL-DBSCAN在流式数据集上的四种工作模式。具体来说,传感器的前8个模块被用于 的预训练,而后8个模块用于和基准线比较结果。由于基准线不能在在线任务上实现增量学习,我们在每一块开始前初始化算法。此外,包括 和 对于无标签的测试都是用了不可见的数据,而 在每个模块结束测试后使用做好标签的历史数据对模型进行维护训练。

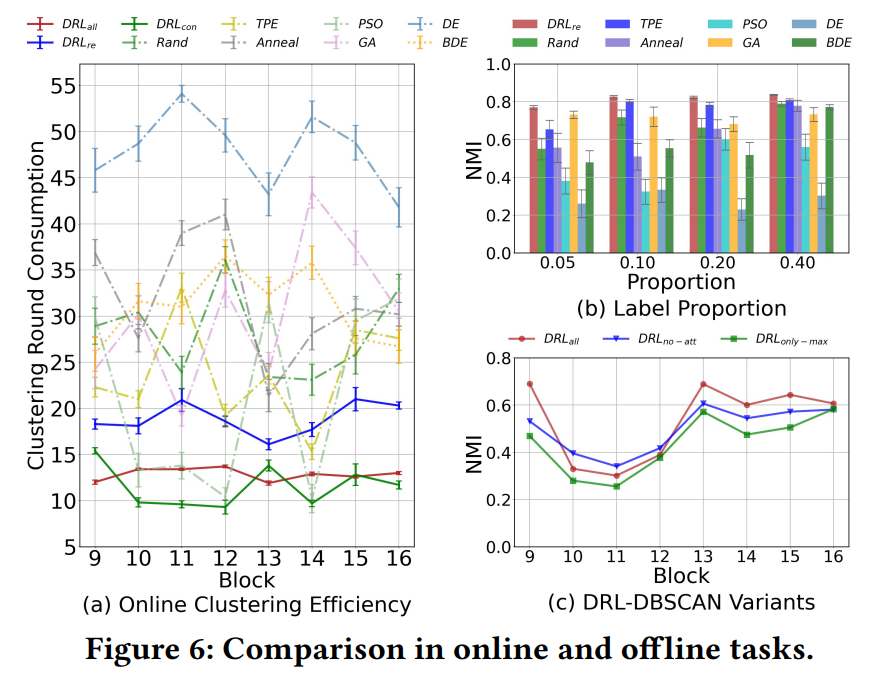

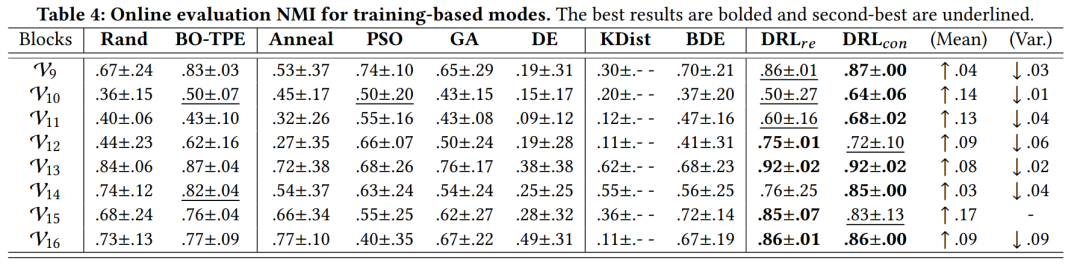

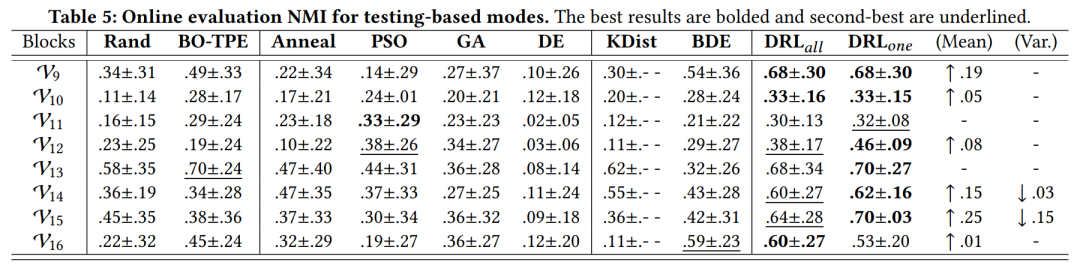

准确度和稳定性分析:在表4和表5中,我们给出了DRL-DBCSAN的基于训练的模型( 和 )以及基于测试的模型( 和 )与基准线的比较。由于DRL-DBSCAN的动作空间有 动作,所以能够自动的停止搜索。为了控制基准线实验条件的一致,我们使用了DRL-DBSCAN自动结束所消耗的平均聚类次数来作为基准线对应任务的聚类次数(表4为30,表5为16),结果显示在多个模块上,基于训练的模型和基于测试的模型在 分数的平均值上分别提升了9%和9%,并且方差减少了4%和2%。

首先,表4说明了与离线任务类似,基于再训练的 在在线任务上仍然保留有很大的优势。第二,将 这个能够进行增量学习的版本与 相比较, 在方差上有显著的减少并且使得性能提高14%。第三,从表5中可以发现,在基于测试的模型中,没有标签的 和 (没有奖励函数)可以显著的超过需要标签来建立目标函数的基准线。第四, ,通常都比 有更小方差和更好表现。这些结果说明了DRL-DBSCAN在保留历史经验方面得能力以及学习到的DBSCAN参数搜索的准确度和稳定性方面的优势。另外,即使 可以确定没有标签和迭代数时的参数但是相应的准确度会比较低。

效率分析: 为了更好的分析两个基于测试的参数搜索模型,我们比较了在线任务中,其他方法要达到与的中止点相同的 分数时所需要的聚类次数(图6(a))。在途中,竖列是结果的方差。我们可以看出, 达到最优结果所消耗的聚类次数范围在11-14之间,而其他的基准线达到相同的 则需要更多的聚类次数。另外,许多基准线的聚类次数的消耗量在不同的数据块上有严重的波动,同时在同一个数据块上的方差也很大。上述的观测说明了DRL-DBSCAN在缺少标签的基于测试的模型上的参数搜索效率超过了需要标签的基准线。

DRL-DBSCAN变种: 为了更好的评价3.1中状态和奖励的设计,我们比较了 的两个变种, (即状态中没有设置注意力机制), (奖励只是基于未来立即奖励中的最大值)。图6(c)的结果显示结构完全的 在 分数上比变种要好,并且给最好的表现带来了0.16的提升,这说明设置局部状态和立即奖励的必要性。

4.4 超参数灵敏度

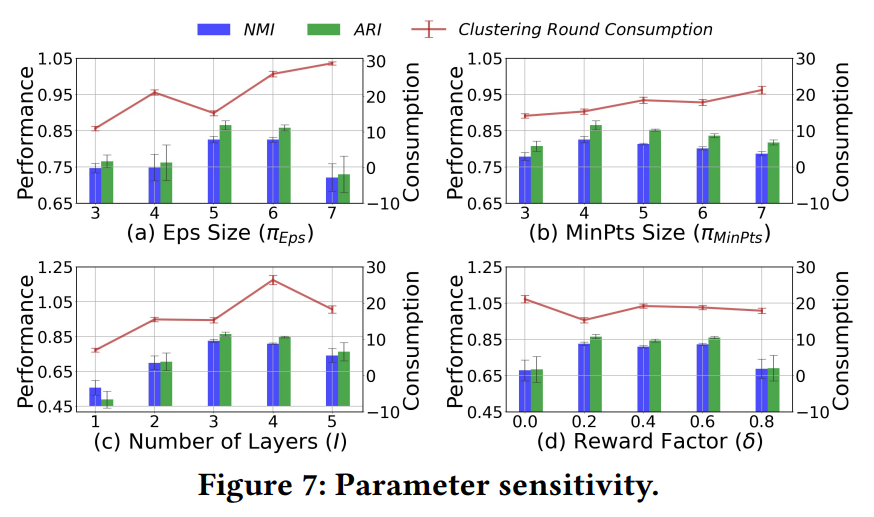

图7展示了对于四个超参数, 在Pathbased数据集上做离线评估的结果。图7(a)和图7(b)分别比较了方程(13)中参数空间的大小对结果的影响。可以发现对参数 来说,空间过大或者过小都会带来性能损失和搜索效率的减小,而参数 对于参数空间大小的变化则不那么敏感。图7(c)分析了不同的递归层数对结果的影响。结果显示一个合适的递归层数可以使得性能稳定。值得注意的是,递归层数并不需要太多的调整,因为我们在3.3中以及设置了提前停止的机制来防止出现太多层的情况。图7(d)则比较了中止点立即奖励和未来立即奖励最大值的权重对结果的影响(方程8)。结果显示,比较均衡的分配两个立即奖励的贡献可以帮助DRL-DBSCAN提高性能。

五、相关工作

自动DBSCAN参数决策:作为经典的密度聚类算法,DBSCAN受限于两个需要先验知识进行决定的高灵敏度参数。针对以上的问题,有许多工作提出了相应的解决方案。

-

OPTIC[3]是DBSCAN的一种基于可达性得到 来建立聚类的拓展。然而,这种方法需要提前确定一个合适的 ,并且 需要用户交互。

-

V-DBSCAN[39]和KDDClus[40]使用数据对象到它的第𝑘近对象的排序距离,并使用曲线上的显著变化的一些值作为候选 参数。

-

类似的方法包括 DSets-DBSCAN[26]、Outlier[2]和RNN-DBSCAN[10],所有这些都需要一个固定的值或预先确定的最近邻居数 ,并且获得的候选 参数可能不是唯一的。

除了上述工作之外,还有一些工作[12,13]考虑了 DBSCAN与网格聚类相结合判断密度趋势,通过预先确定的网格划分参数根据每个数据区域的大小和形状来对原始样本聚类。虽然这些方法将参数选择的难度降低到一定程度,但在某种程度上,它们仍然需要用户至少启发式地决定一个参数,这是它们在数据有变化时不够灵活。

超参数优化: 对于 DBSCAN 的参数, 另一种可行的参数决策方法是基于超参数优化(HO)算法。经典的 HO 方法是无模型方法,包括搜索所有可能参数地网格搜索以及随即搜索等。另一个方法是贝叶斯优化方法,例如 BO-TPE[5], SMAC[28],它使用先前的经验优化搜索效率。

此外,元启发式优化方法,如 模拟退火[32]、遗传[36]、粒子群[46]和微分进化[45],可以通过模拟物理、生物来解决非凸、非连续、非光滑优化问题,以实现搜索。基于元启发式优化算法,一些作品提出了DBSCAN的HO方法。BDE-DBSCAN [30] 以外部纯度指数为目标,选择 参数基于二元差分进化算法来选择参数 ,使用一个竞赛选择算法来选择 参数。MOGA-DBSCAN[17]提出了异常指标作为目标函数地一种新的内部指标方法,并且基于一个多目标基因算法来选择参数。HO 方法避免了手工制作的启发式决策参数,它们需要一个准确的目标函数(聚类外部/内部 指标)并且无法处理未标记数据的问题和 内部指标的误差。而 DRL-DBSCAN 不仅可以执行基于DBSCAN 的聚类状态感知参数搜索目标函数,还保留了学习到的搜索经验,并在没有目标函数的情况下也可以进行搜索。

强化学习聚类: 最近有一些强化学习和聚类算法被提出。比如例粒子物理中的MCTS聚类[9]通过蒙特卡洛树搜索建立了高质量的多层聚类来从观测到的最终状态样本重建初始基本粒子。不过这些工作都是特定领域的强化学习聚类方法。与DRL-DBSCAN相比,它们建立的马尔可夫过程都只适用于特定任务,而不是一般的聚类方法。

除了以上工作,[4]提出了一个提升后的K-Means聚类算法通过强化学习在不同维度选择距离度量的权重。但即使这个方法有效的提升了传统K-Means的表现,但它仍然需要提前决定类簇的数目 ,这是一个巨大的限制。

六、结论

本篇文章,我们提出了一种基于深度强化学习的自适应DBSCAN参数搜索框架。在提出的框架中,通过感知聚类效果和状态来自适应调节参数搜索方向的智能体被用于与DBSCAN算法进行交互。我们设计递归机制建立多层结构以避免过大的参数空间带来性能损失。四种工作模式的实验结果证明提出的框架相比于基准线不仅在有标签数据上兼具准确性,稳定性和效率,还在无标签数据上依然保有有效的参数搜索能力。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢