近年来,学术界、工业界以及政府部门对 AI 伦理的重视程度日益加强,从 AI 伦理监管政策到 AI 伦理技术手段,提升 AI 伦理合规性和打造 AI 伦理技术工具、产品服务成为不断提升 AI 市场竞争优势的一个核心点。从工业界的具体实践角度看,国外的主流科技公司,包括 IBM、微软、Google 等,以及国内的腾讯、微博、美团等,都持续加大对 AI 伦理的研究和实践,腾讯研究院还发布了业内首份《可解释 AI 发展报告 2022—打开算法黑箱的理念与实践》。

可解释 AI 是一个非常庞杂的领域,除了涉及 AI 算法 / 模型等技术,还涉及伦理、法律法规等问题。同时,追求可解释 AI 还需要平衡 AI 的效率和性能的问题。因此,可解释 AI 是一个有待进一步探索的长期问题,也是迫切需要解决的关键问题。从可解释 AI 研究的切入点角度来说,目前主要可以分为两类,一类是关注如何促进模型透明性,例如,通过控制或解释 AI 模型 / 算法的训练数据、输入输出、模型架构、影响因素等,提高模型的透明性,使监管部门、模型使用者以及用户能够更加容易理解 AI 模型;另一类则是研究和开发可解释性工具,即利用工具对已有的 AI 模型进行解释,例如微软的用于训练可解释模型、解释黑盒系统的开源软件包 InterpretML、TensorFlow 2.0 可解释性分析工具 tf-explain、IBM 的 AI Explainability 360 toolkit 等。

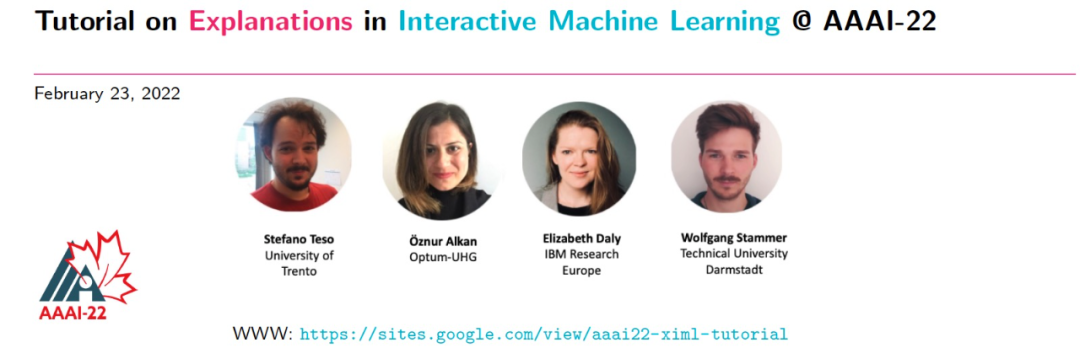

本文聚焦于研究和开发可解释性工具的内容,对 AAAI-2022《Tutorial on Explanations in Interactive Machine Learning》提及的三类可解释性工具 / 方法(局部可解释性、规则可解释性、概念可解释性)进行了解读,重点了解可解释性工具和方法的最新研究进展。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢