作者:Paolo Didier Alfano, Vito Paolo Pastore, Lorenzo Rosasco, 等

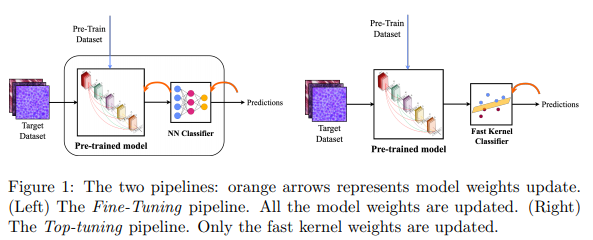

简介:本文提出顶部调优的新思路,以降低微调的计算资源代价。深度学习体系结构令人印象深刻的性能,与模型复杂性的大幅增加有关。由于反向传播和涉及的大量参数,对模型微调:常常在在数据需求、训练时间和推理时间、GPU-CPU参与度和内存使用方面需要大量的计算资源!但大规模的微调是必要的吗?在本文中,针对图像分类,本文提出了一种简单的迁移学习方法,该方法利用预处理卷积特征作为快速核方法的输入。作者将这种方法称为顶部调优,因为只训练内核分类器。本文通过32个目标数据集、99个不同的设置、2660个不同的训练过程,广泛的实验表明:该顶部调整方法提供了与微调相当的精度,而训练时间可以缩小一两个数量级之间。在中小型数据集的实验结果表明:顶部调优为微调提供了一种有用的替代方法,尤其是在训练效率至关重要的情况下。

论文下载:https://arxiv.org/pdf/2209.07932.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢