【论文标题】Protein language models trained on multiple sequence alignments learn phylogenetic relationships

【作者团队】Umberto Lupo, Damiano Sgarbossa, Anne-Florence Bitbol

【发表时间】2022/09/22

【机 构】洛桑联邦理工

【论文链接】https://doi.org/10.1101/2022.03.29.486219

【代码链接】https://zenodo.org/record/7096792

带有注意力的自监督语言模型近来被广泛应用于生物序列数据,并推进了结构、功能和突变效应的预测。一些蛋白质语言模型,包括MSA Transformer和AlphaFold的EvoFormer,将进化相关蛋白质的多序列比对(MSA)作为输入,MSA Transformer的行注意力的简单组合获得了目前最先进的无监督结构接触预测结果。本文证明,MSA Transformer的列注意力与MSA中序列之间的汉明距离密切相关,故而作者得出结论基于MSA的语言模型编码了详细的系统发育关系。本文进一步表明,这些模型可以将编码功能和结构约束的共进化信号与反映历史偶然性的系统发育相关关系分开。为了评估这一点,本文从在天然MSA上训练的Potts模型中生成了没有系统发育的合成MSA,或有系统发育的合成MSA。本文发现,相比于Potts模型,在使用MSA Transformer进行无监督的接触图预测时,模型对系统发育的噪音有一定适应性。

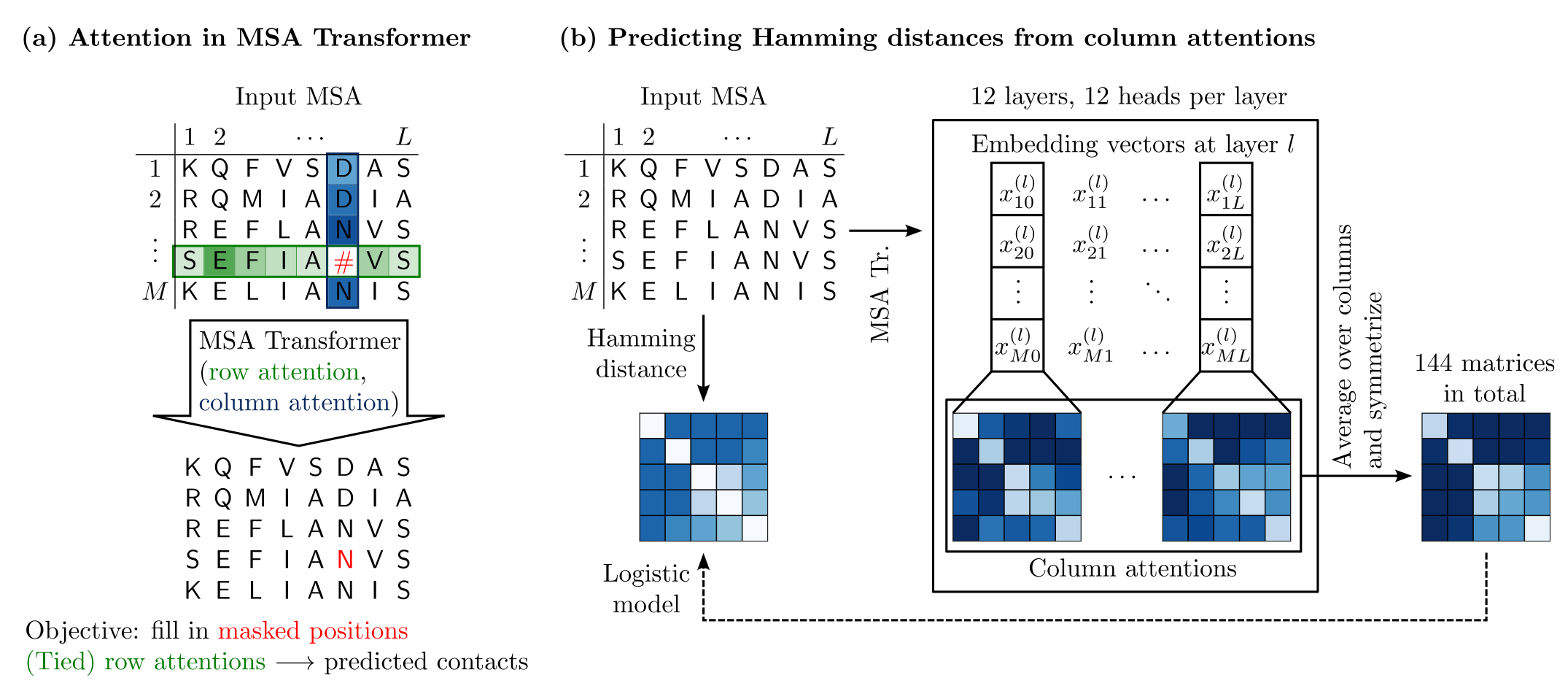

上图展示了Meta开发的MSA transformer的架构。

MSA Transformer使用遮蔽语言模型的任务进行训练,即预测MSA中随机遮蔽的残基。对于输入MSA中的每个位置,它将注意力分数分配给MSA中同一行(序列)和同一列(位点)的所有残基,网络包含12个独立的行/列注意力头。本文对汉明距离矩阵的预测方法来自于由MSA transformer模型计算出的列注意力。

列注意力细节如下:

描述中M为层数(MSA数量),L为列数(序列长度),h为头数。

对于由l层的行注意力块输出的M×(L+1)×d矩阵中的第j列信息Xj(l),模型学习三个d×d矩阵Wq(l,h)、Wk(l,h)和Wv(l,h),用来获得三个M×d矩阵类似Q_j(l,h)=Xj(l)Wq(l,h)等形式得到的Q、K和V向量, 从而实现列注意力层面的QKV,并最终获得M×M矩阵的列注意力:

softmax_row(Q_j(l,h)K_j(l,h)T/sqrt(d))

其中,使用softmax_row表示对矩阵的每一行独立应用softmax,后续处理如同标准的Transformer架构一样,与V相乘后接入前馈层。

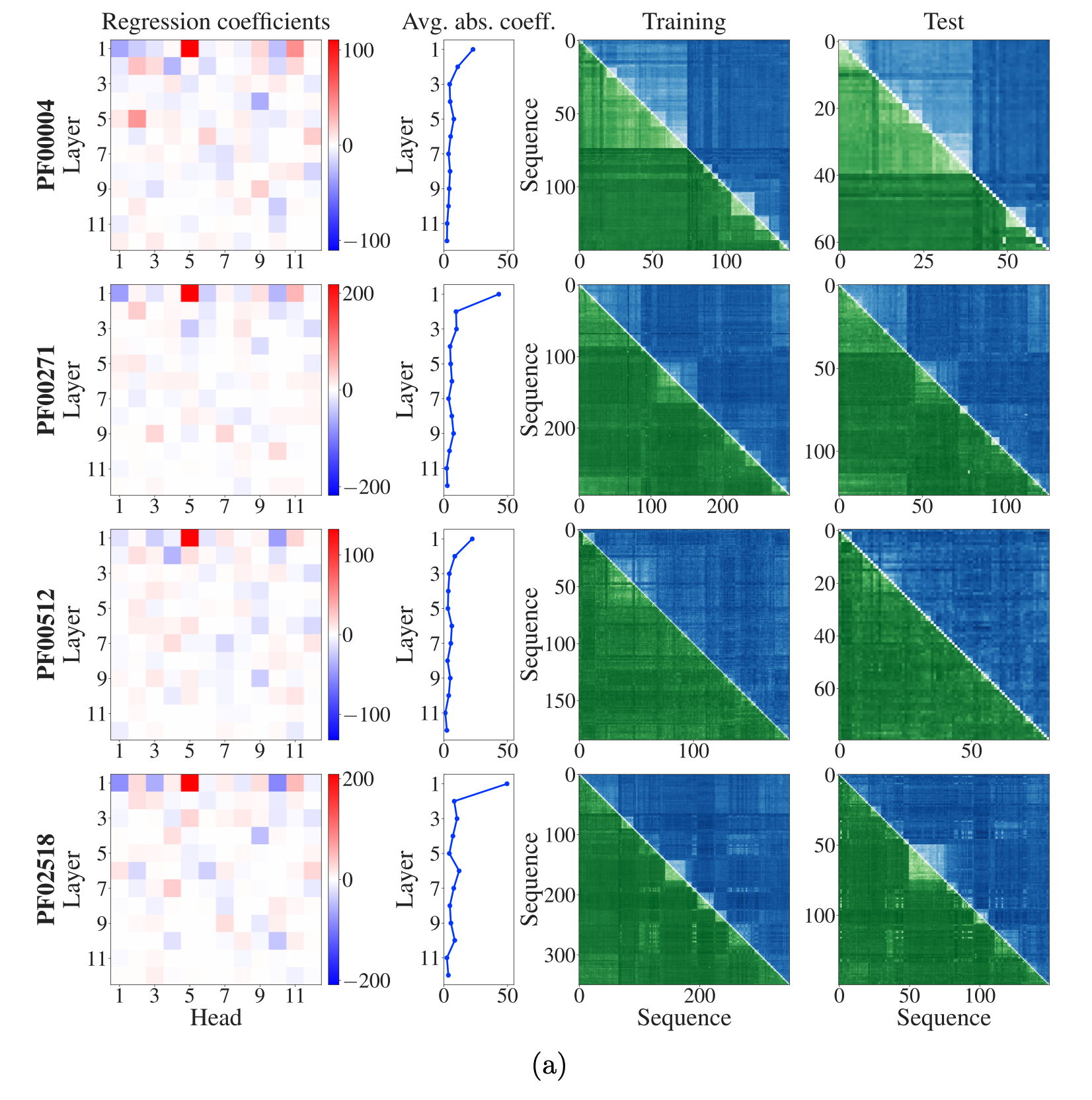

上图展示了通过MSA transformer预测汉明距离的模型结果。

MSA transformer的列注意头的列平均值被使用逻辑模型的概率预测归一化的汉明距离。每个MSA被随机分成一个由70%的序列组成的训练集和一个由其余序列组成的测试集。对于每个MSA,在训练集的所有成对距离上训练一个逻辑模型。左图第一部分展示了每个层和注意力头的回归系数,第二部分展示了每个层的各个头的平均值,可以发现些组合中较大的系数是在网络的浅层中发现的。

右侧展示了四个例子,真实汉明距离显示为上半的蓝色三角形,预测的汉明距离显示为下半的绿色三角形,较深的色调对应于较大的汉明距离,可以看到两者较好的预测效果。

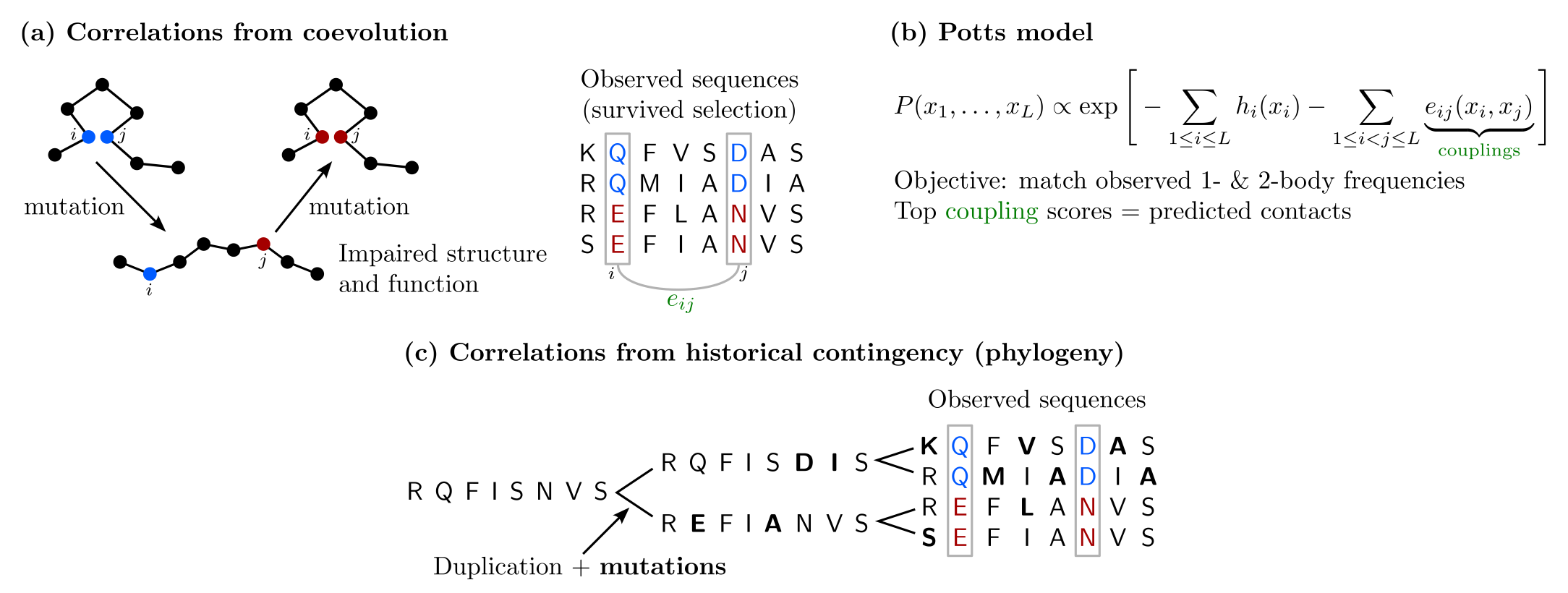

上图展示了来自共进化和系统发育的MSA的相关性。

(a) 结构和功能的自然选择导致了MSA中残基位置之间的共进化。MSA Transformer在论文中已经展示了它可以通过其绑定的行注意力头来捕捉结构上的三维接触,本文则表明它也通过其列注意头来捕捉汉明距离,从而捕捉系统发育的情况。在MSA的列之间观察到的相关性既可以来自于功能约束导致的共进化,也可以来自于系统发育。MSA transformer如何有效地将相关性从接触和系统发育中分离出来?本文在结构预测的具体案例中解决这个问题。

(b) Potts模型,此处为DCA,旨在捕捉其成对耦合中的这些关联性。由于来自接触和系统发育的相关性总是同时存在于自然数据中,本文通过从Potts模型中MCMC采样构建了受控的合成数据,可以在平衡状态下独立采样,也可以沿着使用FastTree从自然MSA推断出的系统发育树采样,以哈密顿值作为损失判断接受,根据系统发育树的分支长度决定突变数量。

通过这样生成MSA并进行Potts模型/Msa transformer模型的无监督结构预测,可以发现:

1.与DCA的接触推断相比,MSA Transformer的接触推断受系统发育相关性的影响较小。这种适应性可能解释了这样一个显著的结果:即使MSA Transformer的预训练数据集的降低了多样性,MSA Transformer对结构性接触的预测也比Potts模型更准确。

2.在没有系统发育的情况下生成的合成MSA上,DCA的表现比MSA Transformer好。由于这些序列是从自然MSA推断出的Potts模型中独立采样并处于平衡状态,因此根据定义,它们是由Potts模型很好描述的。

3.MSA Transformer倾向于从DCA生成的合成数据中恢复实验真实接触图。具体来说,一些在DCA推断和生成过程中部分丢失的二级结构特征在MSA Transformer的接触推断中又变得更清晰。这可能是因为MSA Transformer已经学会了接触图的结构,包括二级结构的空间紧凑性和形状。

(c) 即使在没有结构或功能约束(共进化)的情况下,历史上的偶然性(系统发育)也会导致相关性。

创新点

1.在MSA上计算的MSA Transformer的列注意力头的简单组合,与该MSA中的序列之间的汉明距离强相关。这表明,MSA Transformer编码了详细的系统发育关系。

2.本文证明MSA Transformer可以将编码功能和结构约束的共进化信号与历史偶然性产生的系统发育相关关系分开。

3.通过MSA Transformer进行的无监督接触预测比使用推断的Potts模型进行的接触预测对系统发育的噪声具有更强的适应性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢