论文地址:https://arxiv.org/pdf/2205.03962.pdf

开源代码:https://github.com/HavenFeng/TRUST

摘要

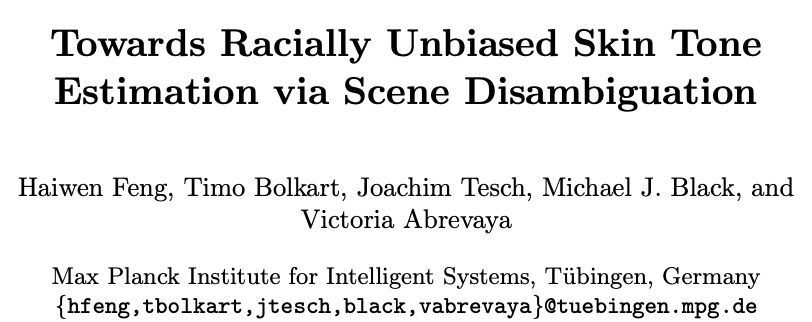

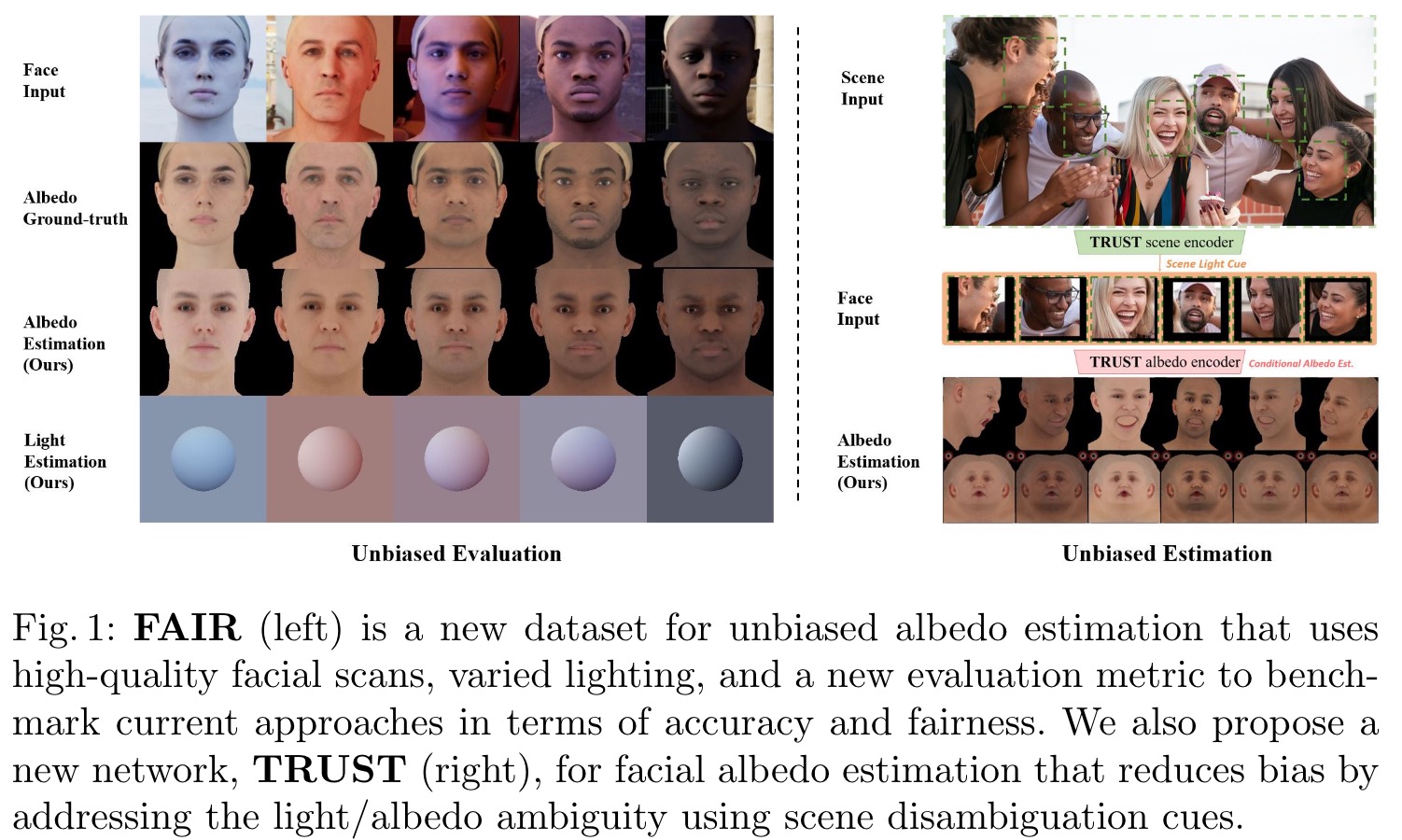

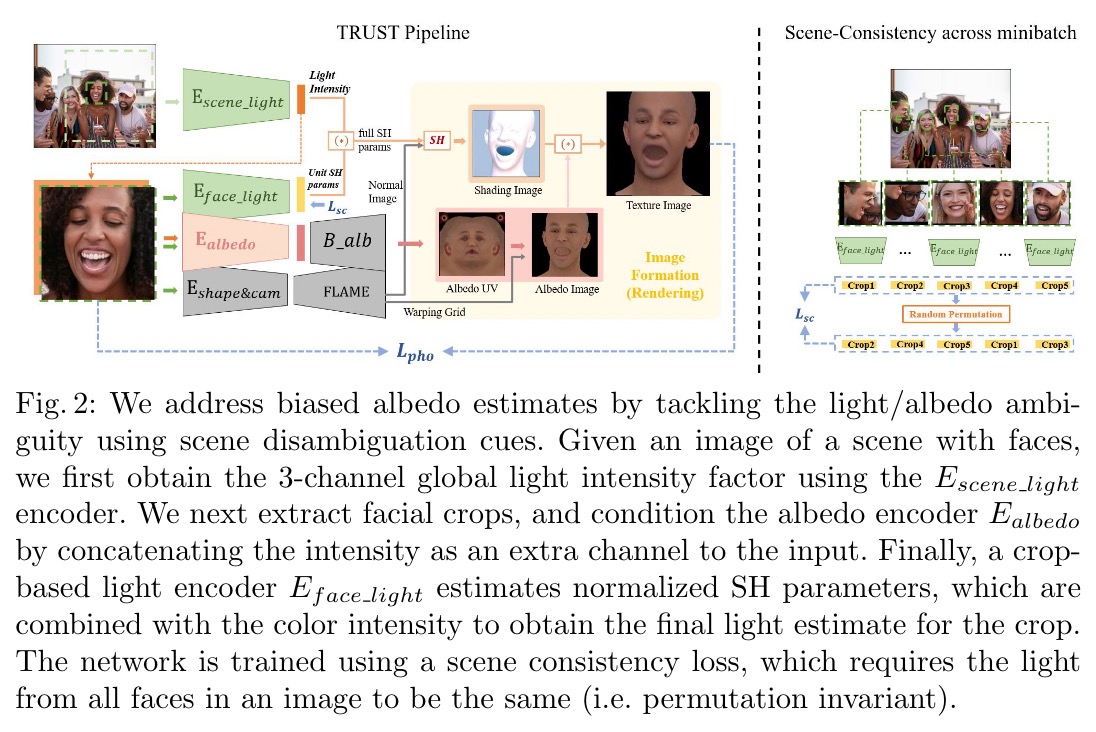

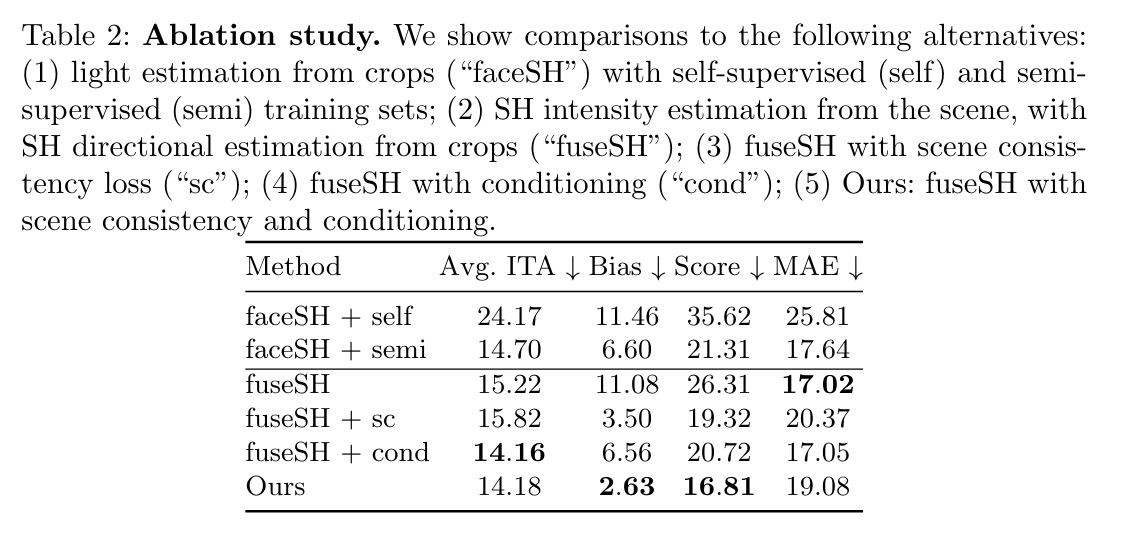

虚拟面部头像将在沉浸式交流、游戏和虚拟世界中发挥越来越重要的作用,因此它们的包容性至关重要。这需要准确恢复反照率,无论年龄、性别或种族如何。虽然在估计 3D 面部几何形状方面取得了重大进展,但外观估计受到的关注较少。这项任务基本上是模棱两可的,因为观察到的颜色是反照率和光照的函数,这两者都是未知的。我们发现当前的方法偏向于浅肤色,这是由于(1)偏爱较浅色素沉着的强烈偏见先验和(2)忽略光/反照率模糊性的算法解决方案。为了解决这个问题,我们提出了一个新的评估数据集(FAIR)和一个算法(TRUST)来改进反照率估计,从而提高公平性。具体来说,我们创建了第一个面部反照率评估基准,其中受试者在肤色方面得到平衡,并使用个体类型角度 (ITA) 度量来测量准确性。然后,我们通过一个关键观察来解决光/反照率的模糊性:完整场景的图像——与面部的裁剪图像相反——包含有关可用于消歧的照明的重要信息。 TRUST 通过调节面部区域和从场景图像中获得的全局照明信号来回归面部反照率。与最先进的反照率估计方法相比,我们的实验结果显示出在准确性和公平性方面的显着改进。

主要贡献

概括地说,我们的贡献是:(1)我们识别、分析和量化了有偏人脸反照率估计问题。(2)我们提出了一个新的综合基准,以及从肤色和多样性的角度来衡量性能的新指标。(3)我们提出了一种反照率估计的解决方案,通过场景消歧提示显式地解决光/反照率模糊问题,显著地提高了公平性。(4)基准、代码和模型可公开用于研究目的。

实验

我们在PyTorch[47]中实现了我们的方法,使用Pytorch3D[52]中的可区分光栅化器进行渲染。我们使用Adam[31]作为优化器,学习速率为1E-4。所有编码器都使用Resnet-50架构,输入图像大小为224×224(在全场景图像的情况下,我们首先随机裁剪一个正方形,然后调整大小)。紫外空间尺寸为d=256。利用DECA[22]对火焰参数β=100和φ=50进行回归,得到火焰的形状、表情和摄像机参数。为了用真实数据进行训练,我们使用OpenImages dataset[35]中包含人脸的子集。我们采用两阶段训练策略。第一阶段采用全监督训练,使用一个时代的合成数据集,批量为32。第二阶段使用半监督训练,批量大小为48个,所有建议损失为4个世代。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢