作者:Lewis Tunstall, Nils Reimers, Unso Eun Seo Jo 等

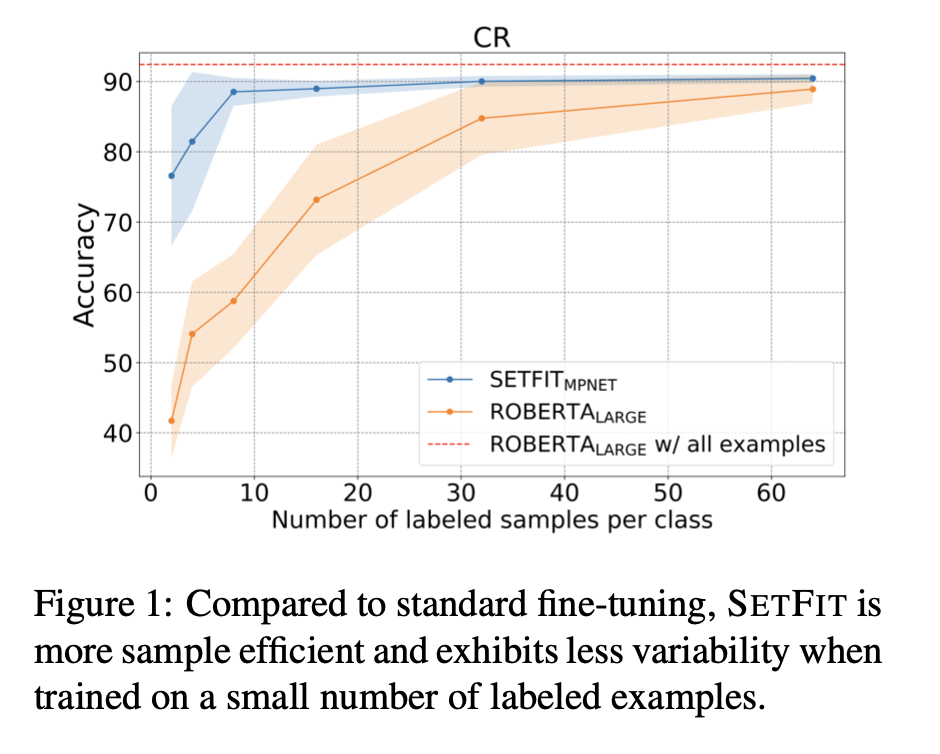

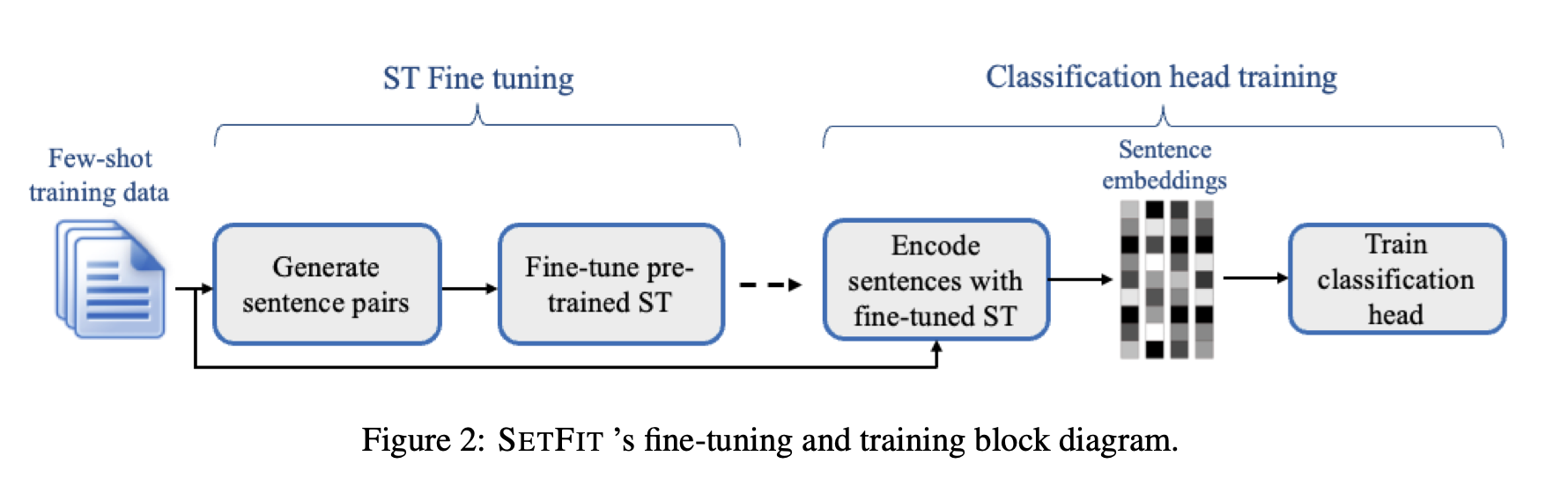

简介:本文的题目是Efficient Few-Shot Learning Without Prompts,主要研究:基于句子Transformer(ST)的小样本学习框架。最近的一些小样本方法,例如参数有效微调(PEFT)和模式开发训练(PET),在标签稀缺的环境中取得了令人印象深刻的结果。然而,这些方法通常很难使用,因为受到手工编制的Prompt的高度可变性的影响,并且通常需要十亿个参数语言模型才能实现高精度。为了解决这些缺点,作者提出了SetFit(句子Transformer微调),这是一种高效、快速的ST微调框架。SetFit的工作原理是首先以一种对比的Siamese方式对少量文本对上的预处理ST进行微调。然后使用生成的模型生成富文本嵌入、以便用于训练分类头。这个简单的框架不需要提示符或描述器,与现有技术相比,它的参数少了几个数量级,实现了高精度。实验表明:SetFit获得了与PEFT和PET技术相当的结果,同时训练速度快了一个数量级。作者还表明:通过简单地切换ST主体,SetFit可以应用于多语言设置。本文的的代码与数据集已开源。

论文下载: https://arxiv.org/pdf/2209.11055.pdf

代码下载: https://github.com/huggingface/setfit

数据集下载: https://huggingface.co/setfit

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢