收录情况:AAAI-2022

论文链接:https://arxiv.org/abs/2109.05014

代码链接:https://github.com/microsoft/PICa

问题

Knowledge-based visual question answering(VQA)是指模型不仅需要图像的视觉信息和问题的语义信息,还需要图像中的对象所蕴含的外部知识才能够正确的回答问题,例如模型在回答“图像中涉及到的八大奇迹之一全长是多少?”这一问题时,模型不仅要识别出图像中的八大奇迹之一万里长城,更需要外部知识来回答这个问题。

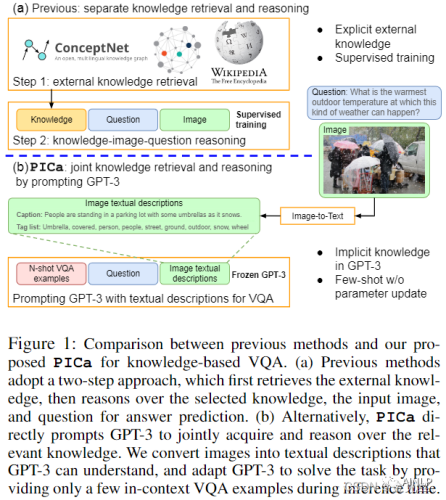

现有的方法首先从外部知识资源库中检索知识,然后对检索到的知识、输入图像和问题进行融合推理,进行答案预测。然而,这种两阶段方法可能会导致不匹配,从而潜在地限制VQA的性能。例如,检索到的知识可能是有噪声的,与问题含义无关;推理过程中re-embedded的知识特征可能偏离知识库中的原始含义。此外,学习一个健壮的知识-图像-问题联合表征需要足够的训练数据,因此很难迁移到新的问题类型。

方案

作者提出PICa,这是一种将上述知识检索和推理步骤统一起来的一种简单而有效的方法,通过使用Image Captions作为GPT-3的Prompts,用于knowledge-based VQA。受GPT-3在知识检索和问答方面的强大功能的启发,PICa没有像以前的工作那样使用显式和结构化的知识库(KBs),而是通过Prompts将GPT-3视为可以同时获取和处理相关知识的隐式、非结构化的知识库。如图1所示,首先将图像转换为GPT-3可以理解的captions(或labels),然后通过仅提供少量in-context VQA示例调整GPT-3,以few-shot的方式解决VQA任务。

作者通过仔细研究两个问题进一步提高性能:(i)什么样的文本格式可以最好地描述图像内容;(ii)如何更好地选择和使用in-context VQA示例。PICa是GPT-3在多模态任务中的首次使用。通过仅使用16个in-context VQA示例,PICa在OK-VQA数据集中以绝对+8.6分的优势超越了有监督的最先进水平。在VQAv2上对PICa进行了基准测试,也显示了不错的few-shot性能。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢