作者:Ajay Patel, Bryan Li, Mohammad Sadegh Rasooli,等

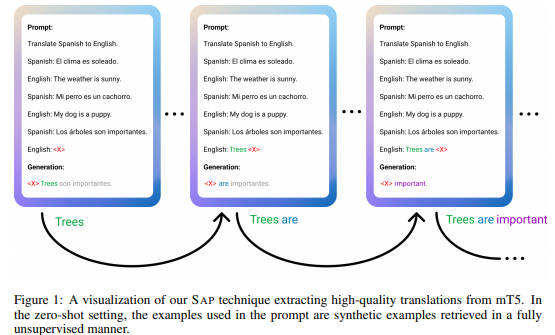

简介:大型语言模型(例如 GPT-3)可以执行任意任务,而无需在仅使用几个标记示例进行提示后进行微调。可以将任意任务重新表述为自然语言提示,并且可以要求语言模型生成完成,以称为基于提示的学习的范式间接执行任务。迄今为止,基于紧急提示的学习能力主要针对单向语言模型进行了展示。然而,在去噪目标(如掩码语言建模)上预训练的双向语言模型为迁移学习提供了更强的学习表示。这激发了提示双向模型的可能性,但它们的预训练目标使它们在很大程度上与现有的提示范式不兼容。作者介绍了 SAP(顺序自回归提示):一种能够提示双向模型的技术。利用机器翻译任务作为案例研究,作者使用 SAP 提示双向 mT5 模型,并证明其小样本和零样本翻译优于 GPT-3 等单向模型的少样本翻译和 XGLM,尽管 mT5 的参数减少了大约 50%。作者进一步表明 SAP 在问答和总结方面是有效的。作者的结果第一次证明,基于提示的学习是更广泛的语言模型类别的新兴属性,而不仅仅是单向模型。

论文下载:https://arxiv.org/pdf/2209.14500.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢