神经网络压缩一直被视为机器学习模型从实验室走向工业应用中的不可或缺的一步,而量化 (quantization) 又是神经网络压缩中最常用的方法之一。今天这篇 NeurIPS 论文 BiT 从实验和理论验证了极端压缩情况下的 1-bit 的 BERT 网络也能在自然语言处理的分类数据集 GLUE 上取得接近全精度网络的结果,将与全精度网络差距从之前方法的 16% 缩小到了仅 6%,被审稿人称赞是一篇实验扎实、有借鉴意义的论文。

论文地址:https://arxiv.org/abs/2205.13016

代码地址:https://github.com/facebookresearch/bit

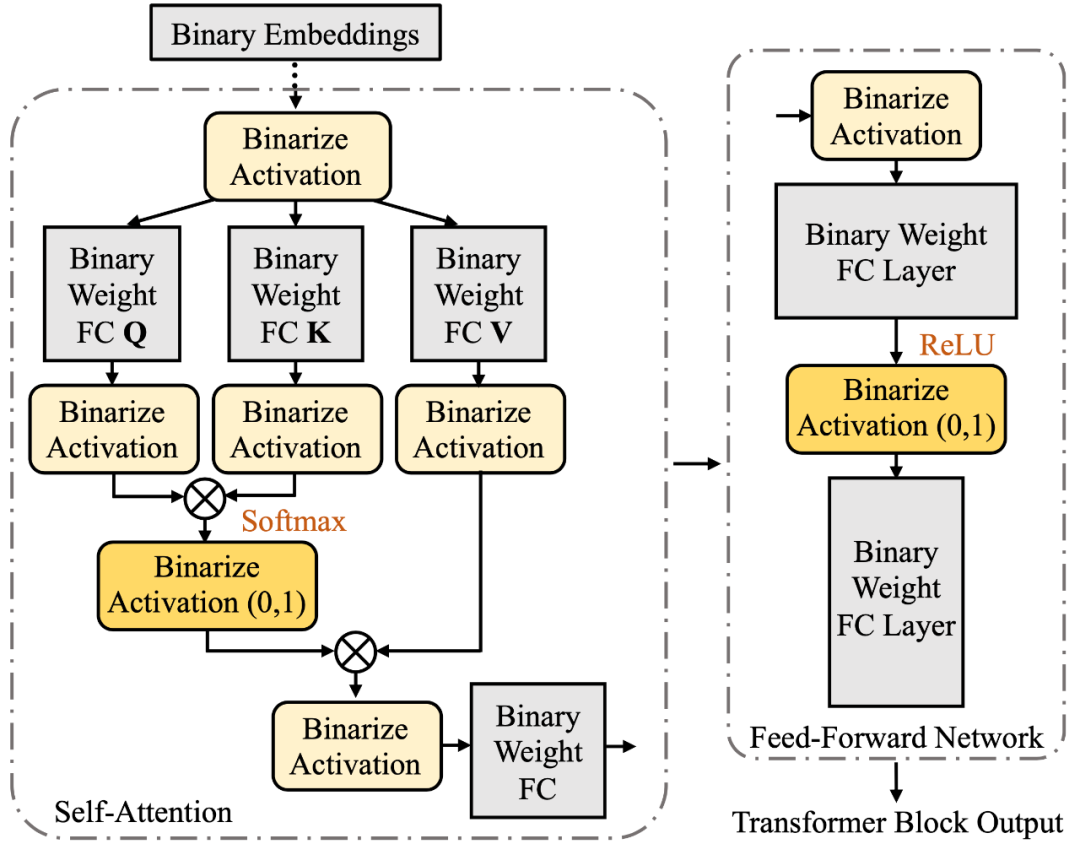

BiT 论文的方法主要分为两个部分: (1) 自由度更高的二值化方法 (2) 采用与 student 网络更相近的 teacher 网络进行知识蒸馏。

方法

作者发现,在 transformer block 中, 有两层的输出激活值 (activation) 是非负的,即 Softmax 的输出和前馈网络中的 ReLU 的输出(BiT 采用 ReLU 作为非线性函数),所以作者提出将这些非负的激活值二值化成 {0,1}, 而将其他实数值激活层二值化成{-1,1}, 从而最大程度减小二值化激活值和实数激活值之间的分布差距。

如下图所示

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢