作者:Xu Guo, Boyang Li and Han Yu

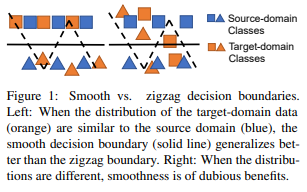

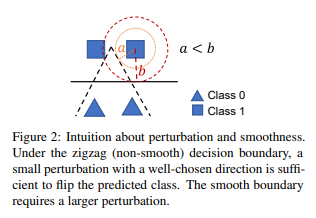

简介:提示调优,或使用从数据中学习到的软提示对冻结的预训练语言模型 (PLM) 进行调节,已经在广泛的 NLP 任务中展示了令人印象深刻的性能。但是,提示调优需要大型训练数据集才能有效,并且在数据稀缺的情况下对整个 PLM 进行微调时效果要好得多。以前的研究者曾提出:将在源域上预训练的软提示转移到目标域。在本文中,作者探索了用于提示调优的域适应,这是关于:目标域的未标记数据在预训练期间有效可用的问题。作者建议使用 doMain Adaptation (OPTIMA) 增强提示调优,它将决策边界规范化为在源和目标数据分布相似的区域周围平滑。大量实验表明:与强基线相比,OPTIMA 显着提高了提示调优的可转移性和样本效率。此外,在小样本场景中,OPTIMA 大大超过了全模型调优。

论文下载:https://arxiv.org/pdf/2210.02952.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢