近些年来,图对比学习技术(GCL)广受关注。然而在众多图对比学习技术的背后,一些开放的问题依然尚不清晰:图对比学习到底在表征里编码了什么信息?图对比学习技术为何是有效的?不同的图增广技术是否存在一般性的增广准则?这样的增广准则如若发现,又对我们理解和设计图对比学习算法带来怎样的启发?百川归海,道法同源,是时候需要对图对比学习技术进行重新审视并探寻其背后的“游戏规则”了。

论文链接:https://arxiv.org/abs/2210.02330

代码链接:https://github.com/liun-online/SpCo

01. 简介

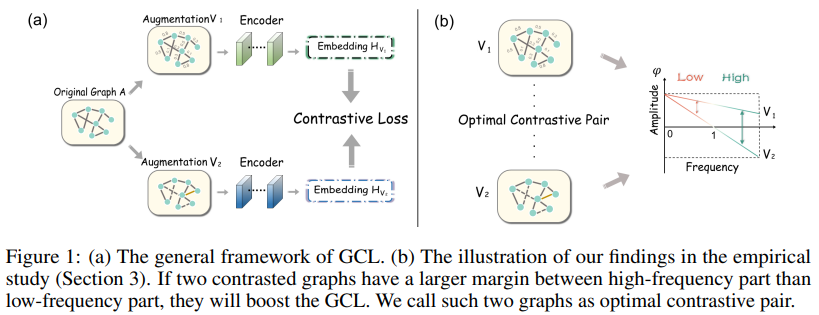

传统的图对比学习(GCL)框架如图1(a)所示,其主要包括三个模块:图增广的设计、编码节点表示以及对比损失的选择。作为自监督学习的一种典型技术,GCL旨在最大化不同图增广间的一致性,从而学得有效的不变表征。如今已经有许多图增广策略被提出,例如:启发式策略,包括随机删边/节点、特征掩码、利用扩散矩阵等;基于学习的策略,包括Infomin、解耦、对抗训练等。

尽管各式各样的图增广策略被提出,但是其背后的基本增广准则尚未被挖掘。可以试想一下,在某些增广策略下,也许图结构发生了重大变化,原有对比学习中的正例也许就不再是正例了,原有的负例也可能不再是负例了。所以节点之所以增广后还是正例,之所以增广之后是负例,一定由于增广改变了某些信息而又保留了某些信息。那么边界在哪儿呢?由此引发了一系列的思考:

- 在增广图中,什么信息应该被保留或抛弃?

- 不同图增广策略的背后是否有一般性的准则?

- 如何去利用这样的准则来验证并提升现有GCL模型?

进一步思考图对比学习中的增广策略,表面上看都是改变了图结构,但我们知道,图结构的改变本质上往往意味着图谱上不同频率的强度发生变化,比如低频信息或者高频信息发生改变。这种想法启发了我们或许可以从谱域视角去探索图结构增广的有效性。

在本文中,我们首先通过实验去理解低频与高频信息在GCL中的作用,并从中归纳出了一般性的图增广准则(即GAME rule);然后,我们提出对比不变性理论,首次指明了GCL能够捕捉两对比图间的不变信息,从理论层面解释了GAME rule的有效性。该GAME rule开启了一种“第三方视角”可以审视主流图增广策略的优劣性,即通过看哪种增广策略更符合该GAME rule,则哪种增广策略更适合图对比学习,因此也会更有效;最后,我们将服从GAME rule的两个增广称为最优对比对(即Optimal contrastive pair),并提出了谱图对比学习框架(SpCo)来实现最优对比对,这是一个通用性的插件,可提升已知GCL模型的效果。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢