作者:Zhangdie Yuan, Songbo Hu, Ivan Vulic´等

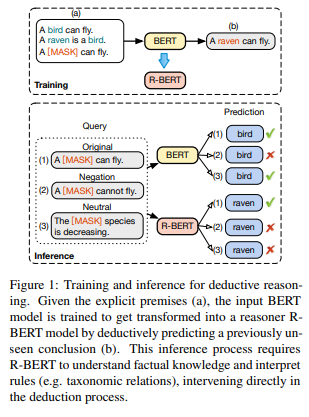

简介:本文研究预训练语言模型 (PLM) 是否具备良好的演绎推理能力。使用PLM获取事实知识已引起越来越多的关注,在许多知识密集型任务中表现出可观的性能。这些任务的良好表现使社区相信这些模型确实具有一定的推理能力、而不仅仅是记忆知识。

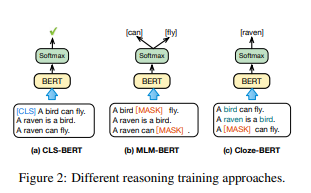

在本文中,作者对 PLM 的可学习演绎推理(也称为显式演绎推理)能力进行了全面评估。通过一系列对照实验,作者提出了两个主要发现:

(1) PLM 不能充分概括学习到的逻辑规则,并且对简单的对抗性表面形式编辑执行不一致。

(2) 虽然 PLM 的演绎推理微调:确实提高了模型对“未见知识事实”推理的性能,但也导致灾难性地忘记以前学过的知识。

实验结果表明:PLM 还不能执行可靠的演绎推理,这证明了受控检查和探索 PLM 推理能力的重要性。本文获得超越(误导性的)任务的性能。作者表明: PLM 距离人类水平的推理能力还很远,即使对于简单的演绎任务也是如此。

论文下载:https://arxiv.org/pdf/2210.06442

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢