作者: Jochem Loedeman, Maarten C. Stol, Tengda Han 等

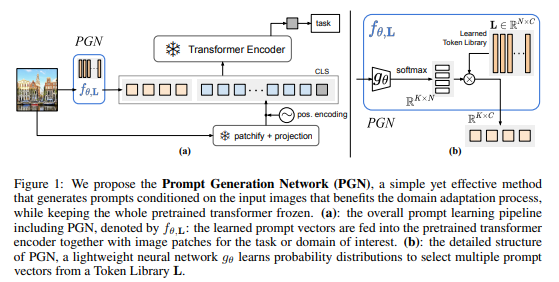

简介:本文主要研究有效的视觉Prompt学习框架。大规模预训练模型,尤其是那些从视觉语言数据训练的模型,已经证明了可以从更大的训练数据集和模型中获得的巨大价值。因此,为了从这些发展中受益,人们对迁移学习和将模型从大规模通用预训练适应特定下游任务重新产生了兴趣。然而,模型规模的不断增加意味着:即使是经典的微调方法也变得不可行,除非是大型机构。Prompt学习已经成为一种灵活的方式来适应模型,只需学习额外的输入到一个保持冻结的模型,但到目前为止,性能仍然不如微调。为了解决这个问题,作者提出了Prompt提示生成网络(PGN):通过从学习的令牌库中采样来生成依赖于输入的Prompt提示。

作者展示了 PGN 在使预训练模型适应各种新数据集方面是有效的。PGN大大超过了以前的Prompt学习方法,甚至在 12 个数据集中的 5 个上进行了完全微调、而同时需要的参数减少了 100 倍。PGN 甚至可以用于同时对多个数据集进行训练和推断,并学习在域之间分配令牌。

鉴于这些发现,作者得出结论:针对冷冻模型的下游任务,PGN 是一种可行且可扩展的方法!

论文下载:https://arxiv.org/pdf/2210.06466

代码下载:https://github.com/jochemloedeman/PGN

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢