【标题】Sample-Then-Optimize Batch Neural Thompson Sampling

【作者团队】Zhongxiang Dai, Yao Shu, Bryan Kian Hsiang Low, Patrick Jaillet

【发表日期】2022.10.13

【论文链接】https://arxiv.org/pdf/2210.06850.pdf

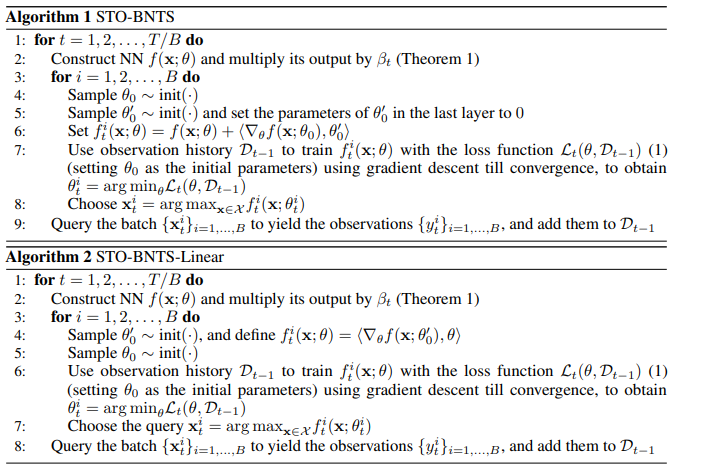

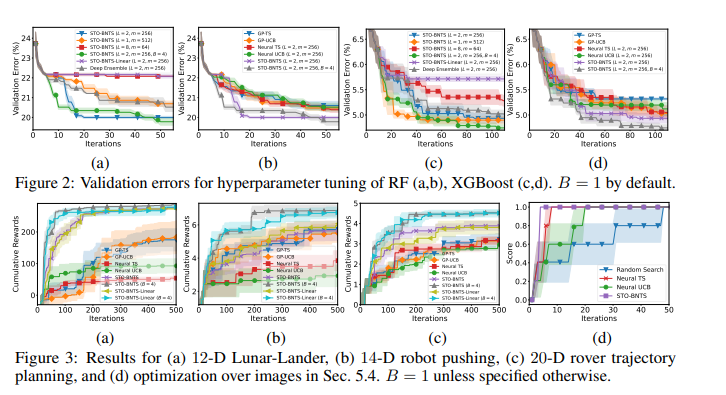

【推荐理由】贝叶斯优化(Bayesian optimization,BO)是一种流行的黑箱优化方法,它使用高斯过程(Gaussian process,GP)作为代理来建模其目标函数。由于相关局限性,BO在一些问题上表现不佳,例如具有分类、高维或图像输入的问题。为此,现有研究使用了高度表达的神经网络(NNs)作为替代模型,并使用神经切线核(NTK)理论推导了理论保证。然而,此类研究受到反转超大参数矩阵要求的限制以及顺序(而非批量)设置的限制。为此,本文引入了两种基于汤普森采样(TS)策略的算法,分别名为采样然后优化批处理神经TS(STO-BNTS)和STO-BNTS-Learline。为了选择一个输入查询,只需要训练一个NN(对应线性模型),然后通过最大化训练的NN(相应线性模型)来选择查询,该NN是从GP后验中等效采样的,NTK是核函数。因此,该算法避开了反转大参数矩阵的需要,但仍保持TS策略的有效性。并推导了该算法在批量评估时的后悔上界,并使用批处理BO和NTK的见解来证明它们在某些条件下是渐近无后悔的。最后,通过实际的AutoML和强化学习实验验证了该方法的实证有效性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢