来源:Proceedings of the 28th ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD 2022)

标题:Graph Neural Networks with Node-wise Architecture

作者:Zhen Wang, Zhewei Wei, Yaliang Li, Weirui Kuang, Bolin Ding

链接:https://dl.acm.org/doi/10.1145/3534678.3539387

内容简介

最近,GNN 的神经架构搜索 (NAS) 越来越受欢迎,因为它可以为给定的新图寻找最佳架构。本文提出了一个框架,其中参数控制器根据其局部模式决定每个节点的 GNN 架构。本文用深度、聚合器和分辨率控制器实例化本文的框架,然后详细说明学习主干 GNN 模型和控制器以鼓励他们的合作。根据经验,本文分别通过三个控制器引入的性能改进来证明节点架构的效果是合理的。此外,本文提出的框架在十个真实世界数据集中的五个上显着优于最先进的方法,其中这些数据集的多样性阻碍了任何基于图卷积的方法同时领先于它们。这一结果进一步证实了节点架构可以帮助 GNN 成为通用模型。

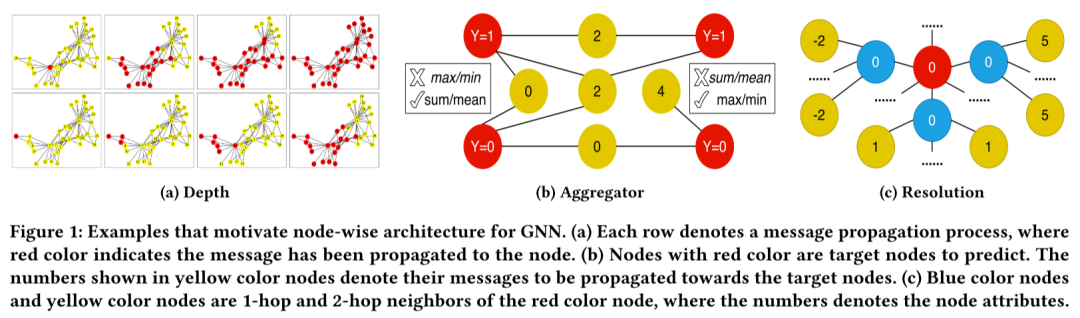

具体而言,本文在图 1 中展示了三个示例,从架构的三个不同方面证明了使用节点架构的必要性。

- (1) GNN 的不同节点可能需要不同的深度。比较图 1a 的两行,密集连接节点的消息传播速度比连接稀少节点的消息传播速度快得多。已经分析了这种现象,因为具有较大程度的节点随着图卷积操作的迭代而更快地产生过度平滑的节点嵌入。最近的工作研究了节点深度,以允许具有不同局部结构的节点具有不同的深度,同时避免过度平滑问题。这些作品从深度方面支持了本文的节点架构理念。

- (2) 不同的节点可能需要不同的聚合器。在图 1b 中,使用假设的类标签和传入消息,左侧的两个目标节点可以通过均值/和池成功区分,而右侧的两个节点需要一个最大值/最小值 池化。PNA使用这两对来激励 GNN 使用混合聚合器。在本文的案例中,本文强调以节点方式选择适当聚合器的必要性。

- (3) 本文提出了一个新概念,即 GNN 层的分辨率,即采样了多少邻居来聚合它们的消息。采样对于在大图上训练 GNN 模型是必要的,其中不同的分辨率通常会导致不同的计算图,从而导致应用 GNN 的架构。在实践中,广泛采用的邻居采样器对所有节点使用相同的 GNN 层预先指定的分辨率。然而,当一个节点的局部模式是图 1c 中所示的红色节点的情况时,从减少估计方差的意义上说,采样更多的 1 跳邻居比采样更多的 2 跳邻居要好。因此,该节点更喜欢第二层 GNN 的高分辨率,而对第一层的分辨率不敏感。

受这些观察的启发,本文研究如何以节点方式搜索最佳 GNN 架构。现有 NAS 方法的直接扩展将线性增加搜索空间的大小和节点的数量,这使得它在大规模图上难以处理。此外,这样的扩展只为训练期间可访问的节点搜索合适的架构,因此它无法在归纳设置下为测试节点生成合适的架构。为了应对这些挑战,本文提出了一个框架,其中架构的每个方面都有一个参数控制器,例如聚合器控制器,以决定应该应用哪种类型的聚合器。为了确定特定层节点的架构配置,控制器首先将节点的本地模式编码为上下文嵌入,然后根据它从搜索空间中进行选择。例如,当本文假设前一层节点的特征足以确定其在当前层所需的聚合器时,本文可以将前一层节点的嵌入馈送到聚合器控制器。直观地说,骨干 GNN 模型依赖于控制器来预测合适的架构,而控制器根据骨干模型捕获的节点的局部模式对每个节点进行预测。因此,本文设计了一种学习方法来促进主干模型和控制器之间的合作。由于本文的上下文感知控制器具有与节点数量无关的固定数量的参数,并且可以泛化到看不见的节点,因此所提出的框架即使在转导和归纳设置下的大规模图上也可以实现 GNN 模型的节点架构.值得注意的是,尽管本文用深度、聚合器和分辨率控制器实例化了所提出的框架,但为 GNN 架构的其他方面指定的控制器可以很容易地包含在本文的框架中。

作者在10个真实世界的图数据集上将本文提出的框架与最先进的方法进行比较。本文的方法在其中一半上实现了最佳性能,其中没有或最多一种基线方法可以达到本文的 95% 置信区间。此外,本文表现出色的数据集包括同质图和异质图,其中没有现有的基于图卷积的方法可以同时领先。同时,节点分辨率被证明可以提高 GNN 在大规模图上的性能。然后本文展示了控制器可以适当地将合适的节点深度、聚合器和分辨率与每个节点的局部模式相关联,这解释了节点架构如何提高 GNN 的性能。还从样本效率和运行时间的角度对实现这种节点架构的支付进行了经验评估。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢