论文标题:RTFormer: Efficient Design for Real-Time Semantic Segmentation with Transformer.

论文链接:https://arxiv.org/pdf/2210.07124.pdf

最近,基于Transformer的网络在语义分割方面取得了令人印象深刻的成果。然而,对于实时语义分割,由于Transformer的计算机制非常耗时,纯CNN方法仍然是该领域的主流。

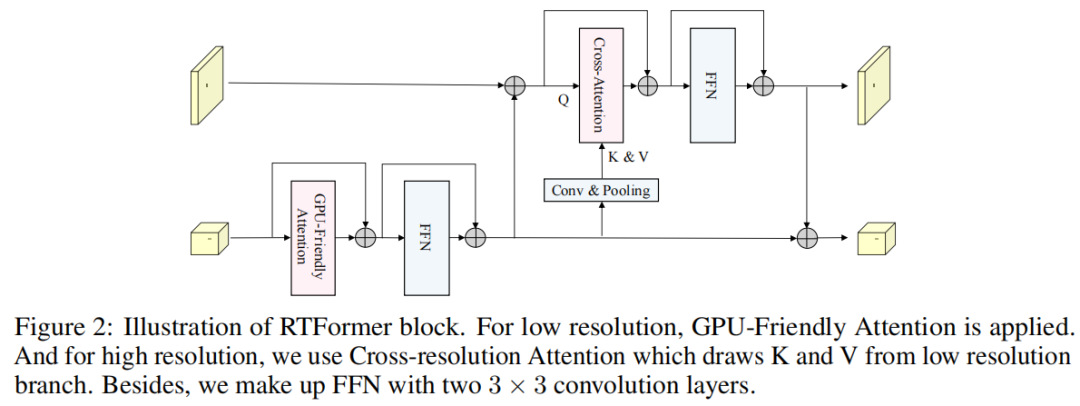

本文提出了RTFormer,一种用于实时语义分割的高效双分辨率Transformer,与基于CNN的模型相比,它在性能和效率之间取得了更好的平衡。为了在类似GPU的设备上实现高推理效率,RTFormer利用具有线性复杂性的GPU Friendly Attention,并放弃了多头机制。

此外,作者发现,通过传播从低分辨率分支学到的高层次知识,跨分辨率注意力更有效地为高分辨率分支收集全部上下文信息。

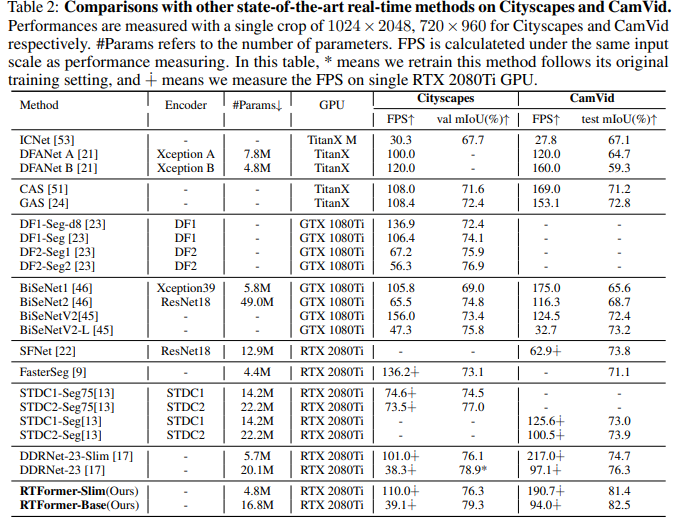

对主流基准测试的大量实验证明了提出的RTFormer的有效性,它在Cityscapes、CamVid和COCOStuff上达到了最先进的水平,并在ADE20K上显示出良好的结果。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢