作者:Hyung Won Chung,Le Hou,Shayne Longpre,等

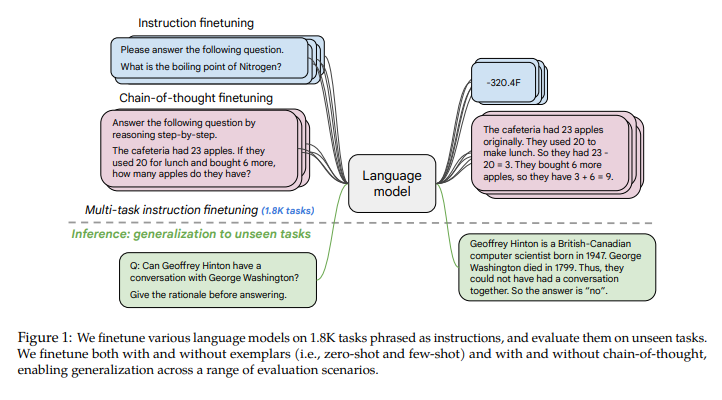

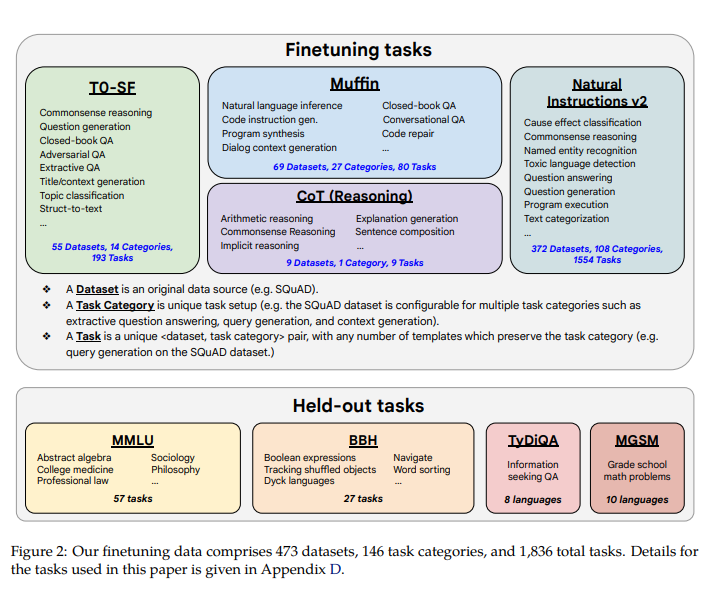

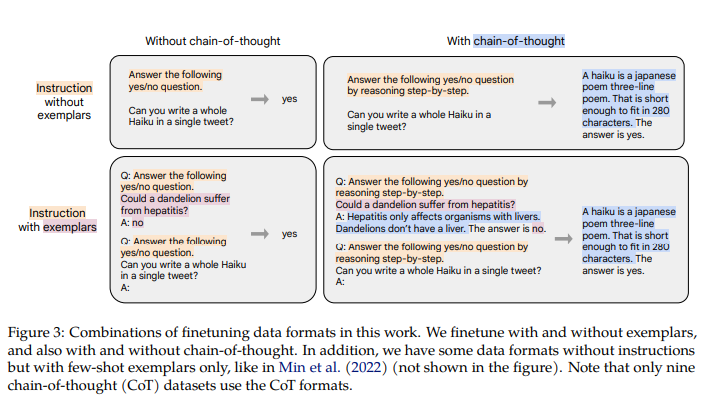

简介:本文提出新的微调方式:指令微调。在一组数据集上微调语言模型已被证明可以提高模型性能和对看不见的任务的泛化。在本文中,作者探讨了指令微调,特别关注(1)扩展任务数量,(2)扩展模型大小,以及(3)对思维链数据进行微调。作者发现具有上述方面的指令微调显着提高了各种模型类(PaLM、T5、U-PaLM)、prompt设置(zero-shot、few-shot、CoT)和评估基准(MMLU、BBH、 TyDiQA、MGSM、开放式生成)。例如:在 1.8K 任务上进行指令微调的 Flan-PaLM 540B 大大优于 PALM 540B(平均 + 9.4%)。Flan-PaLM 540B 在多个基准测试中实现了最先进的性能,例如:在五次 MMLU 上达到 75.2%。作者还公开发布了 Flan-T5 检查点,即使与更大的模型(例如 PaLM 62B)相比,它也能实现强大的小样本性能。总体而言,指令微调是提高预训练语言模型的性能和可用性的通用方法。

论文下载:https://arxiv.org/pdf/2210.11416.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢