作者:Zhaofeng Wu, Robert L. Logan IV, Pete Walsh, 等

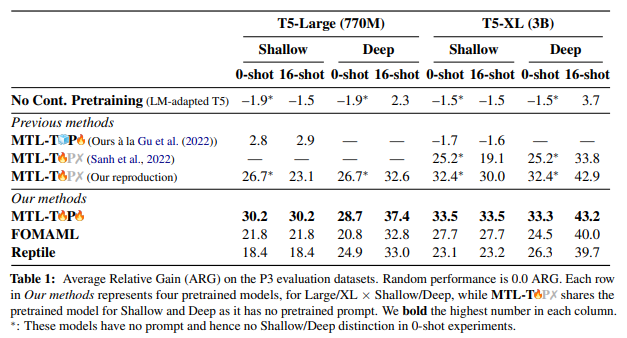

简介:本文研究通过持续预训练提升更好的可提示性。最近引入的语言模型Prompt提示方法可以在零样本和小样本场景中实现高精度,同时需要很少甚至不需要学习的特定任务参数。尽管如此,这些方法仍然经常落后于完整的模型微调。在这项工作中,作者调查了一个专门的持续预训练阶段是否可以提高“提示性能”,即自然语言Prompt提示的零样本性能或少样本性能。作者揭示了现有持续预训练方法缺乏及时性的状况。作者还确定了当前的方法学空白,作者通过彻底的大规模实验来填补这些空白。本文展示了一个简单的方法,即在多任务学习期间包含可训练Prompt提示的持续预训练,与现有方法相比,在零样本和少样本场景中的可提示性提高了 31%。另一方面,作者发现使用 MAML 风格的元学习(一种直接优化小样本可提示性的方法)进行持续预训练会产生低于标准的性能。作者使用两种Prompt调优方法验证了作者的发现,并且根据实验结果,作者提供了具体的建议、以便优化不同用例的可提示性。

论文下载:https://arxiv.org/pdf/2210.10258.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢