【标题】CEIP: Combining Explicit and Implicit Priors for Reinforcement Learning with Demonstrations

【作者团队】Kai Yan, Alexander G. Schwing, Yu-Xiong Wang

【发表日期】2022.10.18

【论文链接】https://arxiv.org/pdf/2210.09496.pdf

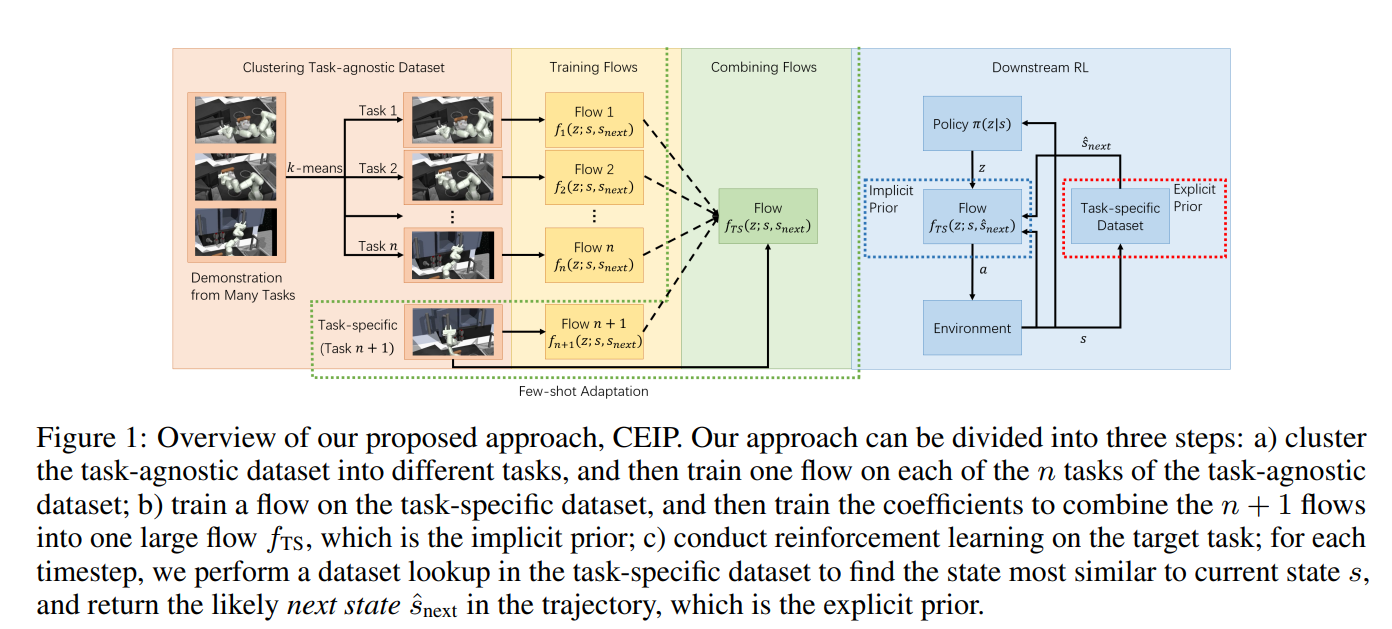

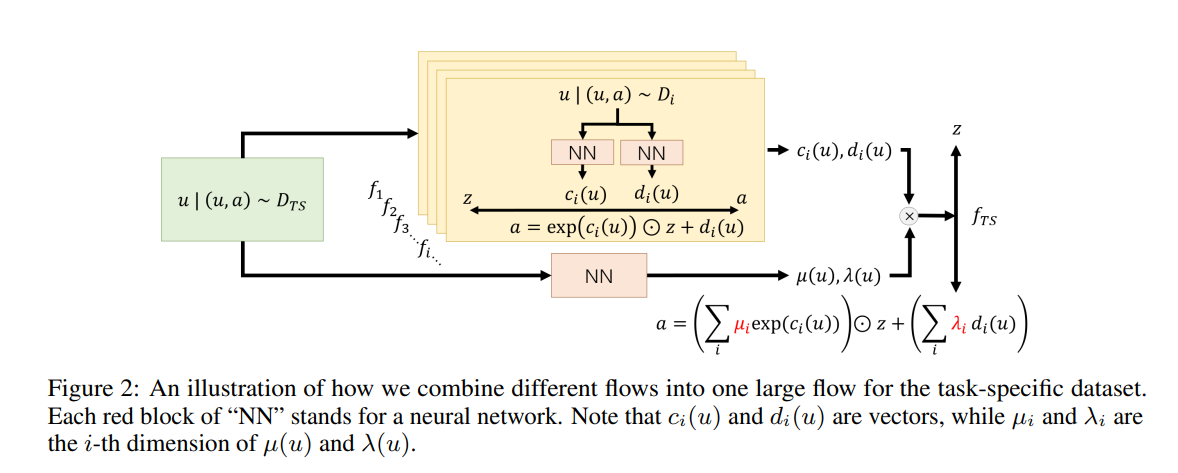

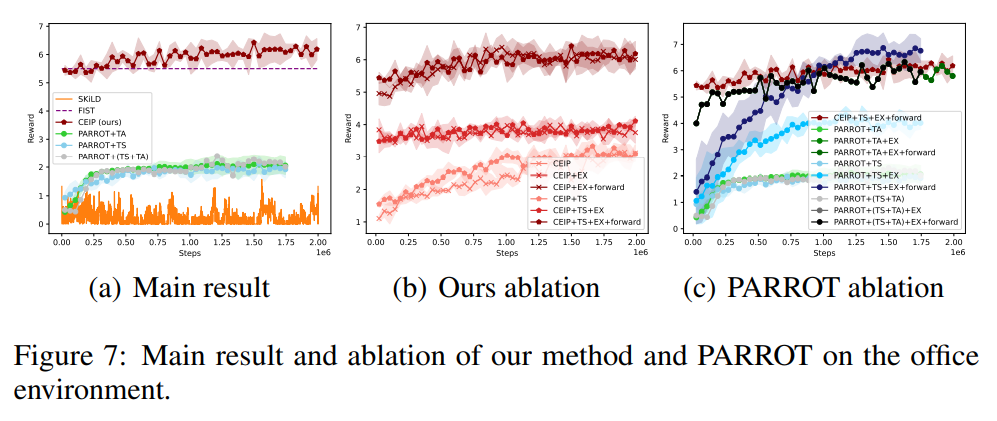

【推荐理由】尽管强化学习在密集奖励环境中得到了广泛应用,但训练具有稀疏奖励的自主智能体仍然具有挑战性。为了解决这一困难,以前的研究表明,当不仅使用特定任务的演示,而且使用与任务无关的演示(尽管有点相关)时,结果是有希望的。在大多数情况下,可用的演示被提炼为隐式先验,通常通过单个深层网络表示。可以查询的数据库形式的显式先验也已被证明能带来令人鼓舞的结果。为了更好地利用现有的演示,本文提出了一种结合显式和隐式先验(CEIP)的方法。CEIP以并行规范化流的形式利用多个隐式先验来形成单个复杂先验。此外,CEIP使用有效的显式检索和前推机制来调节隐式先验。在三个具有挑战性的环境中,本文提出的CEIP方法可以改进复杂的最先进方法。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢