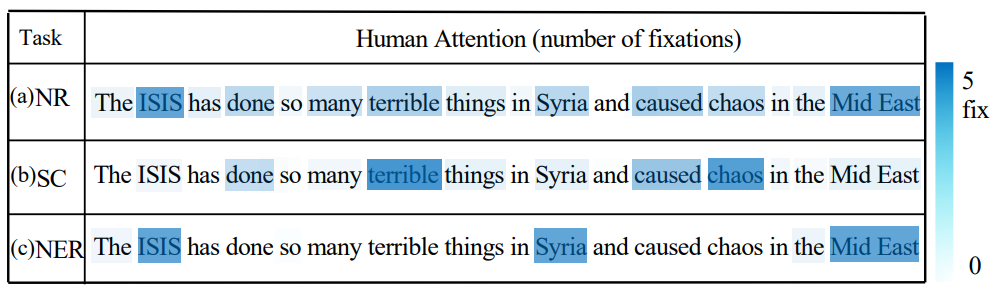

本文研究了利用认知语言处理信号(如眼球追踪或EEG数据)指导BERT等预训练模型的问题。现有的方法通常利用认知数据对预训练模型进行微调,忽略了文本和认知信号之间的语义差距。为了填补这一空白,我们提出了CogBERT这个框架,它可以从认知数据中诱导出细粒度的认知特征,并通过自适应调整不同NLP任务的认知特征的权重将认知特征纳入BERT。实验结果表明:(1) 认知指导下的预训练模型在10个NLP任务上可以一致地比基线预训练模型表现更好。(2) 不同的认知特征对不同的NLP任务有不同的贡献。基于这一观察,我们给出为什么认知数据对自然语言理解有帮助的一个细化解释。(3) 预训练模型的不同transformer层应该编码不同的认知特征,词汇级的认知特征在transformer层底部,语义级的认知特征在transformer层顶部。(4) 注意力可视化证明了CogBERT可以与人类的凝视模式保持一致,并提高其自然语言理解能力。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢