作者:Yupeng Zhang, Hongzhi Zhang, Sirui Wang, Wei Wu, Zhoujun Li

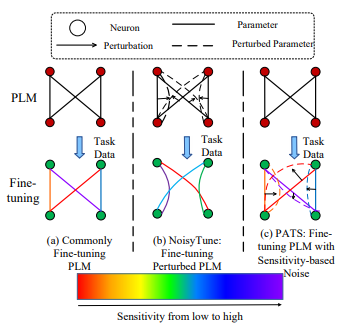

简介:本文研究新的噪声训练方法来优化预训练语言模型 (PLM)的微调。广泛的 NLP 任务受益于PLM 的微调。然而,在直接微调的模型中观察到许多对下游任务贡献较小的冗余参数。作者认为预训练和下游任务之间的差距阻碍了这些冗余参数的训练,并导致整个模型的性能欠佳。在本文中,作者提出了 PATS(根据灵敏度的扰动):一种噪声训练机制,旨在考虑每个参数在下游任务中的重要性、以帮助微调 PLM。PATS 的主要思想是给敏感度较低的参数添加较大的噪声,反之亦然,以激活更多参数对下游任务的贡献,而不会对敏感的参数产生太大影响。在GLUE基准测试的八个任务上进行的大量实验表明:PATS可以持续提高PLM在下游任务上的性能,同时参数的敏感性更为集中,这在小数据集上尤为明显。

论文下载:https://arxiv.org/pdf/2210.12403.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢