作者:Victor S. Bursztyn, David Demeter, Doug Downey, 等

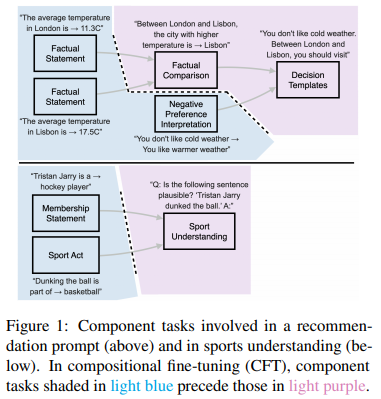

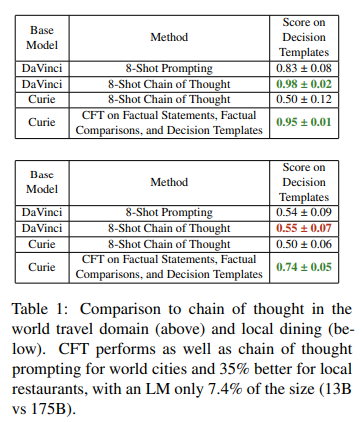

简介:本文提出组合微调、并建议用于端到端学习的改进。如何有效地编码组合任务结构,一直是人工智能的核心挑战。最近在思路提示链(chain of thought prompting)方面的工作表明,对于非常大的神经语言模型 (LMs),明确展示目标任务中涉及的推理步骤可能会比仅关注目标任务的端到端学习提高性能。然而,由于依赖于大量预训练的 LM,思维提示链有很大的局限性。在这项工作中,作者提出了组合微调 (CFT):一种基于将目标任务显式分解为组件任务的方法,然后在此类组件任务的课程中微调较小的 LM。作者将 CFT 应用于世界旅行和当地餐饮两个领域的推荐任务,以及之前研究过的推理任务(运动理解)。作者表明:即使在数据量相同的情况下,CFT 也优于端到端学习,并且随着更多组件任务通过微调进行建模,CFT 会变得更好。与思维链Prompt相比,CFT比使用LM时表现良好、而CFT仅为其大小7.4%,并且CFT且适用于在预训练期间数据不可用的任务域。

论文下载:https://arxiv.org/pdf/2210.12607.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢