近年来,Transformer 已经成为了 NLP 和 CV 等领域的主流模型,但庞大的模型参数限制了它的高效训练和推理。于是字节跳动在 2019 年 12 月和 2021 年 6 月分别推出了高效推理和训练引擎 LightSeq,大大加速了 Transformer 系列模型的训练和推理,也打通了 Transformer 从训练到推理的整个流程,极大优化了用户使用体验。最近,LightSeq 训练引擎相关论文,被录用难度极高的超算领域国际顶会 SC22 接收,得到了学术界的广泛认可!

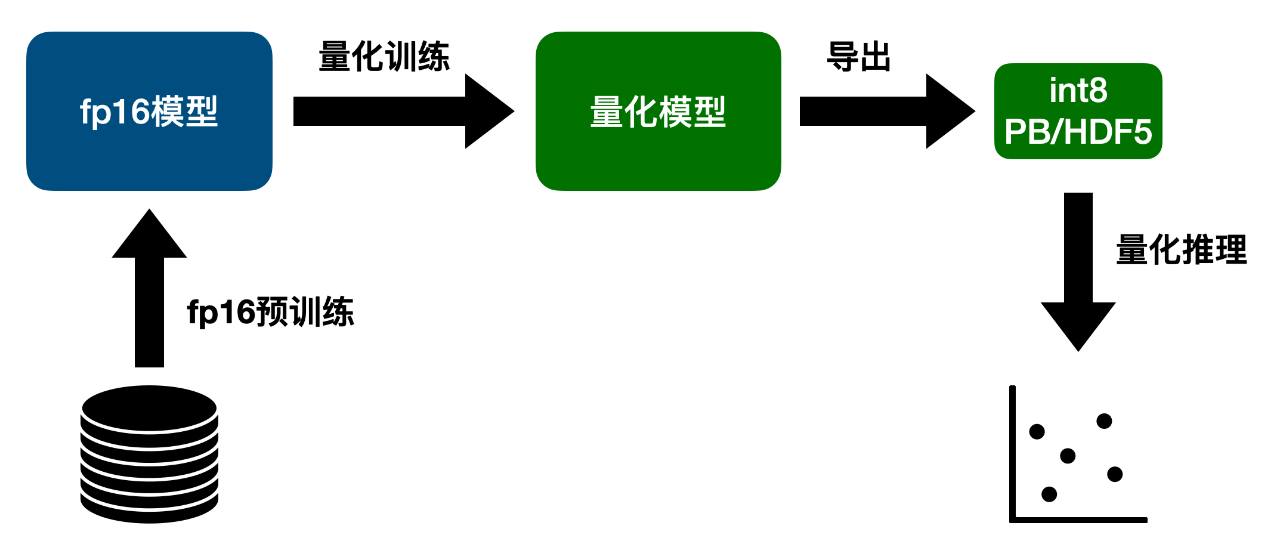

字节跳动推出了全新版本的 LightSeq GPU 量化训练与推理引擎。支持 Transformer 系列模型的量化训练与推理,并做到了开箱即用,用户友好。LightSeq 快准狠地实现了 int8 精度的量化训练和推理:

-

快:A100 多卡训练最高加速 5.2 倍,T4 单卡推理最高加速 8.9 倍。

-

准:训练和推理效果基本无损。

-

狠:相同数据量下,显存占用最高减少 68%,模型存储空间减少 75%。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢