【标题】Understanding and Preventing Capacity Loss in Reinforcement Learning

【作者团队】Clare Lyle, Mark Rowland, Will Dabney

【发表日期】2022.5.4

【论文链接】https://arxiv.org/pdf/2204.09560.pdf

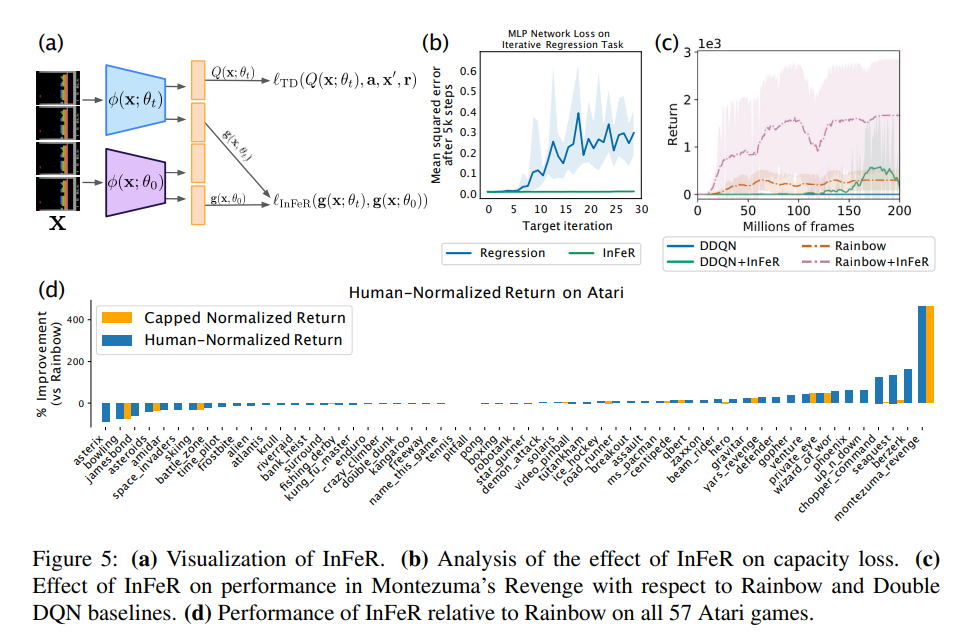

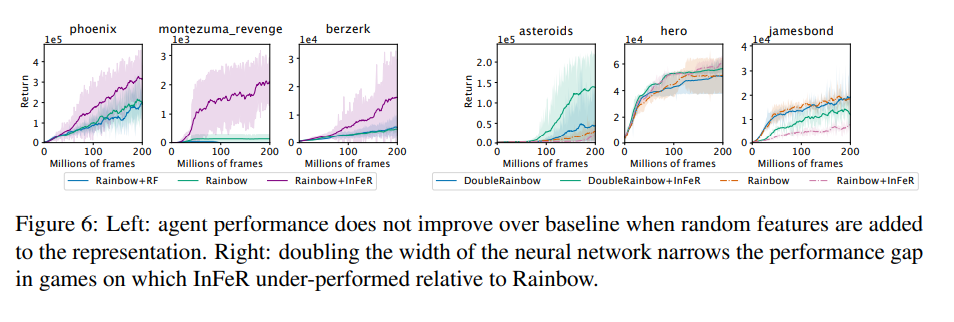

【推荐理由】强化学习 (RL) 问题充满了非平稳性的来源,使其成为神经网络应用的一个出了名的困难问题领域。 本文确定了一种机制,通过这种机制,非平稳预测目标可以阻止深度强化学习智能体的学习进度:容量损失,即在一系列目标值上训练的网络随着时间的推移失去了快速更新其预测的能力。 本文证明容量损失发生在一系列强化学习智能体和环境中,并且对稀疏奖励任务的性能尤其有害。 然后,本文提出了一个简单的正则化器,初始特征正则化 (InFeR),它通过在初始化时将特征子空间回归到其值来缓解这种现象,从而在诸如蒙特祖玛的复仇之类的稀疏奖励环境中显着提高性能。 作者得出的结论是,防止容量损失对于使智能体能够最大程度地从他们在整个训练轨迹中获得的学习信号中受益至关重要。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢