作者:Harsh Raj, Domenic Rosati, Subhabrata Majumdar

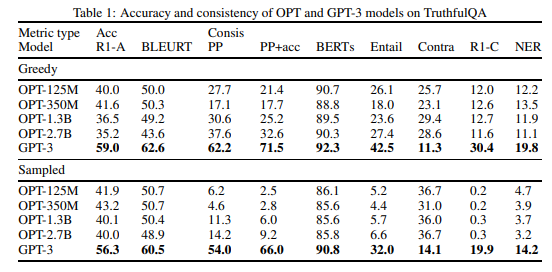

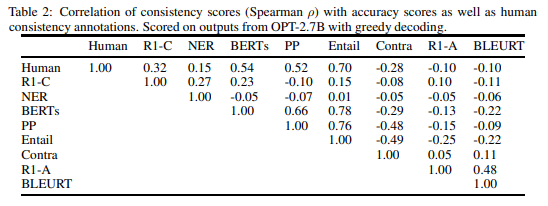

简介:本文提出以语义一致性框架来评估NLG的可靠性。虽然大型预训练语言模型(PLM)在许多自然语言任务上表现出令人难以置信的流畅性和性能,但最近的研究表明:性能良好的PLM对输入到它们的Prompt提示非常敏感。即使Prompt提示在语义上相同,语言模型也可能给出非常不同的答案。在考虑安全可靠的PLM部署时,研究者希望其输出在具有相同含义或传达相同意图的提示下保持一致。虽然一些工作已经研究了最先进的PLM如何满足这一需求,但它们仅限于评估单词或多词答案的词汇平等性,而不涉及生成文本序列的一致性。为了理解在文本生成设置下PLM的一致性,作者开发了一种语义一致性度量、以对开放式文本输出进行比较。作者实现了该一致性度量的多个版本,以评估TruthfulQA数据集中大量PLM对意译版本问题的性能。作者发现作者提出的度量比体现词汇一致性的传统度量更为一致、并且在更高程度上与人类对输出一致性的评估相关。

论文下载:https://arxiv.org/pdf/2211.05853.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢