近来,文本到图像模型成为一个热门的研究方向,无论是自然景观大片,还是新奇的场景图像,都可能使用简单的文本描述自动生成的。

其中,渲染天马行空的的想象场景是一项具有挑战性的任务,需要在新的场景中合成特定主题(物体、动物等)的实例,以便它们自然无缝地融入场景。

一些大型文本到图像模型基于用自然语言编写的文本提示(prompt)实现了高质量和多样化的图像合成。这些模型的主要优点是从大量的图像 - 文本描述对中学到强大的语义先验,例如将「dog」这个词与可以在图像中以不同姿势出现的各种狗的实例关联在一起。

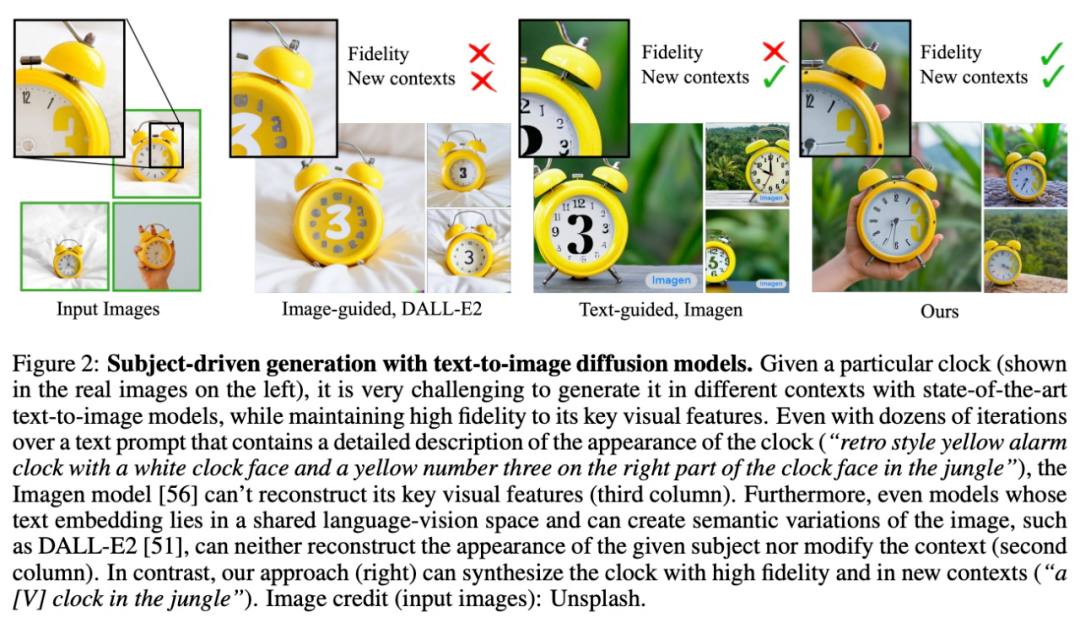

虽然这些模型的合成能力是前所未有的,但它们缺乏模仿给定参考主题的能力,以及在不同场景中合成主题相同、实例不同的新图像的能力。可见,已有模型的输出域的表达能力有限。

为了解决这个问题,来自谷歌和波士顿大学的研究者提出了一种「个性化」的文本到图像扩散模型 DreamBooth,能够适应用户特定的图像生成需求。

论文地址:https://arxiv.org/pdf/2208.12242.pdf(opens new window)

项目地址:https://github.com/XavierXiao/Dreambooth-Stable-Diffusion(opens new window)

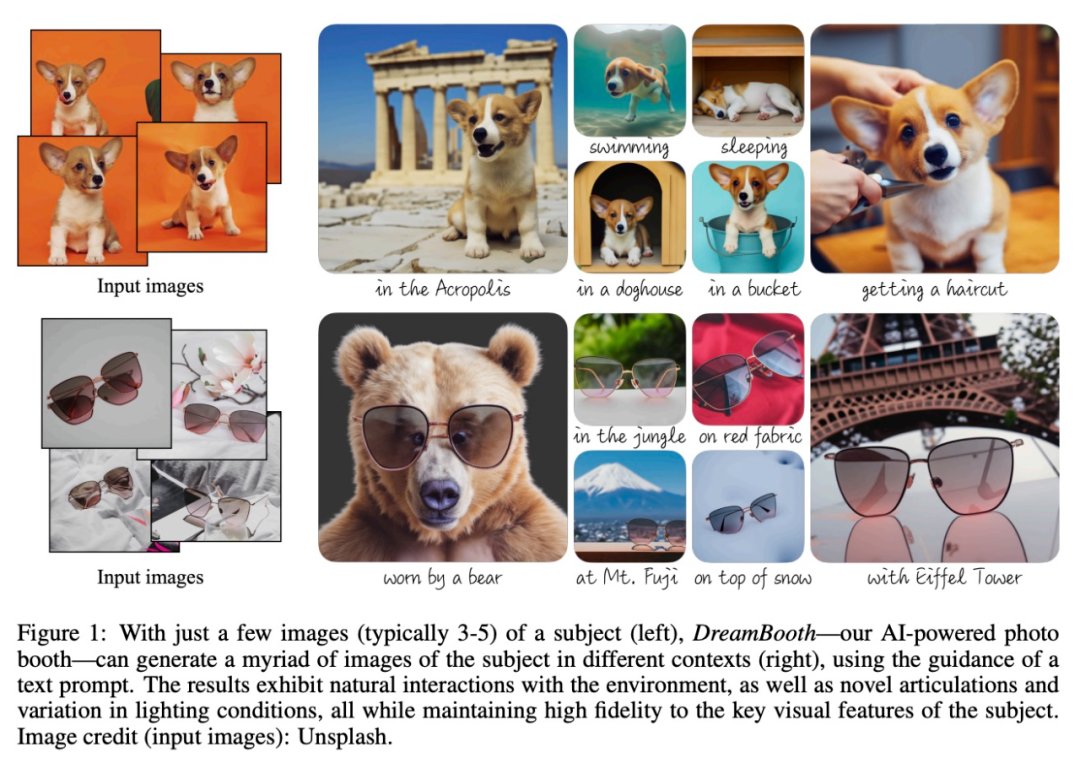

该研究的目标是扩展模型的语言 - 视觉字典,使其将新词汇与用户想要生成的特定主题绑定。一旦新字典嵌入到模型中,它就可以使用这些词来合成特定主题的新颖逼真的图像,同时在不同的场景中进行情境化,保留关键识别特征,效果如下图 1 所示。

具体来说,该研究将给定主题的图像植入模型的输出域,以便可以使用唯一标识符对其进行合成。为此,该研究提出了一种用稀有 token 标识符表示给定主题的方法,并微调了一个预训练的、基于扩散的文本到图像框架,该框架分两步运行;从文本生成低分辨率图像,然后应用超分辨率(SR)扩散模型。

首先该研究使用包含唯一标识符(带有主题类名,例如「A [V] dog」)的输入图像和文本提示微调低分辨率文本到图像模型。为了防止模型将类名与特定实例过拟合和语义漂移,该研究提出了一种自生的、特定于类的先验保存(preservation)损失,它利用嵌入模型中类的先验语义,鼓励模型生成给定主题下同一类中的不同实例。

第二步,该研究使用输入图像的低分辨率和高分辨率版本对超分辨率组件进行微调。这允许模型对场景主题中小而重要细节保持高保真度。

评论

沙发等你来抢