论文链接:

https://arxiv.org/abs/2211.05709

项目主页:

https://lisiyao21.github.io/projects/AnimeRun

代码链接:

https://github.com/lisiyao21/AnimeRun

最近AIGC领域的新工作几乎呈现一种井喷式的发展,借助AI模型天马行空的想象力,研究者们开始在各种图像和视频内容领域发力,本文介绍一篇发表在NeurIPS 2022 Dataset and Benchmark Track上的新工作。该工作并非是像近期提出的扩散模型去生成一些图像和视频,而是瞄准了计算机动漫创作方向,作者指出现有的2D动画片数据集存在画面构成简单且角色动作单调的问题,这使得它们不足以模拟真实的动画。

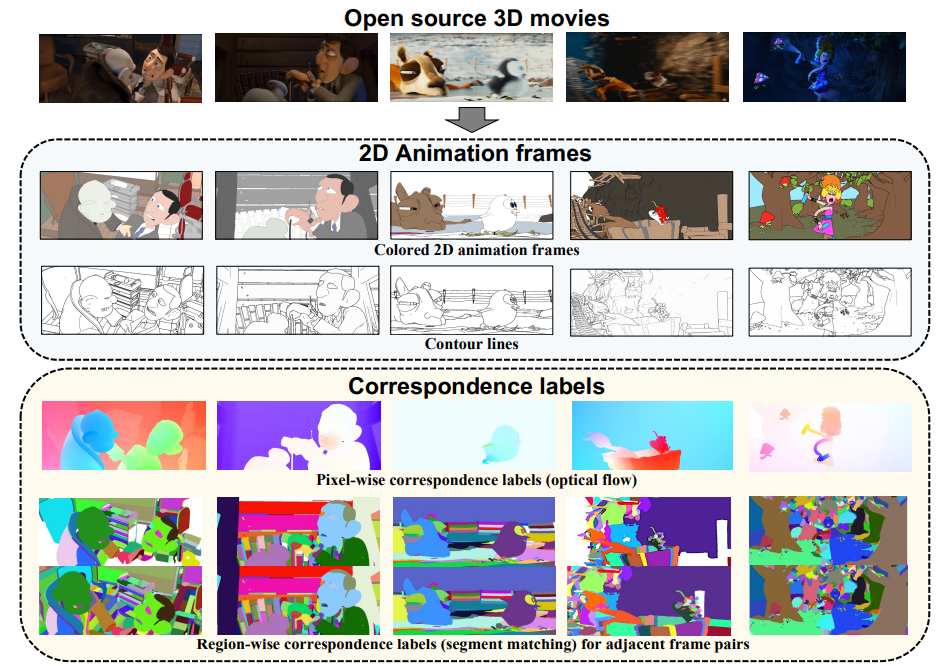

为了解决这一问题,作者团队提出了一种新的大规模2D视觉一致性动画数据集AnimeRun,将开源的3D电影转换为2D风格的完整画面,同时保留有原始画面中移动的背景和多个主体角色之间的交互动作。为了提高数据集质量,作者遵循视觉一致性,为每一帧提供了灰度轮廓和彩色图片,同时提供了像素级别和区域级别的ground-truth,其中像素级别标签为光流图像,区域级别标签为图像分割图,如下图所示:

随后作者进行了一系列的数据集分析,分析结果表明,与现有的数据集相比,AnimeRun不仅在图像构成方面更加接近真实的动画数据,而且包含有更丰富、更复杂的角色运动模式。在该数据集的基础上,作者进一步提出了一个较为完善的Benchmark,并与目前已有的光流和片段匹配方法进行了实验对比,丰富了整体的实验框架。

01. 引言

本文的核心灵感来源于计算机视觉任务中天然存在的视觉一致性(Visual Correspondence),尤其对于二维动画来说,找到相邻帧的精确视觉对应关系对模型训练具有很大的帮助。例如我们可以通过区域轮廓的一致关系将参考帧中的颜色分布传播到目标帧中实现视频自动上色。也可以使用像素一致关系对图像进行细粒度编辑进而得到帧插值模型。这些视觉一致性范式在自然场景中的数据具有非常好的效果,但其仍无法很好的适用于2D动画数据上。本文作者认为,这是因为自然图像序列中包含具有不同阴影和模糊的复杂纹理,而动画数据通常由具有明确轮廓线的平面彩色块构成,二者有本质上的域差距。因此本文针对2D动画提出了一个大规模数据集来缓解这一问题。

目前制作收集动画数据集的常用方法是使用计算机图形软件(例如Blender)将3D模型渲染成2D风格,这种方法可以快速合成大量的数据,而不需要为每个场景进行专门的调整。但是由于渲染模型固定,其不可避免地导致构图单调,因此在模拟真实的动画方面存在不足。鉴于这些缺陷,作者在制作AnimeRun数据集时使用了上图所示的流程,作者选用的原数据是具有工业级3D电影的完整场景,首先对其生成彩色图像和轮廓图,随后对视频序列进行密集光流估计和图像分割来得到像素级别和区域级别的标注图。由于选用的原数据包含丰富的背景信息,例如室内、雪山、矿山和森林,还含有复杂的交互动作,直接将其转换为2D风格会带来很多误差。为了解决这一问题,作者在保留电影中的主要角色和动作的前提下,系统地对每个电影剪辑进行一系列调整,以提高与2D动画风格的兼容性,并确保对应标签的准确性。

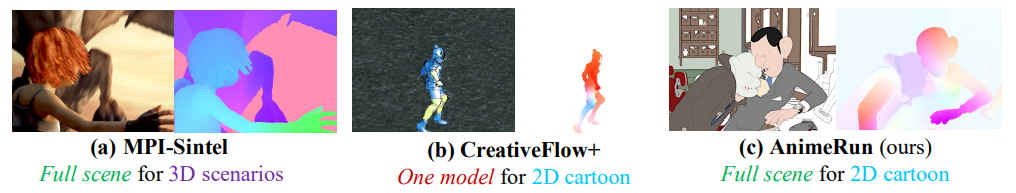

与现有数据集相比,AnimeRun具有同步背景变化的全场景动画,同时提供多个对象/角色交互和遮挡示例,而且包含有更复杂的角色运动。上图展示了AnimeRun与其他数据集的对比。作者总结本文具有以下三个方面的贡献:

-

作者通过将开源的3D动漫电影转换为2D风格,制作了该领域第一个全场景视觉一致性动画数据集。

-

本文分别在像素级和区域级层面上提供了细粒度的对应标签。

-

作者在所提AnimeRun数据集的基础上构建了该领域第一个2D动画视觉一致性实验基准。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢