近日,智源研究院发布了中英双语图像生成模型 AltDiffusion,满足专业级中文AI文图创作需求。

时隔不到一周,团队推出重要升级版 AltDiffusion-m9,全面支持中、英、西、法、日、韩、阿、俄、意等九种不同语言的文图生成任务。

目前,代码及模型皆全部开源到 FlagAI 大模型开源项目中,供全球开发者试用。

https://arxiv.org/abs/2211.06679v1

AltDiffusion 代码链接:

https://github.com/FlagAI-Open/FlagAI/tree/master/examples/AltDiffusion

Hugging face 模型链接:

https://huggingface.co/BAAI/AltDiffusion-m9

甫一开源,模型即收到热烈关注, Hugging Face 的 CEO Clement Delangue,AK ( Ahsen Khaliq ) ,Stability.ai 公司 CEO Emad Mostaque 等纷纷点赞转发。

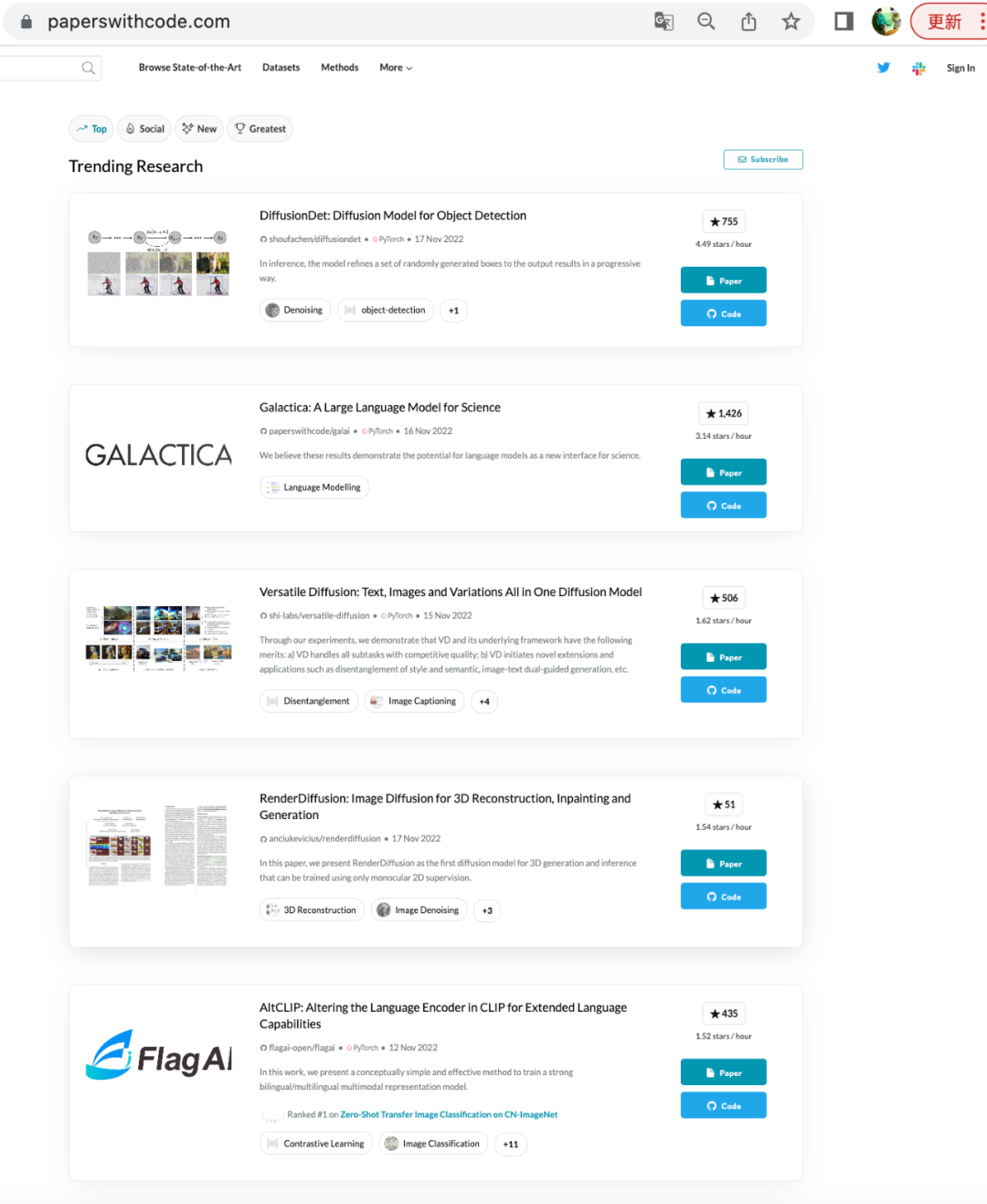

目前模型不仅被 HuggingFace 火速收入 diffusers 模型库,跻身 GitHub Python 开源项目每日热榜、 paperwithcode 网站热度前5,还持续收到来自各国开发者增加更多语言的需求。

在这一多语 AltDiffusion 模型研究中,我们观察到一些非常有趣的现象:

给定不同语言的提示语(prompt),模型即可展现语言背后所反映的不同文化图像面貌,如直接生成不同人种的人物形象,或是不同的地域风物特征。

在下图中,同一个提示词翻译成不同语言生成的年轻人,从头发的颜色、卷曲程度、面部特征到着装特点,都在一定程度上体现出了差异。

AltCLIP 则是 AltDiffusion 模型背后的重要训练技术。利用 OpenAI 发布的预训练的多模态表征模型 CLIP,我们将其文本编码器更换为预训练的多语言文本编码器 XLM-R,并通过包含教师学习和对比学习的两阶段训练模式对语言和图像表征进行对齐。这种方法在第一阶段先将其他语言的表征与 CLIP 中的英文表征做对齐,在这个训练阶段不需要多语言的图文对数据,而只需要多语言的平行语料。在第二阶段只需要少量的多语言图文对,就能学到效果很好的多语言图文表征,很大程度上减少了多语言多模态表征模型对于训练数据的依赖。

智源研究院在多模态AIGC的研究道路上持续前行,期待为 AIGC 带来更多重要突破性研究,助力全球不同国家的研究者、开发者在 AIGC 方面的尝试和应用!

更多内容请访问 https://mp.weixin.qq.com/s/j6FHa03x6MIPIPmAsTS2Qw

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢