作者:Sheng Shen, Shijia Yang, Tianjun Zhang,等

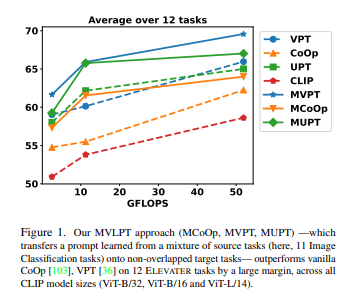

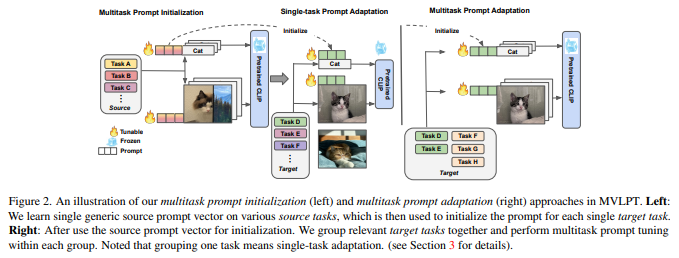

简介:本文研究在视觉语言领域多任务学习中的Prompt技术。提示调优(Prompt Tuning)是一种基于任务特定的学习提示向量的调节,已成为一种数据高效和参数高效的方法,用于将大型预训练视觉语言模型适应多个下游任务。然而,现有的方法通常考虑从头开始独立地学习每个任务的提示向量,从而无法在不同的视觉语言任务中利用丰富的可共享知识。在本文中,作者提出了多任务视觉语言提示调优(MVLPT),它将跨任务知识纳入视觉语言模型的提示调优中。具体而言,(i)作者证明了从多个源任务学习单个可转移提示以初始化每个目标任务的提示的有效性;(ii)作者表明许多目标任务可以从共享提示向量中相互受益,因此可以通过多任务提示调优来共同学习。作者使用三种代表性的提示调优方法对所提出的MVLPT进行基准测试、即:文本提示调优、视觉提示调优、统一视觉语言提示调优。在20个视觉任务中的结果表明:本文所提出的方法优于所有单任务基线提示调优方法,在小样本ELEVATER基准和跨任务泛化基准上斩获了新的SOTA水平。为了了解跨任务知识在哪里最有效,作者还对任务可转移性进行了大规模研究:针对每种提示调优方法,在400种组合中、使用了20个视觉任务。研究表明:对于每种提示调优方法,性能最高的MVLPT偏好不同的任务组合,并且许多任务可以彼此受益,这取决于它们的视觉相似性和标签相似性。

论文下载:https://arxiv.org/pdf/2211.11720.pdf

源码下载:https://github.com/sIncerass/MVLPT

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢