如何更好、更快和更便宜地实现训练、微调 AIGC 模型,已成为 AIGC 商业化和应用爆发的最大痛点。

Colossal-AI 基于在大模型民主化的专业技术积累,开源完整 Stable Diffusion 预训练和个性化微调方案,预训练时间加速和经济成本降低 6.5 倍,个性化微调硬件成本降低 7 倍!在个人电脑的 RTX 2070/3050 上即可快速完成微调任务流程,让 Stable Diffusion 等 AIGC 模型的触手可及。

开源地址:

https://github.com/hpcaitech/ColossalAI(opens new window)

01

火爆的 AIGC 赛道与高昂成本

AIGC(AI-Generated Content 人工智能生成内容)是当前 AI 领域最热门的话题之一,尤其是伴随着 Stable Diffusion、Midjourney、NovelAI、DALL-E 等为代表的文本生成图像的跨模态应用涌现,AIGC 更是火爆出圈,广受关注。

Stable Diffusion 生成图像

由于 AIGC 激发了大量行业需求,它已被视为下一波 AI 浪潮的重要方向之一,业界广泛期望出现基于 AIGC 在文本、音频、图像视频、游戏、元宇宙等技术场景的新技术革命和杀手级应用。AIGC 在相关场景的成功商业化落地,潜在的数万亿美元市场,更是让相关初创公司成为资本宠儿,如 Stability AI、Jasper 等成立仅一两年便已获得上亿美元融资,晋升独角兽行列。

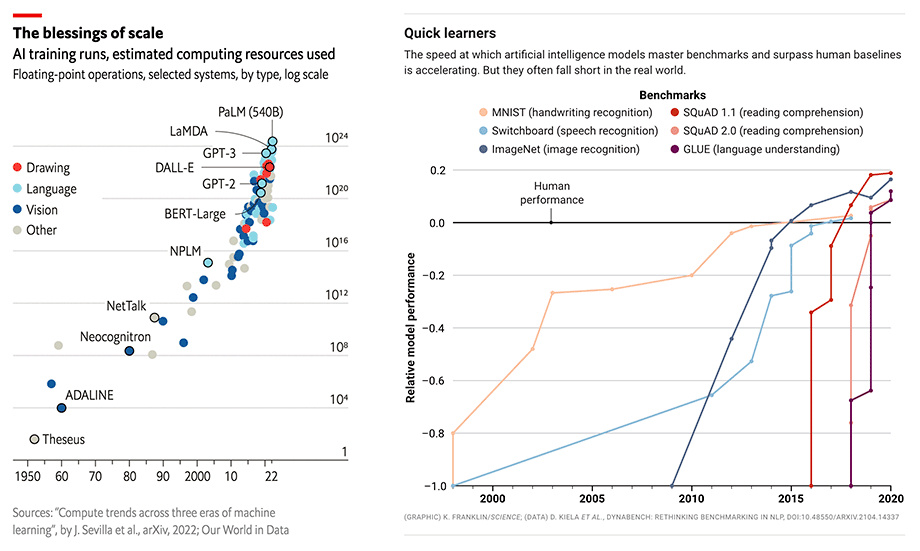

AI 模型规模与性能的同步增长

但高昂的硬件需求和训练成本仍严重阻碍着 AIGC 行业的快速发展。AIGC 应用的出色表现通常建立在 GPT-3 或 Stable Diffusion 等大模型之上,并针对特定下游任务和应用进行微调。以大火的 Stable Diffusion 为例,尽管其背后的 Stability AI 成立不久,却维护了超过 4000 个英伟达 A100 的 GPU 集群,并已为此支出超过 5000 万美元的运营成本,仅 Stable Diffusion v1 版本的模型单次训练便需要 150000 个 A100 GPU Hour。

02

Diffusion model

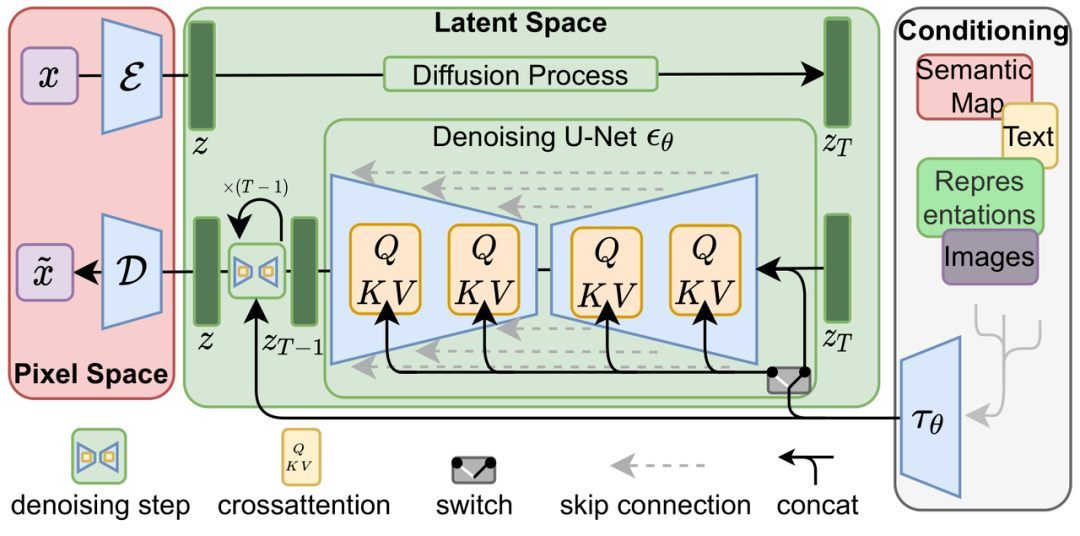

Diffusion model(扩散模型)的想法最早在 2015 年的论文 Deep Unsupervised Learning using Nonequilibrium Thermodynamics 被提出,2020 的论文 Denoising Diffusion Probabilistic Models (DDPM)将其推到了一个新的高度,之后基于扩散模型的 DALL-E 2, Imagen, Stable Diffusion 在生成任务上取得了远超生成对抗网络(GAN)、变微分自动编码器(VAE)、自回归模型(AR)等传统生成模型的效果。

扩散模型包含两个过程:前向扩散过程和反向生成过程,前向扩散过程是对一张图像逐渐添加高斯噪声直至变成随机噪音,而反向生成过程是去噪音过程,将一个随机噪音使用多个 U-Net 进行逐渐去噪音直至生成一张图像,这也是扩散模型训练的部分。

Latent Diffusion model

对比传统端到端的深度学习模型,扩散模型的训练过程无疑更为复杂,以 Stable Diffusion 为例,除了扩散模型本身,还有一个 Frozen CLIP Textcoder 来输入 text prompts,以及一个 Autoencoder 实现将高分辨率图像压缩到潜在空间(Latent Space),并在每个 time step 计算 loss。这对训练方案的显存开销,计算速度都提出了更大的挑战。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢