最近,LSTM之父Jürgen Schmidhuber一言不合又跟LeCun干上了!

其实之前稍微熟悉这位暴脾气大爷的同学都知道,特立独行的Jürgen Schmidhuber和机器学习社区的几位大佬级人物之间都有过不愉快。

尤其是当「那三个人」一起拿了个图灵奖,而Schmidhuber却没有之后,这位老爷子就更气了……说到底Schmidhuber一直认为,现在这几个ML领军人物,什么Bengio、Hinton、LeCun,包括「GAN」之父Goodfellow等人,他们的很多所谓「开创性成果」都是自己先提出来的,而这些人在论文中根本就没提过他。

为此,Schmidhuber曾经专门撰文把Bengio、Hinton、LeCun于2015年发在Nature上的综述性文章「Deep Learning」一文拿出来批判过一番。

主要是说这篇文章里的成果,哪些东西是他先提的,哪些东西是别的前辈先提的,反正不是这仨作者先提的。

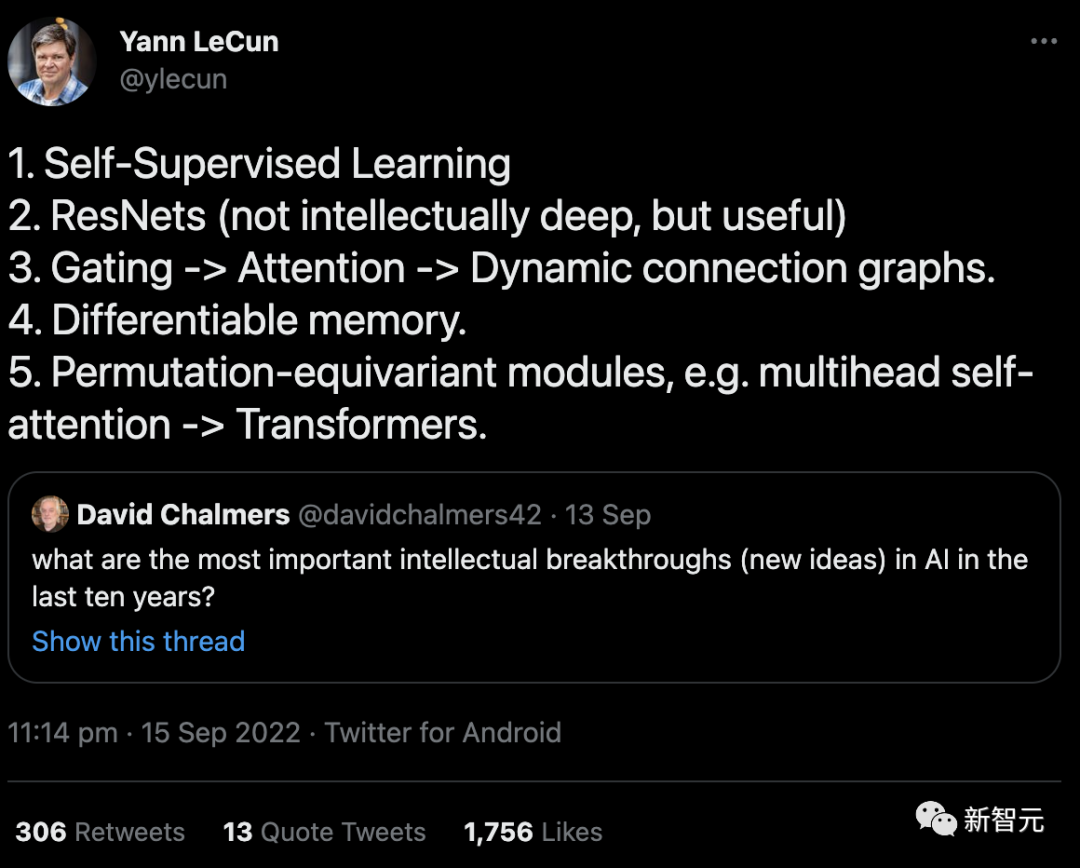

回到这次事件起因,实际上是LeCun在9月份发的一条推文。

内容是对David Chalmers教授提问的回答:「在过去十年中,AI最重要的智力突破(新想法)是什么?」

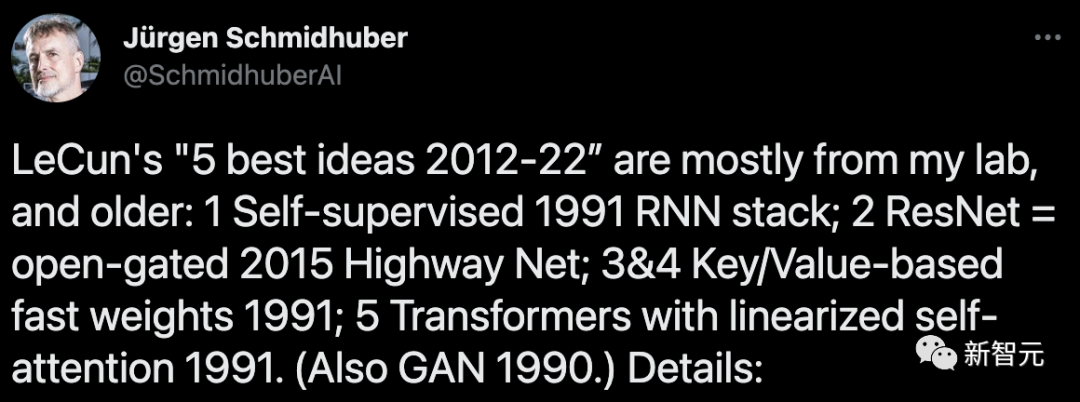

10月4日,Schmidhuber在他的博客上撰文怒斥:这5个「best idea」大部分都来自于我的实验室,而且提出的时间要远远早于「10年」这个时间节点。

文中Schmidhuber详细列举了六大证据来支撑自己的论述。

但估计是因为看到的人太少,Schmidhuber又在11月22日发推,重新把这个「冷饭」炒了一遍。

然而,相比于上一次还算激烈的争辩,这回LeCun连理都没理……

1. 通过神经网络(NN)自动生成标注的「自监督学习」:至少可以追溯到我1990-91年的工作。

(I) 通过预测编码在一个循环神经网络(RNN)中进行自监督的目标生成,来学习在多个时间尺度和抽象层次上压缩数据序列。

在这里,一个「自动机」RNN学会了「预测下一个输入」的前置任务,并将传入数据流中的意外观察作为目标发送给「分块机」RNN,后者学习更高层次的规律性,随后通过适当的训练目标将其获得的预测知识提炼回自动机中。

这大大促进了以前无法解决的序列分类的下游深度学习任务。

(II) 通过GAN类型的内在动机进行自监督的标注生成,其中一个世界模型NN学习预测对抗性的、标注生成的、实验发明的控制器NN的行为后果。

此外,我于1990年发表的论文标题中,就已经出现了「自监督」的说法。

但是吧,在更早期(1978年)的论文中,也用到了这个词……

2. 「ResNets」:实际上就是我早期提出的Highway Nets。但LeCun却认为ResNets的智力「不深」,这让我非常伤心。

在我提出Highway Nets之前,前馈网络最多只有几十层(20-30层),而Highway Nets是第一个真正的深度前馈神经网络,有数百层。

在1990年代,我的LSTM给有监督的递归NN带来了基本无限的深度。在2000年代,LSTM启发的Highway Nets给前馈NN带来了深度。

由此带来的是,LSTM已经成为20世纪被引用最多的NN,而Highway Nets(ResNet)是21世纪被引用最多的NN。

可以说,它们代表了深度学习的精髓,而深度学习就是关于NN的深度。

3. 「门控->注意力->动态连通图」:至少可以追溯到我的Fast Weight Programmers和1991-93年的Key-Value Memory Networks(其中的「Key-Value」被称为「FROM-TO」)。

1993年,我引入了现在使用的术语「注意力」。

不过值得注意的是,NN中的第一个乘法门可以追溯到1965年Ivakhnenko & Lapa的深度学习机。

4. 「Differentiable memory」:同样可以追溯到我的Fast Weight Programmers或1991年的Key-Value Memory Networks。

像传统计算机中那样分离存储和控制,但以端到端差分、自适应、完全神经的方式(而不是以混合方式)。

5. 「置换等变模块,例如多头自注意力->Transformer」:我在1991年发表了带有线性化自注意的Transformer。相应的「注意力」术语(internal spotlights of attention)可以追溯到1993年。

6. 「GAN是过去10年中最好的机器学习理念」

你提到的这个GAN(2014年)的原理,实际上是我在1990年以人工智能好奇心的名义提出的。

上一次,还是在几个月之前

其实这已经不是Schmidhuber和LeCun之间今年第一次发生争执了。

在六七月间,两人就关于LeCun发表的一篇「自主机器智能未来方向」的展望报告有来有回地吵了一番。

6月27日,Yann LeCun发表了自己积蓄几年的论文「A Path Towards Autonomous Machine Intelligence」,并称其为「指明AI未来发展方向之作」。

这篇论文系统讲述了关于「机器如何能像动物和人类一样学习」的问题,长达60多页。

LeCun表示,此文不仅是自己关于未来5-10年内关于AI发展大方向的思考,也是自己未来几年打算研究的内容,并希望能够启发AI界的更多人来一起研究。

本文转自新智元公众号

更多内容请访问 https://mp.weixin.qq.com/s/I2q-1gb5juDiV4fQGHREgg

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢