作者:Ting Han, Kunhao Pan, Xinyu Chen等

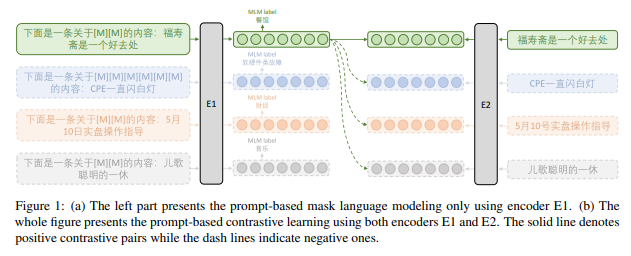

简介:本文研究中文主题分类任务中的BERT模型。Transformers 或BERT的双向编码器表示, 由于其卓越的性能,已成为各种 NLP 任务的基础模型之一。研究业界已提出了针对不同语言和任务定制的变体,以进一步提高性能。在这项工作中,作者调查了针对中文主题分类任务的BERT监督持续预训练。具体来说,作者将基于Prompt提示的学习和对比学习结合到预训练中。为了适应中文主题分类任务,作者收集了大约 210 万个涵盖各种主题的中文数据。预训练中文主题分类BERT具有不同参数大小的 (TCBERT) 已在 huggingface上开源。

论文下载:

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢