论文链接:

https://ieeexplore.ieee.org/document/9887897

代码链接:

https://github.com/AutoML-Research/TREFE

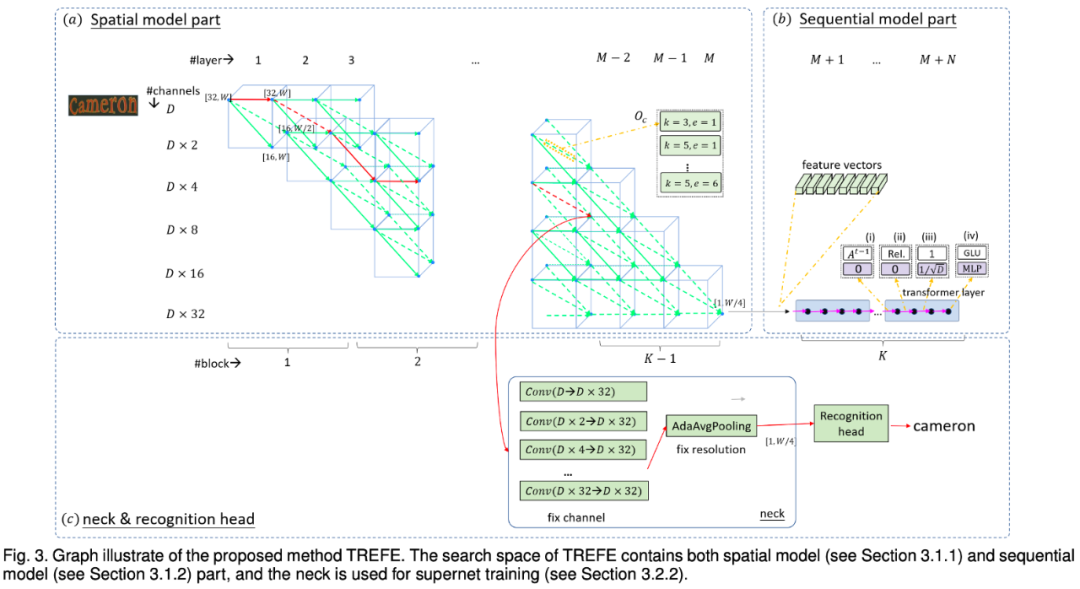

近期研究表明,神经架构搜索(NAS)可以在图像分类、语义分割、目标检测等计算机视觉任务中产出良好的神经架构,受此启发,摒弃此前需要专家手动设计架构的方法,本文提议使用 one-hot NAS 来搜寻高性能的 TR 特征提取器。

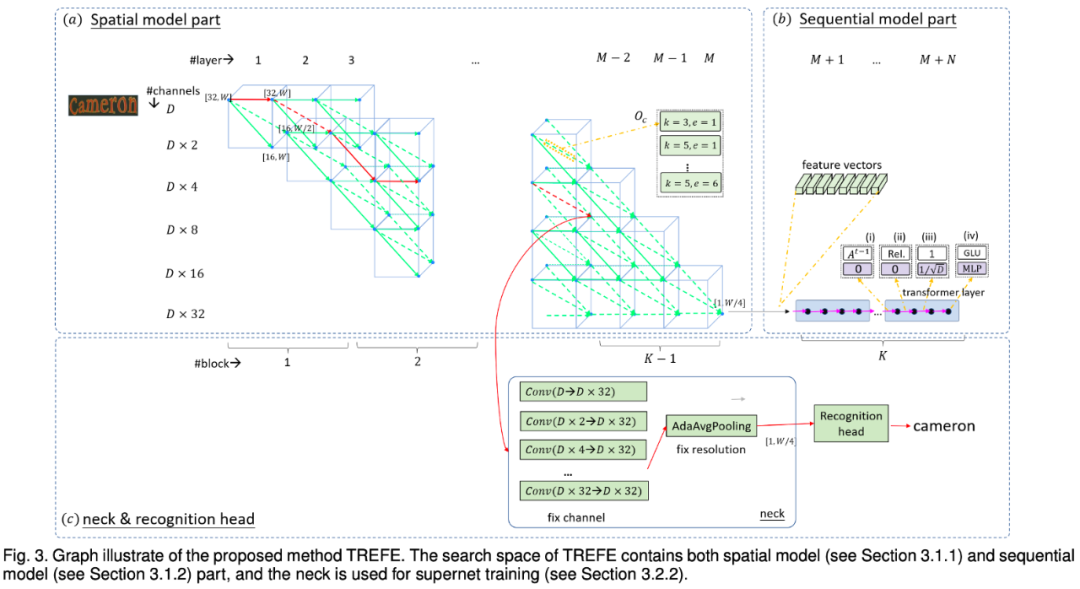

具体来说,我们首先为视觉和序列特征提取器设计一个特定于 TR 任务的搜索空间。对于视觉部分,该搜索空间支持对卷积类型和下采样路径进行选择;对于序列部分,本文提议使用 Transformer 替代,其比 TR 任务中常用的 BiLSTM 具有更强的并发性,但是 Vanilla Transformer 很难优于 BiLSTM。因此,本文进一步探索了 Transformer 近期的发展,并搜寻 Transformer 的变体。

由于合成的超网之巨大,本文提议使用两阶段 one-hot NAS 方法。在第一个阶段,受神经网络渐进逐层训练的启发,本文采用了一种贪婪的逐块训练的方式。在第二个阶段,摒弃进化算法或随机搜索,本文使用自然梯度下降以更高效地从超网中搜寻更精悍的架构,部署环境的资源限制也可以很好地在本阶段引入,导致最终选择出的架构更有可部署性。在一系列的标准数据集上的大量实验表明,合成的 TR 模型在准确性和推理速度上都优于现存 SOTA 模型。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢