作者:Kazuki Osawa, Shigang Li, Torsten Hoefler

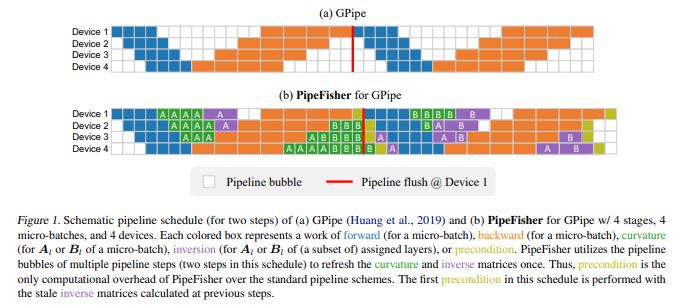

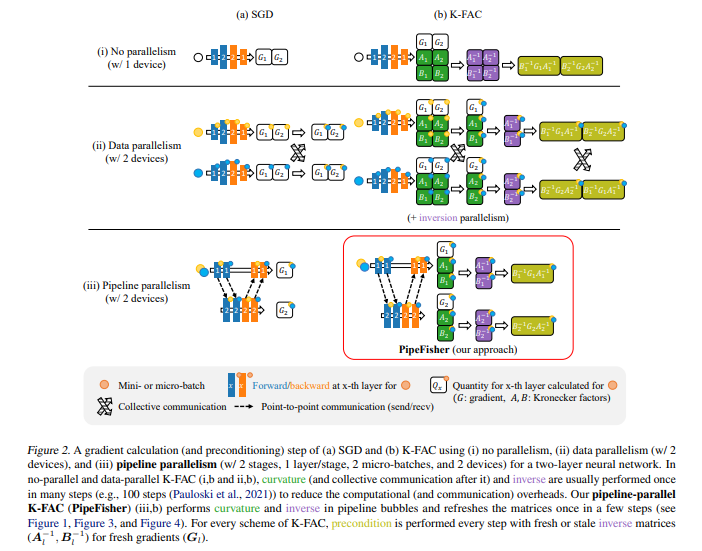

简介:本文研究Pipeline并行训练中的气泡(即空闲时间)问题、以显著提升GPU利用率。Pipeline并行机制实现了大规模分布式加速器集群上大型语言模型(LLM)的高效训练。然而,启动和终止Pipeline过程中的气泡降低了加速器的利用率。为利用率的最大化,尽管已经提出了具有微批处理和双向管道的高效Pipeline方案,但使用无论是正向同步还是反向通过:都无法填充这些大量气泡。为解决该问题,作者建议为气泡分配额外的工作,以在LLM训练中获得辅助效益。作者提出了PipeFisher:它将K-FAC(一种基于Fisher信息矩阵的二阶优化方法)的工作分配给气泡以加速收敛。在BERT-Base和BERT-Large模型的首个阶段预训练中,PipeFisher通过大幅提高加速器利用率并受益于K-FAC改进的收敛性,将训练时间减少到50-75%!

论文下载:https://arxiv.org/pdf/2211.14133.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢