论文链接:https://arxiv.org/abs/2205.14415

代码:https://github.com/thuml/Nonstationary_Transformers

时序预测普遍包含于日常生活与工业生产的诸多应用中,覆盖气象,能源,金融,医疗等多个领域。近年来,以注意力机制(Attention Mechanism)为结构核心的Transformer在深度时序预测领域取得了突破性进展,其点到点的注意力机制天然适合建模时间序列中的时序依赖(Temporal Dependency),可堆叠的编解码器也利于捕捉和聚合不同时间尺度下的时序特征。

尽管如此,预测非平稳的时序数据对深度模型依然是一项严峻挑战。非平稳的时序数据在现实世界中更加普遍,具有更复杂且难以捕捉的时序依赖,以及随着时间不断变化的数据分布,这对深度模型的建模能力以及泛化性都提出了更高的要求。

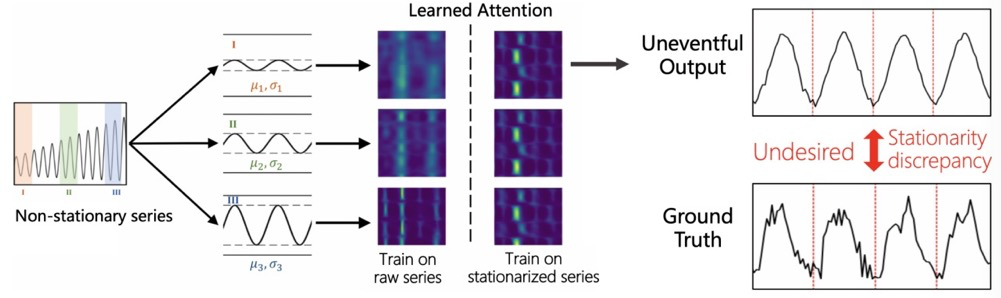

针对非平稳时序预测问题,以往的研究旨在利用平稳化技术消除数据在时间维度上的分布差异,以提高数据本身的可预测性。然而基于我们大量的实验观察(图1),在平稳化后的数据上进行模型训练会限制Transformer建模时序依赖的能力,导致模型仅能学到不易区分的注意力图与较弱的时序依赖,从而产生平稳性过高的预测输出与较大的预测误差,我们称之为过平稳现象(Over-stationarization)。

针对非平稳时序预测问题,我们提出了Non-stationary Transformers,其包含一对相辅相成的序列平稳化(Series Stationarization)和去平稳化注意力(De-stationary Attention)模块,能够广泛应用于Transformer以及变体,一致提升其在非平稳时序数据上的预测效果。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢