作者:Odysseas S. Chlapanis , Georgios Paraskevopoulos , Alexandros Potamianos

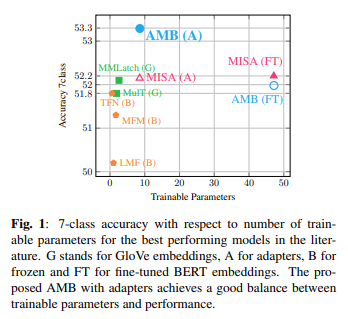

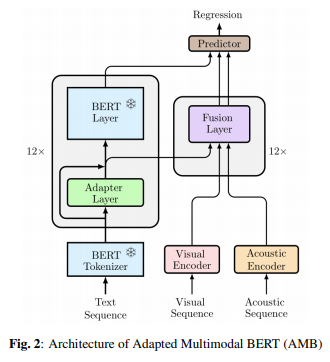

简介:本文研究基于bert的多模态模型、避免了灾难性遗忘和模态失衡的陷阱。多模式学习的pipelines技术,受益于预训练语言模型的成功。然而,这是以增加模型参数为代价的。在这项工作中,作者提出了基于BERT的自适应多模态模型:AMB,它使用适配器模块和中间融合层的组合。适配器为当前的任务调整预训练的语言模型,而融合层执行特定于任务的、逐层融合视听信息与文本 BERT 表示。在适应过程中,预训练的语言模型参数保持冻结状态,从而可以进行快速、参数高效的训练。由于有效地利用了预训练和非主导模态的有用知识,实验表明:AMB模型不仅性能高效、优于经过微调的模型,并且对输入噪声具有鲁棒性。

论文下载:https://arxiv.org/pdf/2212.00678.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢