作者:Rui Pan, Shizhe Diao, Jianlin Chen等

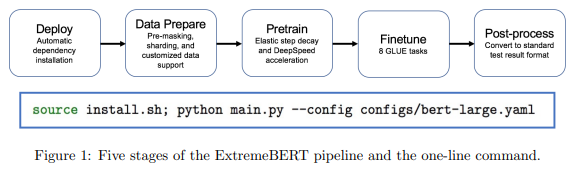

简介:本文介绍了用于加速和定制 BERT 预训练的工具包ExtremeBERT。作者的目标是为研究社区和行业提供易于使用的 BERT 预训练工具包。为在资源有限的情况下,可以负担得起在定制数据集上对流行语言模型进行预训练。实验表明:基于GLUE分数比较的维度、对照原始的BERT论文,作者工具包的时间成本:(1)比BERT Base减少6倍、(2) 比BERT Large 减少了 9倍。

论文下载:https://arxiv.org/pdf/2211.17201.pdf

代码下载:https://github.com/extreme-bert/extreme-bert

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢