作者:Minseop Park , Jaeseong You , Markus Nagel ,等

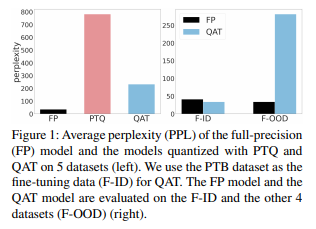

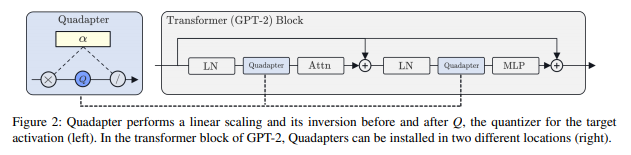

简介:本文研究语言模型的量化感知训练领域的新方法。Transformer 语言模型(如 GPT-2)很难量化,因为激活过程中存在大量与信道相关的异常值,这些异常会导致较大的量化误差。为了适应错误,必须使用量化感知训练(QAT,一种根据量化产生的数值误差微调模型参数的方法),训练后量化(PTQ)是QAT的一种对应物,它在不修改模型参数的情况下执行量化,但其功能不足以应对异常值。QAT需要基于数据集和与原始模型相同的训练管道的微调过程。然而,预训练语言模型通常不授予对其数据集和训练管道的访问权限,迫使研究人员依赖模型进行微调。 而在这种情况下,QAT将使模型过度拟合微调数据。为了在不过度拟合的情况下进行量化,作者引入了一个量化适配器:Quadapter,以一组轻量级的参数,通过按通道缩放、可以学习使激活量化友好;同时可以保持模型的参数不发生任何变化。实验证明:作为有效的PTQ技术、Quadapter缓解了“QAT的过拟合问题和激活中的信道间方差”这两个业界难题!

论文下载:https://arxiv.org/pdf/2211.16912.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢