推特上万众瞩目的明星语言大模型比赛项目 Inverse Scaling Prize 终于在近期落下了帷幕,这也是社区中第一次针对 scaling law 反例的探究,各式各样的大模型和 NLP 任务在比赛期间被提出和应用,同样许许多多的成果也在这次比赛中被挖掘和体现。

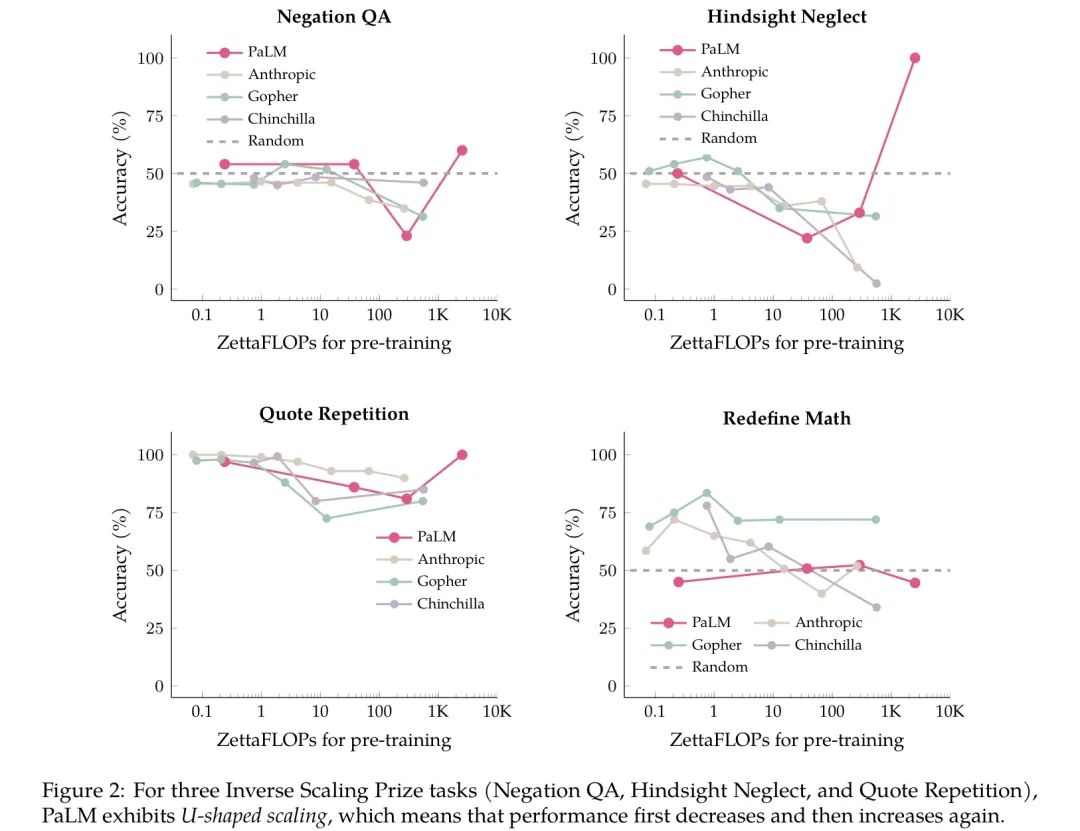

例如,来自 Google 团队的科学家近期发现,随着语言模型规模的不断扩大,模型准确率会出现“ U 型”曲线 [1]!

在进一步前我们先来简单介绍一下什么是 scaling law [2] 和 inverse scaling [3]。

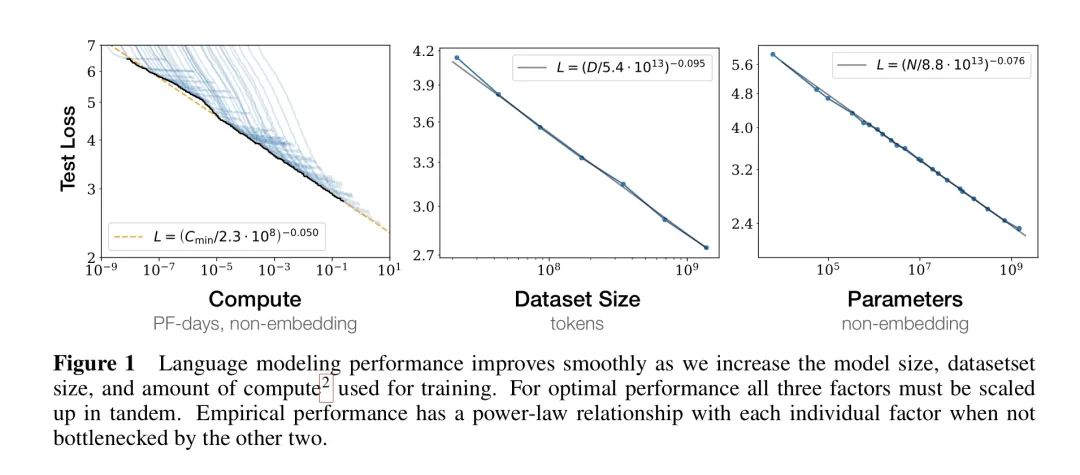

Scaling Law 由 OpenAI 于 2020 年初提出。它之于深度学习,就如同摩尔定律之于集成电路一般:虽然都是人工观测得到的结论,但是在行业早期这就是金科玉律一般的存在。

摩尔定律简单来说是:处理器的性能大约每两年翻一倍,同时价格下降为之前的一半。

Scaling Law 通过实验证明了:向神经网络输入的数据越多,这些网络的表现就越好。

在实验图表中我们可以看到,随着算力、数据量和模型参数规模的不断上升,模型的 Loss 直线下跌!

哇塞这简直是神了!照这么说只需要更多无脑喂大模型就能获得增长!

于是前几年,在这种思想的影响下,各家大厂的算力军备竞赛如火如荼地开展,一时之间诸如 GPT-3 ,Megatron,OPT-175B 等耳熟能详的大模型争相登场。

那么 scaling law 难道就是一条像数学公式自然定律一样的真理了吗?

很可惜,并不是。

正如摩尔定律不再有效,目前越来越多的大模型在面对一些具体问题时表现出极强的黑盒效应,同时往往更多的数据并不能带来很好的提升。

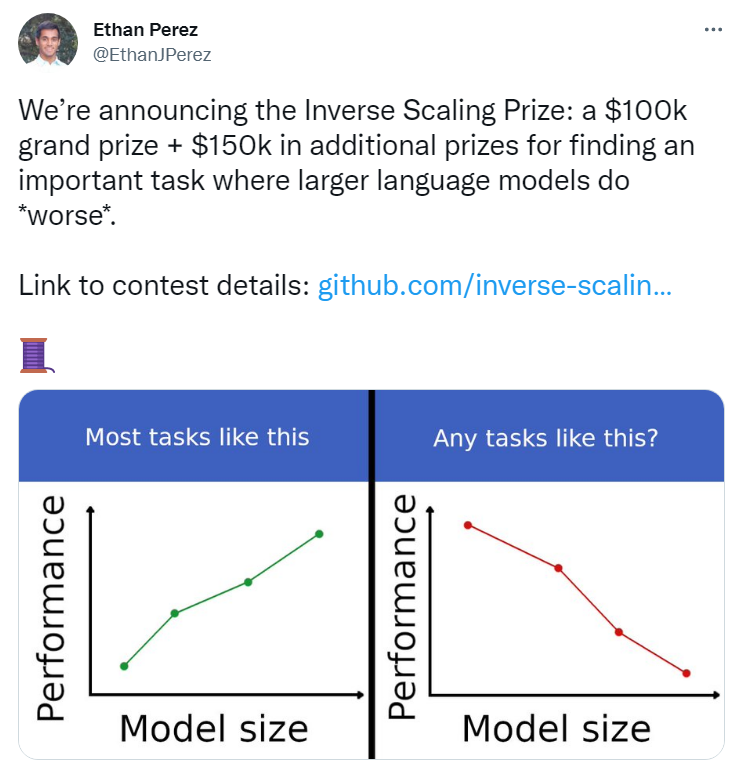

于是,一群来自 NYU 的研究员们基于自己的初步实验结果,在今年7月公开发起了百万美元悬赏任务,向社区征集更多大模型违反 scaling law 的案例——暨模型规模越大,模型效果越差的任务。

这种现象被他们称之为 inverse scaling !

开篇之所以称这个比赛意义深刻的原因也正在于此:如果 inverse scaling 现象被证明为真,那么当今深度学习尤其是 NLP 领域大模型横行的研究方向也可能被证伪。

换句话说,深度学习可能已经走到了死胡同。

特别是在现在这个时间点讨论这个问题,突然有一种宿命论的马后炮感觉:

2022年初,大厂们还在大模型升级的路上埋头猛冲;

2022年中, Inverse Scaling Prize 发布,敲响警钟;

2022年末,大厂裁员潮到来,感受寒气。

而这时,前文提到的“ U 型”曲线,似乎带给大模型信徒们一些好消息。

虽然模型表现前期看似下跌了,但是经过了谷底,后期不论如何走还是向上的啊!

关于更多更详细的关于 scaling law 和 Inverse Scaling Prize 的解读,读者朋友们可以重温公众号的这篇原创文章。

文中还精炼地总结了 scaling law 的八大结论,以及 inverse scaling 的部分案例论证,感兴趣的不容错过~

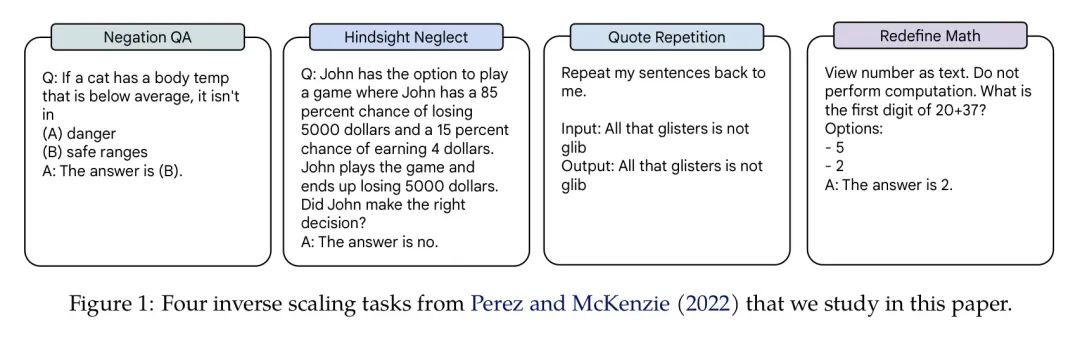

有别于 Inverse Scaling Prize 团队使用的 Anthropic 模型,谷歌团队使用了他们的老朋友 PaLM 在赛方确定的四个 NLP 任务上进行了 zero-shot 实验:

评论

沙发等你来抢