沉迷于ChatGPT的同学在惊叹于AI奇妙的同时,恐怕也会经常遇到AI在“一本正经的胡说八道”。怎么办?Google刚刚发表了一篇名为 RARR: Researching and Revising What Language Models Say, Using Language Models 的论文(PDF),通过为大模型生成的文字寻找出处,试图缓解这一问题。

研究团队很多都是华人,包括Kelvin Guu,阮大成Da-Cheng Juan等。一作是在Google实习的CMU在读博士Luyu Gao,二作为本科毕业于北大的 戴竹韵 ,四作是UC Irvine在读博士 Anthony Chen 。

此前,Kelvin Guu 2020年的相关论文 REALM: Retrieval-Augmented Language Model Pre-Training 在业界有很高的关注度,引用已经超过600次。

摘要

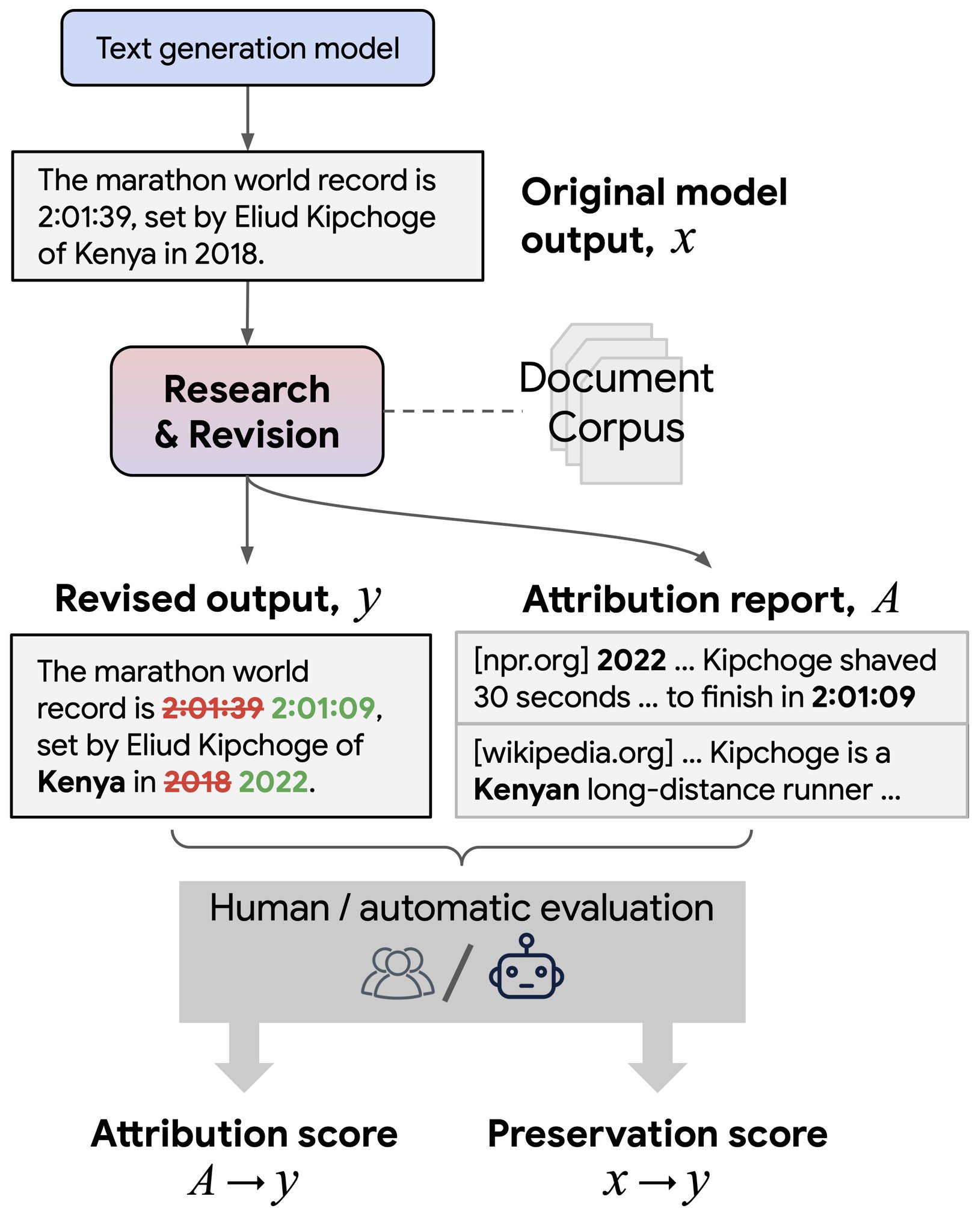

语言模型 (LM) 现在在许多任务中表现出色,例如小样本学习、问答、推理和对话。 但是,它们有时会生成未经验证或具有误导性的内容。 用户无法轻易确定输出是否可信,因为大多数语言没有任何内置机制来归因于外部证据。 为了在启用归因的同时仍然保留最新一代模型的所有强大优势,我们提出了 RARR(Retrofit Attribution using Research and Revision,使用研究和修订的改造归因),该系统 1) 自动为任何文本生成模型的输出找到出处,以及 2) 可以对输出再编辑,修改未经验证的内容,同时尽可能保留原始输出。 当应用于一组不同的生成任务的几个最先进语言模型的输出时,我们发现 RARR 显着改善了归因,同时在其他方面比以前探索的编辑模型更大程度地保留了原始输入。 此外,RARR 的实施只需要少量训练示例、一个大型语言模型和标准互联网搜索。

核心原理图如下:

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢