【标题】Is Policy Learning Overrated?: Width-Based Planning and Active Learning for Atari

【作者团队】Benjamin Ayton, Masataro Asai

【发表日期】2022.3.19

【论文链接】https://arxiv.org/pdf/2109.15310.pdf

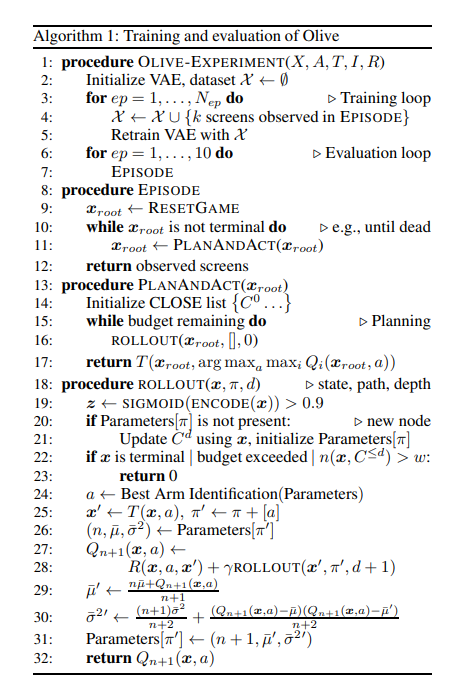

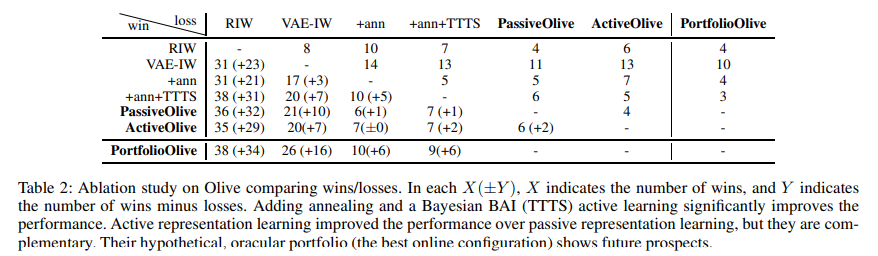

【推荐理由】基于宽度的规划在使用像素输入的Atari 2600游戏上显示了很有希望的结果,同时使用的环境交互比强化学习少得多。最近的基于宽度的方法已经使用手工设计的特征集或在游戏屏幕上训练的变分自动编码器(VAE-IW)来计算每个屏幕的特征向量,并在搜索期间修剪不具有新颖特征的屏幕。本文提出了Olive(在线VAE IW),它使用主动学习在线更新VAE功能,以最大化规划期间观察到的屏幕的效用。在55场Atari游戏中的实验结果表明,它比Rollout IW的表现要好42-11,比VAE-IW的成绩要好32-20。此外,Olive比基于策略学习(π-IW,DQN)的现有工作要好30-22和31-17,以及最先进的数据高效强化学习(EfficientZero),使用相同的训练预算进行训练,并在Atari 100k基准测试中以1.8倍的计划预算运行,完全没有策略学习。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢