【标题】Reinforcement Learning for Classical Planning: Viewing Heuristics as Dense Reward Generators

【作者团队】Clement Gehring, Masataro Asai, Rohan Chitnis, Tom Silver, Leslie Pack Kaelbling, Shirin Sohrabi, Michael Katz

【发表日期】2022.3.7

【论文链接】https://arxiv.org/pdf/2109.14830v2.pdf

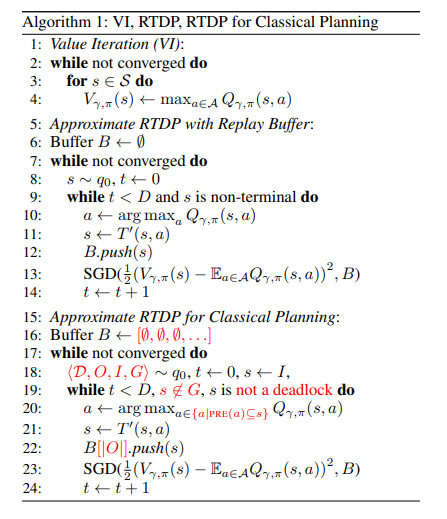

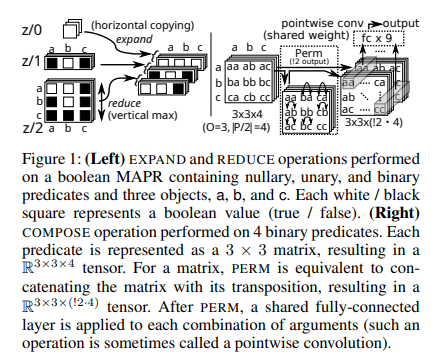

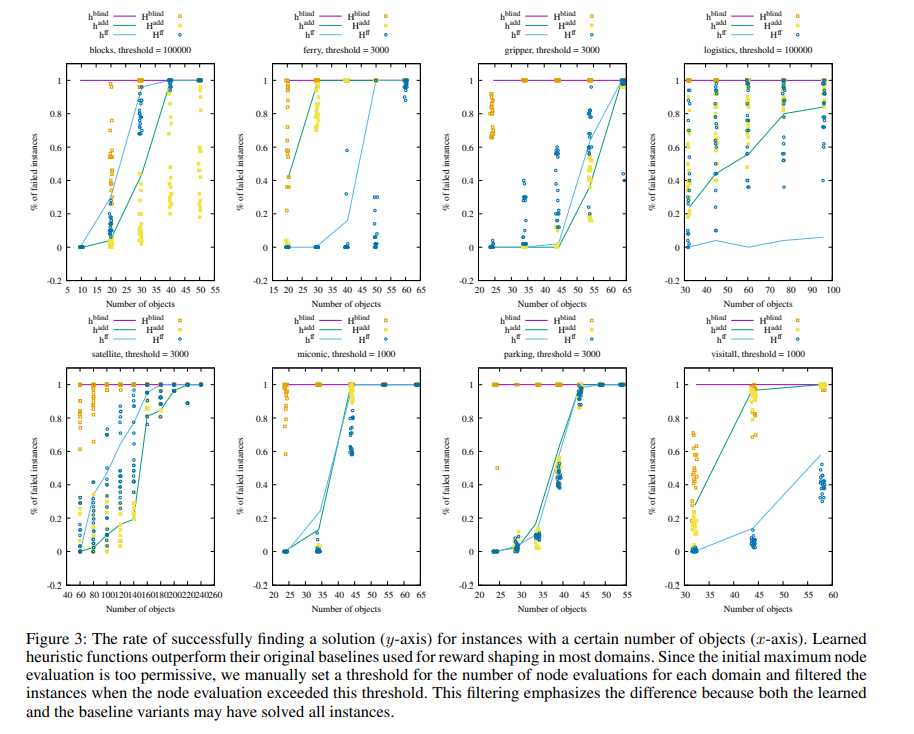

【推荐理由】强化学习(RL)的最新进展导致人们对将RL应用于经典规划领域或将经典规划方法应用于一些复杂的RL领域越来越感兴趣。然而,在经典规划中发现的基于长期目标的问题导致RL的回报很少,使得直接应用效率低下。本文提出利用经典规划文献中常用的领域无关启发式函数来提高RL的样本效率。这些经典启发式算法充当密集奖励生成器,以缓解稀疏奖励问题,并使RL智能体能够学习域特定值函数作为这些启发式算法的残差,从而使学习更容易。正确应用此技术需要合并RL中使用的折扣度量和启发式中使用的非折扣度量。通过使用神经逻辑机器(Neural Logic Machines)实现值函数,这是一种为接地一阶逻辑输入设计的神经网络架构。最后在几个经典规划域上证明,与稀疏奖励RL相比,使用经典启发式方法进行RL可以获得良好的样本效率。并进一步证明,该学习值函数推广到同一领域中的新问题实例。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢